Le monde de l'IA évolue à une vitesse vertigineuse. À peine avez-vous entendu parler d'un nouveau modèle que, l'instant d'après, il semble déjà dépassé. Pour quiconque essaie de construire quelque chose de concret avec l'IA, choisir le bon grand modèle de langage (LLM) peut ressembler moins à un choix stratégique qu'à une tentative de rattraper un train en marche.

Lorsque vous devez construire quelque chose de réel, il faut aller au-delà du battage médiatique et comprendre ce qui fonctionne vraiment. Deux des plus grands noms du moment sont Gemini de Google et Mistral AI. Ils viennent d'horizons très différents et ont des approches distinctes pour construire une IA puissante. Ce guide vous guidera à travers le débat Gemini vs Mistral, en comparant leurs performances, leurs coûts et leur pertinence pour un usage professionnel quotidien.

Gemini vs Mistral : Que sont Google Gemini et Mistral AI ?

Avant d'entrer dans les détails, faisons rapidement connaissance avec ces deux concurrents. Ce ne sont pas simplement des cerveaux d'IA interchangeables ; ils ont des histoires et des objectifs différents.

Google Gemini : le poids lourd

Gemini est le bébé de Google, et il bénéficie du soutien total de l'une des plus grandes entreprises technologiques du monde. C'est un modèle multimodal, ce qui est simplement une façon technique de dire qu'il a été conçu dès le départ pour comprendre à la fois le texte, le code, les images et la vidéo. Vous trouverez Gemini au cœur d'outils comme Gemini Advanced et intégré dans l'écosystème Google, de Workspace à la plateforme d'entreprise Vertex AI.

Le principal attrait de Gemini est sa dimension. Il a accès aux énormes ensembles de données de Google et montre une compétence impressionnante pour les tâches qui nécessitent un raisonnement complexe en plusieurs étapes. Il est conçu pour être une IA polyvalente capable de gérer à peu près tout ce que vous lui soumettez.

Mistral AI : le challenger

De l'autre côté, nous avons Mistral AI, une entreprise parisienne qui est devenue célèbre en se concentrant sur l'efficacité et les modèles open-source. Bien qu'ils proposent des modèles commerciaux payants, ils sont réputés pour leurs modèles à "poids ouverts" comme Mistral 7B et Mixtral. Cela signifie qu'ils publient les fichiers de base du modèle, permettant aux développeurs de les modifier, de les affiner et de les exécuter sur leurs propres serveurs.

Mistral s'est bâti une solide réputation auprès des développeurs en créant des modèles qui se montrent bien plus performants que leur catégorie de poids ne le laisserait supposer. Ils offrent de solides performances sans exiger un entrepôt rempli de GPU. Leurs réponses sont souvent décrites comme concises et directes, ce qui en fait un favori pour les flux de travail professionnels où vous avez juste besoin d'une réponse fiable, sans bavardage superflu.

Gemini vs Mistral : Performances et capacités

Alors, comment se comportent-ils réellement ? Le "meilleur" modèle dépend vraiment de ce que vous essayez d'accomplir. Une IA brillante pour rédiger un e-mail marketing créatif pourrait ne pas être la solution idéale pour générer du code propre et prêt pour la production.

Gemini vs Mistral : Raisonnement, précision et le "facteur superflu"

Passez cinq minutes sur n'importe quel forum de développeurs, et vous remarquerez un thème récurrent : les gens parlent beaucoup de l'ambiance des réponses. Les utilisateurs disent souvent que les modèles Mistral vont droit au but. Ils vous donnent une réponse sans les formules de politesse conversationnelles comme "C'est une excellente question !" ou autre remplissage qui peut parfois alourdir les réponses des plus grands modèles. Pour de nombreux usages professionnels, ce style direct et "sans fioritures" semble plus prévisible et digne de confiance.

Bien sûr, n'importe quel modèle peut "halluciner" ou inventer des choses, mais la concision de Mistral peut le rendre plus fiable pour les tâches simples. Gemini, en revanche, donne généralement des réponses plus détaillées et complètes. Cela peut être excellent pour le brainstorming ou lorsque vous avez besoin d'une analyse approfondie d'un sujet complexe, mais cela peut aussi signifier que vous devez lire plus de texte pour trouver la réponse essentielle.

Il est également important de se rappeler que les performances peuvent changer radicalement en fonction de la tâche. Par exemple, une comparaison directe sur la précision de l'OCR a révélé que Gemini Flash 2.0 était nettement plus précis que le modèle OCR de Mistral sur un ensemble varié de documents. C'est un bon rappel que les benchmarks publiés par les entreprises elles-mêmes ne reflètent pas toujours les performances en conditions réelles. Vous devez le tester par vous-même.

Points forts par tâche spécifique

Voyons comment ces modèles se débrouillent avec quelques tâches professionnelles courantes.

-

Codage : Les deux modèles sont assez pratiques pour générer du code. Cependant, vous trouverez de nombreux développeurs penchant vers Mistral pour les scénarios de production. Son résultat est souvent plus propre et plus cohérent, ce qui le rend plus facile à intégrer dans des flux de travail automatisés. Mistral propose également des modèles spécialisés comme Codestral, qui sont spécifiquement affinés pour le codage.

-

Rédaction et créativité : C'est là que Gemini brille souvent. Son style conversationnel et approfondi est bien adapté à l'écriture créative, au brainstorming de textes marketing et à la génération de textes qui semblent humains. Le ton par défaut de Mistral a tendance à être plus professionnel et factuel, ce qui est parfait pour les rapports ou les résumés, mais peut-être pas pour votre prochaine grande campagne publicitaire.

-

Analyse de documents et de données : Gemini a un avantage considérable ici en raison de sa fenêtre de contexte massive. La fenêtre de contexte est essentiellement la quantité d'informations que le modèle peut conserver dans sa mémoire à court terme à un moment donné. Avec Gemini 1.5 Pro capable de gérer jusqu'à 2 millions de jetons (soit environ 1,5 million de mots), il peut traiter des documents incroyablement longs, des bases de code entières ou des heures de vidéo. Les modèles de Mistral, comme Mistral Large avec sa fenêtre de 32 000 jetons, sont beaucoup plus limités sur ce point.

Un tableau de comparaison directe

Voici un résumé rapide de leurs différences qualitatives.

| Caractéristique | Google Gemini | Mistral AI | Gagnant |

|---|---|---|---|

| Style de réponse | Plus conversationnel et complet, peut être long. | Concis, direct et allant droit au but ; moins de "superflu". | Dépend du cas d'usage |

| Codage | Capacités de codage solides et polyvalentes. | Très apprécié pour la génération de code propre et stable ; modèles spécialisés. | Mistral (pour la production) |

| Tâches créatives | Souvent préféré pour le brainstorming et l'écriture de type humain. | Ton plus factuel et professionnel par défaut. | Gemini |

| Analyse de documents | Excellent en raison de sa fenêtre de contexte massive (jusqu'à 2M de jetons). | Limité par une fenêtre de contexte plus petite (ex: 32K de jetons). | Gemini |

| Confiance perçue | Peut parfois sembler trop prudent ou refuser les requêtes politiques. | La franchise est souvent perçue comme plus stable et fiable pour les entreprises. | Mistral (pour les entreprises) |

Gemini vs Mistral : Spécifications techniques et fonctionnalités

Pour quiconque construit réellement avec ces modèles, ce sont les détails techniques qui font toute la différence. Voici comment ils se comparent.

Familles de modèles et variantes

Google et Mistral proposent tous deux un menu de modèles conçus pour différents besoins, vous permettant d'équilibrer performance, vitesse et coût.

-

Gemini : Les deux principales options disponibles via leur API sont Gemini 1.5 Pro, leur modèle puissant et haut de gamme, et Gemini 1.5 Flash, qui est conçu pour la vitesse et l'efficacité dans les situations à haut volume.

-

Mistral : Leur gamme comporte plus de niveaux :

- Modèles à poids ouverts : Mistral 7B et Mixtral 8x7B sont des choix de prédilection pour les développeurs qui souhaitent héberger les modèles eux-mêmes ou les affiner avec leurs propres données.

- Modèles commerciaux : Mistral Small, Mistral Medium et Mistral Large 2 sont leurs modèles optimisés auxquels vous pouvez accéder via une API, offrant un bon équilibre entre prix et puissance.

- Modèles spécialisés : Ils développent également des modèles spécifiques comme Codestral, qui est entièrement axé sur la génération et la complétion de code.

Gemini vs Mistral : Fenêtre de contexte et date de coupure des connaissances

La fenêtre de contexte est l'une des plus grandes différences techniques entre eux. Comme nous l'avons mentionné, la capacité de Gemini 1.5 Pro à traiter jusqu'à 2 millions de jetons est un avantage énorme pour quiconque travaille avec de grands volumes d'informations. La fenêtre de 32 000 jetons de Mistral Large est toujours très utile, mais elle ne joue tout simplement pas dans la même catégorie.

Une autre chose à garder à l'esprit est la date de coupure des connaissances, qui est la date "d'expiration" des données d'entraînement du modèle. Certains modèles de Mistral ont des connaissances s'arrêtant à une date légèrement plus ancienne, mais cela devient de moins en moins un problème. Les deux entreprises proposent désormais des modèles capables d'effectuer des recherches web en direct pour vous fournir les informations les plus récentes.

API et écosystèmes pour développeurs

Les deux plateformes offrent une expérience assez fluide pour les développeurs. La plateforme Vertex AI de Google est une plateforme massive, prête pour l'entreprise, avec une vaste boîte à outils, de nombreuses intégrations et une documentation détaillée pour construire avec Gemini.

L'API de Mistral, qu'ils appellent "la Plateforme", reçoit beaucoup d'éloges pour sa simplicité et sa facilité d'utilisation, ce qui correspond à leur philosophie axée sur les développeurs. Elle est conçue pour être simple à prendre en main afin que vous puissiez être opérationnel rapidement.

Gemini vs Mistral : Tarification et application commerciale

En fin de compte, la décision se résume souvent à l'argent et à la valeur commerciale. Examinons comment leurs prix se comparent et comment vous pouvez réellement utiliser ces modèles dans votre entreprise sans embaucher toute une nouvelle équipe d'ingénieurs.

Une analyse des modèles de tarification

Les deux entreprises utilisent principalement un modèle de paiement par jeton pour leurs API. Vous êtes facturé pour la quantité de texte que vous envoyez au modèle (entrée) et la quantité de texte que le modèle renvoie (sortie).

- Gemini (via Vertex AI) : La tarification de Google est assez compétitive, en particulier pour son modèle rapide Flash.

Source : Page de tarification de Google Cloud

| Modèle | Prix d'entrée / 1M de jetons | Prix de sortie / 1M de jetons |

|---|---|---|

| Gemini 1.5 Pro | 3,50 $ | 10,50 $ |

| Gemini 1.5 Flash | 0,35 $ | 1,05 $ |

- Mistral : La tarification de l'API de Mistral est également compétitive, et leurs modèles plus petits et efficaces sont particulièrement économiques.

Source : Site web de Mistral AI

| Modèle | Prix d'entrée / 1M de jetons | Prix de sortie / 1M de jetons |

|---|---|---|

| Mistral Large 2 | 3,00 $ | 9,00 $ |

| Mistral Small | 0,50 $ | 1,50 $ |

| Codestral | 1,00 $ | 3,00 $ |

Mistral propose également un abonnement "Le Chat Pro" pour environ 15 $ par mois, destiné aux particuliers et aux petites équipes qui souhaitent utiliser leur chatbot sans avoir à manipuler l'API.

Appliquer les modèles d'IA dans votre entreprise : la méthode simple

Choisir un modèle et payer pour l'accès à l'API n'est que la première étape. Le vrai travail consiste à transformer cette puissance brute en un outil commercial utile, comme un agent de support client qui aide réellement les gens. Cela implique généralement beaucoup de configurations compliquées :

-

Vous devez connecter le modèle à toutes les connaissances de votre entreprise, qui peuvent être réparties entre un service d'assistance, des wikis internes, des Google Docs et d'anciennes conversations.

-

Vous devez construire un moteur de flux de travail qui sait quand faire remonter un ticket, comment l'étiqueter correctement, ou quand effectuer des actions personnalisées comme vérifier le statut d'une commande.

-

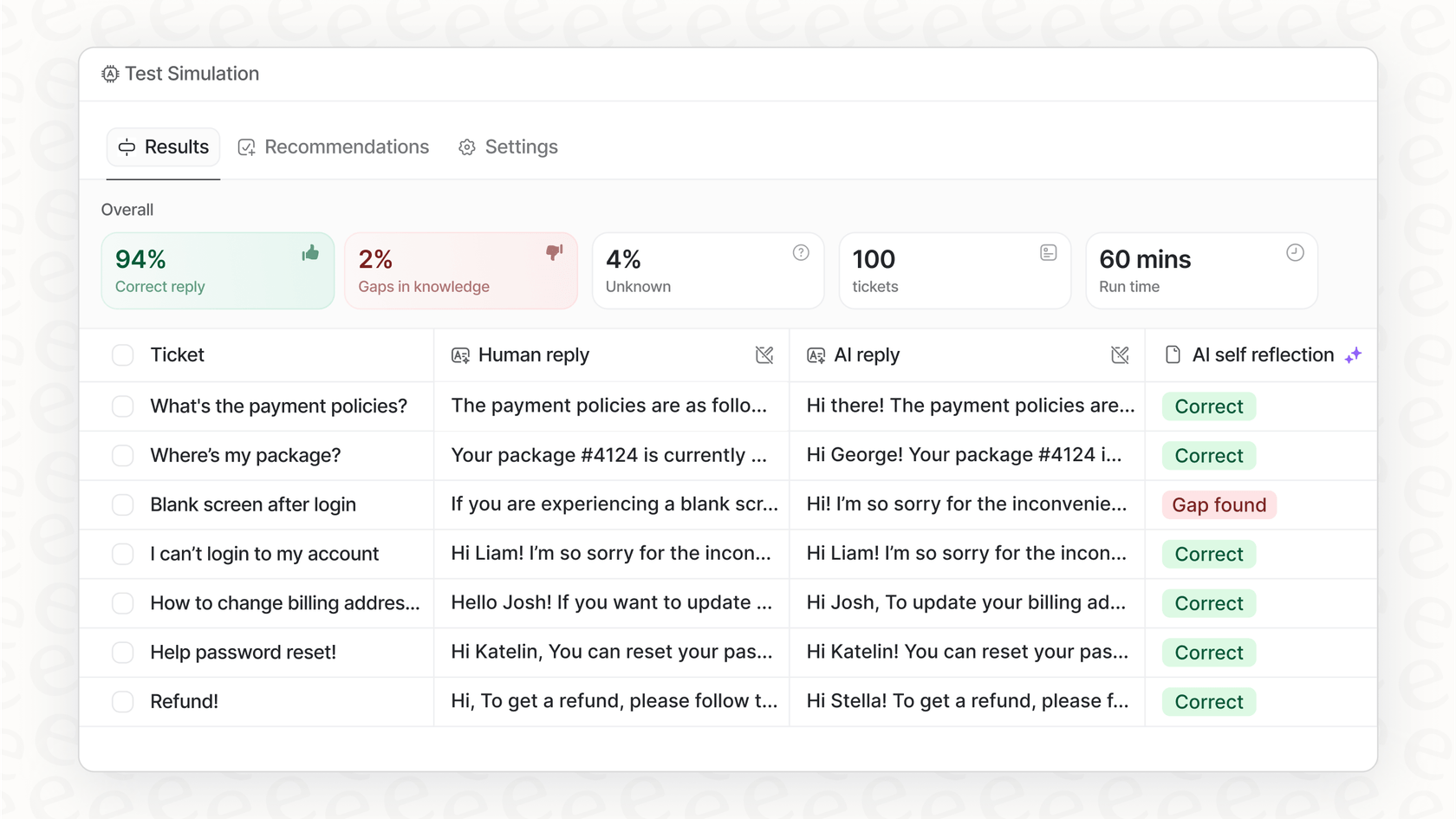

Vous avez besoin d'un moyen sûr de tout tester sur vos propres données avant de le laisser interagir avec un vrai client.

C'est une charge de travail énorme, et c'est exactement le problème qu'une plateforme comme eesel AI est conçue pour résoudre. Au lieu que vous passiez des mois à construire toute cette infrastructure à partir de zéro, eesel AI vous offre une solution en libre-service qui fait le gros du travail pour vous. Elle agit comme une couche intelligente au-dessus des modèles puissants de Google et Mistral, les rendant utiles pour votre entreprise dès la sortie de la boîte.

- Unification instantanée des connaissances : eesel AI se connecte à tous vos outils avec des intégrations en un clic pour des plateformes comme Zendesk et Confluence. Il apprend de votre centre d'aide, de vos documents et même de vos anciens tickets de support pour se familiariser avec votre entreprise dès le premier jour.

Faire le bon choix pour vos besoins

Alors, quel est le verdict final dans l'affrontement Gemini vs Mistral ? Honnêtement, il n'y a pas de gagnant unique. Tout dépend de ce que vous avez besoin de faire. Voici un aide-mémoire rapide :

-

Choisissez Gemini si votre tâche principale est d'analyser d'énormes documents ou ensembles de données, si vous êtes déjà intégré à l'écosystème Google Cloud, ou si vous avez besoin d'une écriture créative de premier ordre et de fonctionnalités multimodales.

-

Choisissez Mistral si vous vous souciez avant tout de l'efficacité, du coût et de la flexibilité des modèles open-source que vous pouvez héberger vous-même. C'est aussi probablement le meilleur choix si vous avez besoin d'une IA qui vous donne des réponses concises et professionnelles sans le superflu.

Le meilleur modèle est toujours celui qui correspond au travail que vous devez faire. Mais rappelez-vous, le modèle lui-même n'est qu'une pièce du puzzle. La vraie magie opère lorsque vous l'intégrez et l'utilisez dans vos flux de travail pour résoudre de vrais problèmes commerciaux.

Prêt à transformer la puissance de ces modèles d'IA de premier plan en résultats commerciaux concrets ? eesel AI vous offre la plateforme complète pour construire, simuler et lancer des agents d'IA pour le support client et la gestion des connaissances internes, le tout en quelques clics. Commencez votre essai gratuit dès aujourd'hui.

Cette vidéo propose un test comparatif utile pour voir comment Gemini et Mistral AI se comportent sur diverses tâches.

Foire aux questions

Les modèles Mistral sont souvent préférés pour leur franchise et leurs réponses "sans fioritures", ce qui les rend idéaux pour les flux de travail professionnels nécessitant des réponses fiables et concises, sans remplissage conversationnel superflu.

Gemini 1.5 Pro a un avantage clair ici en raison de sa fenêtre de contexte massive de 2 millions de jetons, lui permettant d'ingérer et d'analyser une quantité d'informations bien plus vaste que les offres actuelles de Mistral.

Les modèles plus petits et efficaces de Mistral offrent une tarification compétitive pour les tâches à haut volume. Le modèle 1.5 Flash de Gemini constitue également une option très rentable pour la vitesse et l'efficacité.

Mistral AI est réputé pour ses modèles à poids ouverts comme Mistral 7B et Mixtral, qui offrent aux développeurs la flexibilité d'héberger, de modifier et d'affiner les modèles sur leurs propres serveurs.

Gemini brille souvent dans les tâches créatives, offrant un style plus conversationnel et approfondi, adapté aux textes marketing, au brainstorming et à la génération de textes qui semblent nuancés et humains.

Bien que les deux proposent des API, l'intégration efficace de modèles comme Gemini ou Mistral nécessite souvent un développement important. Des plateformes comme eesel AI simplifient ce processus en fournissant une couche intelligente pour unifier les connaissances et lancer rapidement des agents d'IA, quel que soit le modèle sous-jacent.

Partager cet article

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.