Soyons honnêtes, l'IA générative ressemble un peu à de la magie. Vous tapez une invite, et quelques secondes plus tard, vous avez un e-mail, un morceau de code, ou même un site web entier. C'est fluide. Mais ce sentiment d'"effortless" cache un grand secret : la machine derrière le rideau est incroyablement gourmande en énergie, et son appétit grandit de façon exponentielle.

Avec l'arrivée de nouveaux modèles comme GPT-5 à l'horizon, les chercheurs commencent à tirer la sonnette d'alarme sur la quantité d'énergie que ces choses consomment. Ce n'est pas seulement un problème environnemental abstrait, cela devient rapidement un véritable problème commercial. Les coûts cachés de l'exploitation de ces modèles massifs, capables de tout faire, deviennent trop importants pour être ignorés.

Dans cet article, nous allons lever le voile sur le "quoi" et le "pourquoi" des besoins énergétiques de l'IA. Nous examinerons le véritable impact environnemental et vous montrerons une manière plus intelligente pour votre entreprise d'adopter l'IA de manière durable et bien plus efficace.

Quelle est la consommation d'énergie de ChatGPT ?

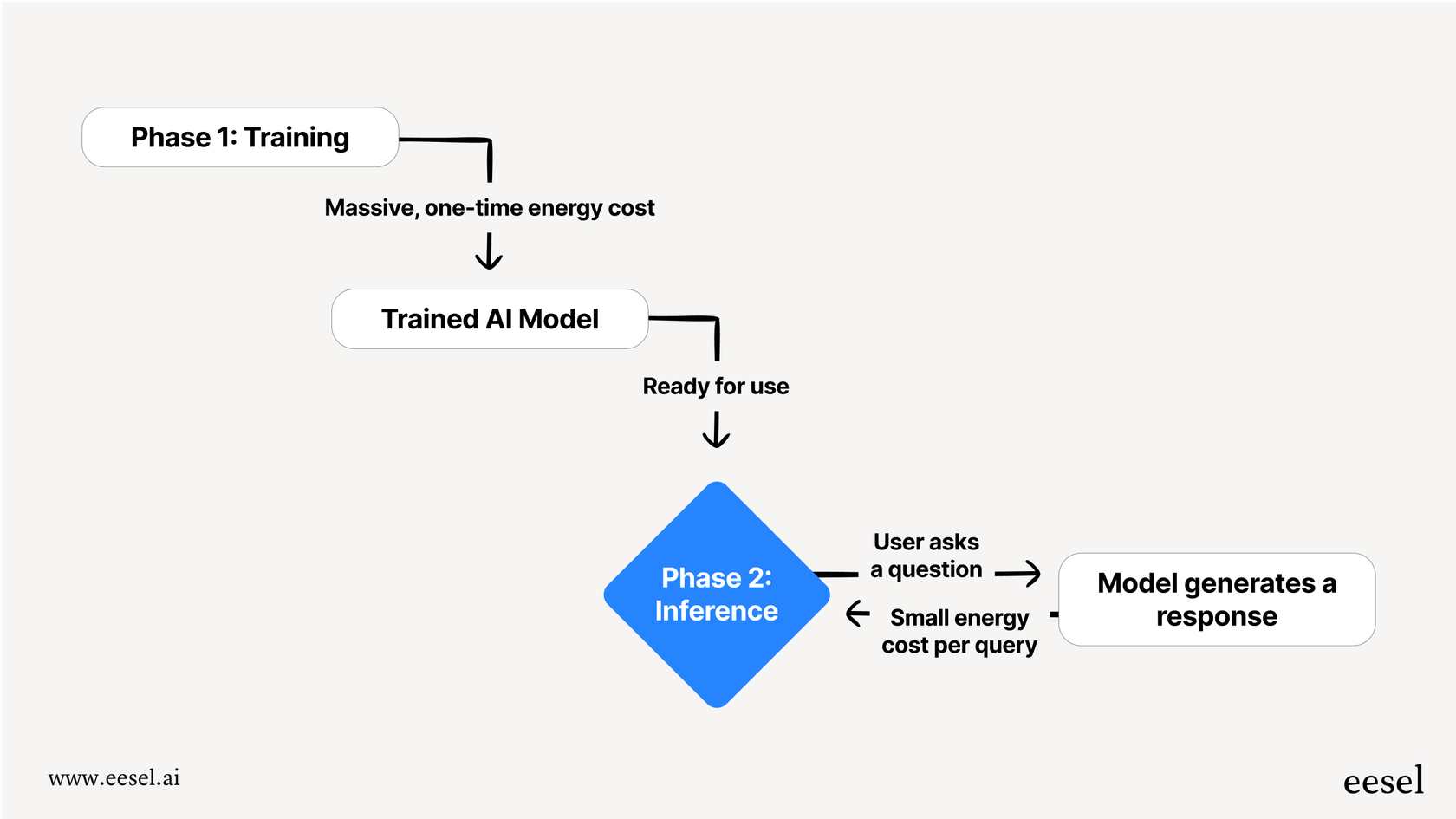

Quand on parle d'une IA qui consomme de l'énergie, ce n'est pas qu'une seule chose. Le processus est divisé en deux phases principales : l'entraînement et l'inférence. La façon la plus simple de le comprendre est de voir cela comme une IA allant à l'école, puis une IA allant réellement travailler.

Entraînement C'est la phase de "scolarisation" de l'IA, et elle est incroyablement intense. Elle consiste à alimenter un modèle avec une quantité colossale de données, souvent une énorme partie d'Internet, afin qu'il puisse apprendre des schémas, des langues et des concepts. Cela nécessite une énorme puissance de calcul fonctionnant 24h/24 et 7j/7 pendant des semaines, voire des mois. C'est un énorme coût énergétique unique qui doit être payé pour chaque nouvelle version d'un modèle.

Inférence L'inférence est ce qui se passe lorsque vous utilisez réellement l'IA, comme poser une question à ChatGPT. Le modèle utilise ce qu'il a appris pendant l'entraînement pour "inférer" la meilleure réponse. Bien qu'une seule requête utilise une infime fraction de l'énergie nécessaire à l'entraînement, c'est le volume qui est stupéfiant. Pour un outil traitant des milliards de requêtes par jour, l'énergie totale dépensée en inférence au cours de sa durée de vie peut facilement dépasser le coût initial de l'entraînement.

Un regard plus attentif sur la surprenante consommation d'énergie de ChatGPT

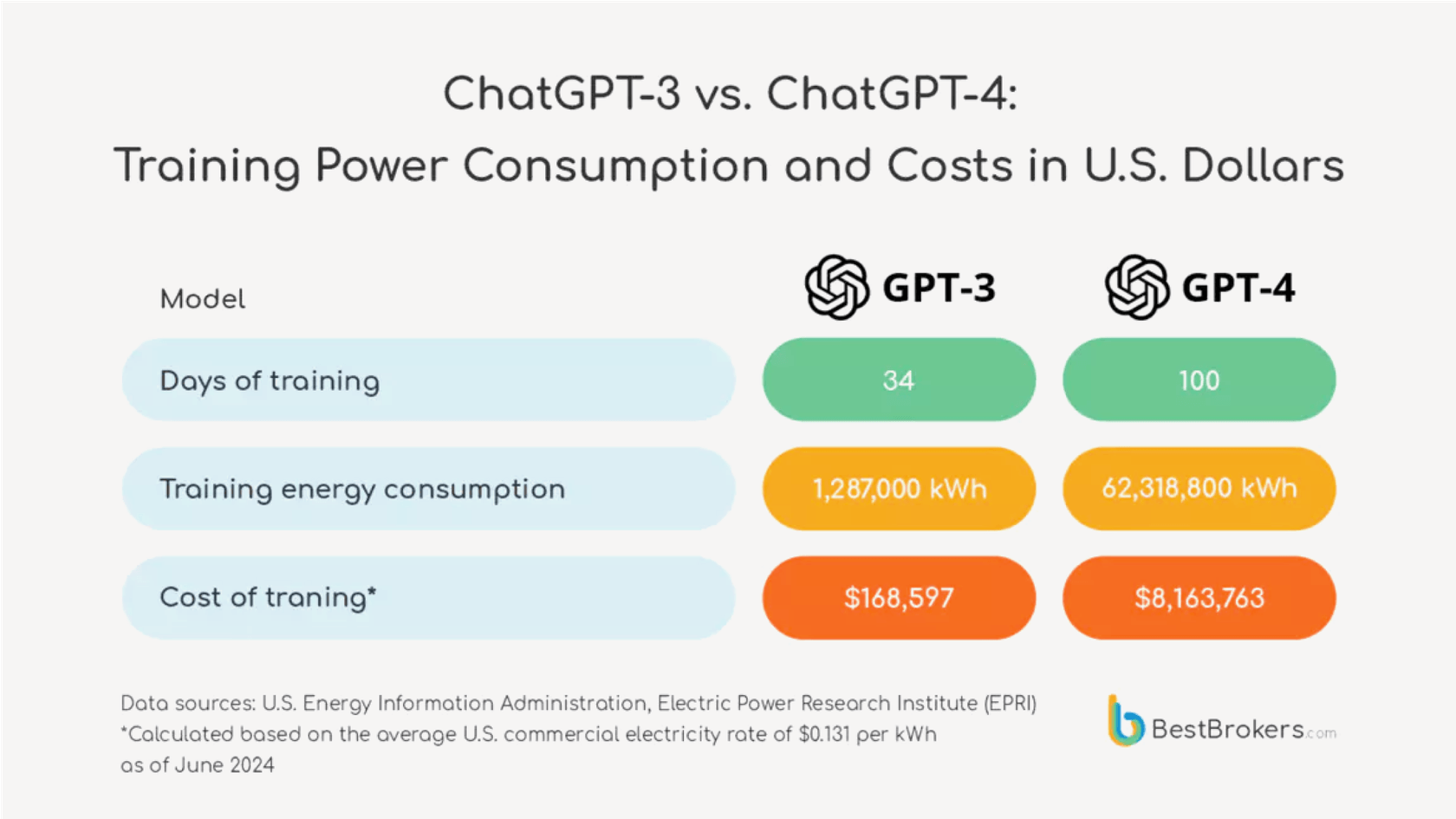

Le saut dans la demande énergétique d'une génération de modèle à l'autre n'est pas un petit pas en avant, c'est un bond géant.

Mettons quelques chiffres réels là-dessus. À la mi-2023, demander à un modèle comme ChatGPT une simple recette pouvait utiliser environ 2 watt-heures d'électricité. Maintenant, avançons vers le futur GPT-5. Les chercheurs du laboratoire d'IA de l'Université de Rhode Island estiment que le nouveau modèle pourrait utiliser en moyenne 18 watt-heures pour une réponse de longueur moyenne, et parfois jusqu'à 40 watt-heures.

Une comparaison visuelle côte à côte.

- À gauche, sous le titre "GPT-4 (2023)", une icône d'une petite ampoule avec le texte "2 Watt-heures par requête" à côté. En dessous, le texte indique : "Assez pour alimenter une ampoule pendant 2 minutes."

- À droite, sous le titre "GPT-5 (Estimé)", une icône d'une ampoule beaucoup plus grande et plus lumineuse avec le texte "18 Watt-heures par requête" à côté. En dessous, le texte indique : "Assez pour alimenter la même ampoule pendant 18 minutes."

- Une grande flèche pointant de gauche à droite montre une "augmentation de 9x" de la consommation d'énergie. Le design global doit être propre et facile à lire, soulignant l'augmentation drastique de la demande énergétique.

C'est une énorme augmentation. Cela montre que chaque nouvelle génération de ces modèles tout-en-un devient exponentiellement plus gourmande en énergie.

Pour vous donner un peu de perspective, 18 watt-heures suffisent à alimenter une ampoule à incandescence ancienne pendant 18 minutes. Maintenant, pensez à l'image plus large. ChatGPT traiterait environ 2,5 milliards de requêtes par jour. Si toutes étaient traitées par GPT-5, la consommation d'énergie quotidienne totale pourrait suffire à alimenter 1,5 million de foyers américains. Soudainement, cette réponse d'IA "sans effort" ne semble pas si gratuite, n'est-ce pas ?

| Version du Modèle | Énergie Moyenne par Requête (Watt-heures) | Équivalent Réel |

|---|---|---|

| Époque GPT-4 (2023) | ~2 Wh | Alimenter une ampoule à incandescence pendant 2 minutes |

| GPT-4o | ~0.34 Wh (chiffre d'Altman) | Une ampoule à haute efficacité pendant quelques minutes |

| GPT-5 (Estimé) | ~18 Wh | Alimenter une ampoule à incandescence pendant 18 minutes |

Secret et coûts cachés de la consommation d'énergie de ChatGPT

Essayer de déterminer le véritable coût environnemental de l'IA est une affaire étonnamment opaque, principalement parce que les entreprises qui construisent ces modèles sont incroyablement secrètes sur la quantité de ressources qu'elles utilisent.

Où sont les données officielles sur la consommation d'énergie de ChatGPT ?

OpenAI et ses concurrents n'ont pas publié de chiffres officiels, spécifiques aux modèles, sur l'énergie depuis la sortie de GPT-3 en 2020. Le PDG d'OpenAI, Sam Altman, a partagé sur son blog qu'une requête utilise environ 0.34 watt-heures, mais ces chiffres sont venus sans aucun contexte sur le modèle dont il parlait ou de données pour les étayer, les rendant pratiquement impossibles à vérifier.

Ce manque de transparence est un gros problème. Comme l'a souligné un expert en climat, "Cela me sidère que vous puissiez acheter une voiture et savoir combien de miles par gallon elle consomme, et pourtant nous utilisons tous ces outils d'IA tous les jours et nous n'avons absolument aucune métrique d'efficacité." Sans données claires, il est difficile pour toute entreprise de prendre une décision éclairée sur le véritable coût des outils qu'elle utilise.

Consommation d'énergie de ChatGPT : Il ne s'agit pas seulement d'électricité

Le prix environnemental va bien au-delà de la facture d'électricité. Il y a quelques autres coûts cachés qui ne sont pas suffisamment abordés.

- C'est un travail assoiffé : Les centres de données deviennent incroyablement chauds, et les refroidir nécessite une quantité choquante d'eau douce. L'entraînement de GPT-3 aurait utilisé plus de 700 000 litres d'eau. À mesure que les modèles grandissent, leur soif d'eau augmente, mettant une véritable pression sur les ressources locales.

- Matériel et déchets électroniques : L'IA générative fonctionne sur des processeurs spécialisés, gourmands en énergie (GPU). La fabrication de ces puces a son propre impact environnemental, depuis l'extraction des matières premières jusqu'à l'énergie utilisée pour les fabriquer. La course constante pour un matériel plus puissant signifie également que les puces plus anciennes sont mises de côté plus rapidement, ajoutant à un énorme problème de déchets électroniques.

- Construit pour être remplacé : Le monde de l'IA évolue à une vitesse fulgurante. De nouveaux modèles sont publiés tous les quelques mois, rendant les anciens obsolètes presque du jour au lendemain. Cela signifie que l'énorme quantité d'énergie investie dans l'entraînement d'un modèle qui est remplacé si rapidement est essentiellement gaspillée.

Une voie plus intelligente : Efficacité au-delà de la haute consommation d'énergie de ChatGPT

La stratégie actuelle de simplement construire des modèles d'IA généralistes de plus en plus grands est une approche de force brute. Elle n'est pas durable, et pour la plupart des entreprises, elle n'est même pas le meilleur outil pour le travail.

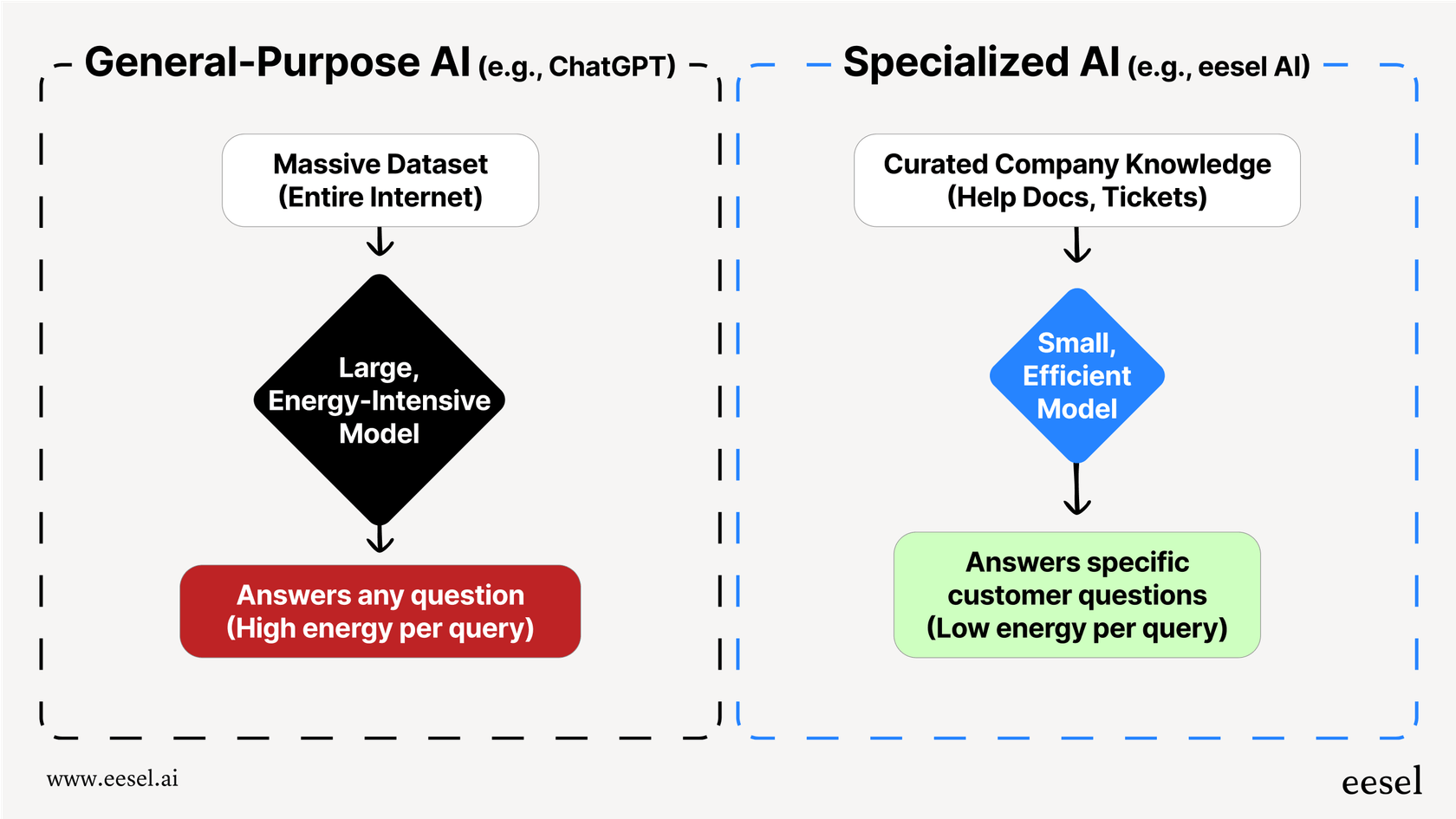

Le problème est que des modèles comme ChatGPT sont conçus pour connaître un peu de tout, des sonnets shakespeariens à la physique quantique. Pour cela, ils doivent être énormes, ce qui les rend incroyablement énergivores. Mais si vous avez juste besoin de répondre à une question d'un client sur votre politique d'expédition, utiliser une IA générale massive est complètement exagéré. C'est comme utiliser un superordinateur pour faire des calculs de base, ce n'est tout simplement pas efficace.

Il y a une manière beaucoup plus intelligente de faire cela : utiliser des modèles d'IA plus petits et spécialisés qui sont entraînés uniquement sur les données dont ils ont besoin pour faire leur travail. Cette approche est beaucoup plus efficace par conception. Entraîner une IA sur un ensemble de vos articles d'aide, anciens tickets de support et documents produits prend une infime fraction de l'énergie nécessaire pour l'entraîner sur l'ensemble d'Internet.

Le résultat n'est pas seulement une IA plus durable, c'est une meilleure IA. Une IA spécialisée donne des réponses plus précises, cohérentes et parfaitement alignées sur la marque car elle n'est pas distraite par des informations non pertinentes provenant de sites publics.

C'est toute l'idée derrière ce que nous faisons chez eesel AI. Au lieu de vous demander de remplacer vos systèmes existants par une seule IA gourmande en énergie, eesel se connecte directement à votre service d'assistance et à vos sources de connaissances. Elle apprend à partir de votre contenu dans les outils que vous utilisez déjà, comme Zendesk, Confluence, et Google Docs, pour créer un agent de support IA efficace et précis. Cela vous permet d'éviter la consommation massive d'énergie et les maux de tête opérationnels d'un modèle généraliste tout en fournissant de meilleures réponses, plus pertinentes, à vos clients.

Votre stratégie IA et l'impact de la consommation d'énergie de ChatGPT

La consommation d'énergie des grands modèles d'IA n'est plus seulement un sujet pour les chercheurs, c'est un véritable problème commercial. Avec chaque nouvelle génération, des modèles comme GPT-5 deviennent exponentiellement plus gourmands en énergie, et leur véritable coût est caché derrière un mur de secret et inclut bien plus que de l'électricité.

Pour la plupart des besoins commerciaux, notamment dans le service client ou le support interne, utiliser une IA géante et généraliste n'est pas le choix le plus efficace ou responsable. C'est inefficace, coûteux, et souvent moins précis pour votre cas d'utilisation spécifique.

Une approche spécialisée et intégrée est une alternative beaucoup plus durable, rentable et précise. En entraînant une IA sur votre propre connaissance, vous pouvez construire un système à la fois puissant et efficace.

Si vous êtes prêt à construire un système de support IA puissant et efficace sans la facture énergétique massive, découvrez comment eesel AI fonctionne avec vos outils existants pour fournir des réponses précises et alignées sur votre marque. Commencez un essai gratuit ou réservez une démo dès aujourd'hui.

Questions fréquemment posées

La forte demande en énergie signale une inefficacité. Utiliser un modèle massif et polyvalent pour une tâche commerciale spécifique, c'est comme utiliser un superordinateur pour des calculs simples, c'est exagéré et conduit souvent à des résultats moins précis et plus lents pour vos besoins spécifiques.

C'est bien plus que de l'électricité. L'empreinte environnementale totale inclut une consommation massive d'eau pour le refroidissement des centres de données, les ressources nécessaires pour fabriquer du matériel spécialisé, et un problème croissant de déchets électroniques à mesure que la technologie ancienne est rapidement remplacée.

Oui, l'augmentation est significative. Les estimations suggèrent que les nouveaux modèles peuvent être exponentiellement plus gourmands en énergie, certaines requêtes utilisant presque dix fois l'électricité des versions précédentes. Cette tendance du "plus c'est gros, mieux c'est" n'est pas durable.

Les grandes entreprises d'IA sont très secrètes sur leur consommation de ressources, la traitant comme un secret commercial. Ce manque de transparence rend difficile pour les entreprises et les consommateurs de comprendre les véritables coûts environnementaux et financiers des outils qu'ils utilisent.

Absolument. Un modèle spécialisé est formé uniquement sur les données pertinentes de votre entreprise, ce qui nécessite une infime fraction de l'énergie. Cela se traduit par un système beaucoup plus efficace qui est non seulement durable mais fournit également des réponses plus précises et pertinentes pour votre cas d'utilisation spécifique.

Bien que la formation soit incroyablement énergivore, le volume énorme de requêtes quotidiennes (inférence) peut facilement dépasser le coût initial de formation sur la durée de vie du modèle. Pour un outil avec des milliards d'utilisateurs quotidiens, l'énergie cumulative dépensée pour l'inférence devient le facteur dominant.

Partager cet article

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.