Un guide pratique de l'API d'exportation de données Ada : Limitations et alternatives

Kenneth Pangan

Katelin Teen

Last edited 10 octobre 2025

Expert Verified

Si vous souhaitez améliorer votre support client, analyser les données de vos conversations est l'un des meilleurs points de départ. Les informations précieuses cachées dans ces discussions peuvent vous aider à travailler plus intelligemment, à identifier les points de blocage pour vos clients et, au final, à les rendre plus satisfaits. La plupart des plateformes, y compris Ada, fournissent une API d'exportation de données pour extraire ces informations de leur système.

Mais voilà le problème : obtenir une montagne de données brutes n'est que la première étape. Le vrai travail consiste à trouver comment donner un sens à tout cela.

Ce guide vous offrira un aperçu direct de l'API d'exportation de données d'Ada. Nous verrons ce que c'est, comment vous pouvez l'utiliser et, plus important encore, les sérieuses limitations que vous devez connaître avant de commencer. Nous examinerons également une approche différente qui vous permet d'obtenir les informations dont vous avez besoin sans le casse-tête de construire un pipeline de données complet à partir de zéro.

Qu'est-ce que l'API d'exportation de données d'Ada ?

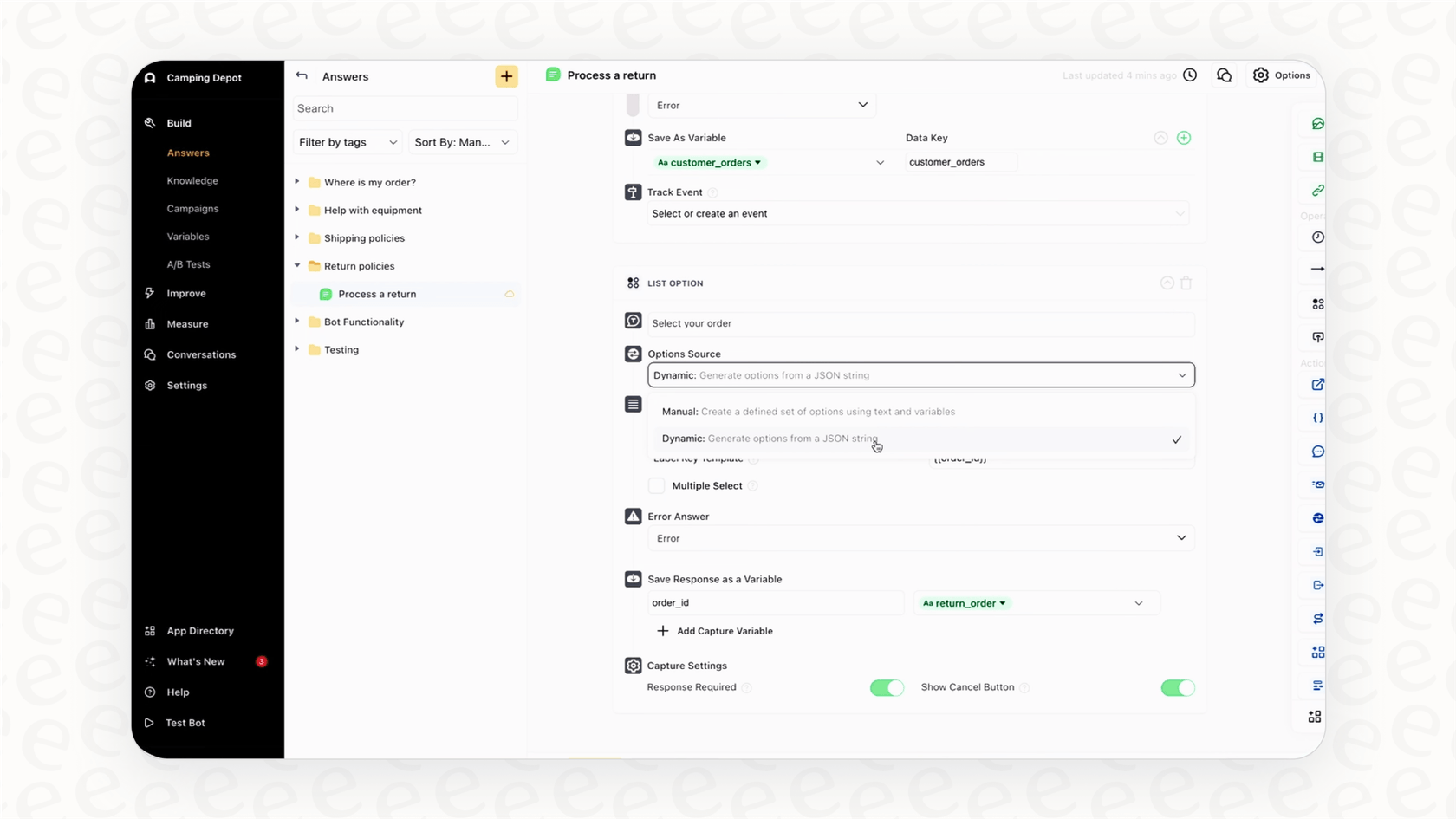

L'API d'exportation de données d'Ada est essentiellement un outil qui permet à votre équipe technique d'extraire par programmation les données de conversation et de message de votre chatbot Ada. Imaginez-le comme un conduit numérique qui vous permet de transférer vos journaux de discussion d'Ada vers vos propres bases de données ou outils d'analyse.

Selon la propre documentation d'Ada, les équipes l'utilisent généralement pour trois raisons principales :

-

Business Intelligence : Vous pouvez injecter les données dans des outils comme Tableau ou Power BI pour créer des rapports et des tableaux de bord personnalisés qui suivent les tendances du support.

-

Conformité : Pour les entreprises des secteurs réglementés, c'est un moyen de créer une archive interne de toutes les discussions avec les clients pour répondre aux règles de conservation des données.

-

Requêtes des clients : Elle vous permet d'extraire l'historique de conversation d'un utilisateur spécifique s'il demande ses données, ce qui est une exigence courante en vertu des lois sur la confidentialité comme le RGPD.

Sur le plan technique, c'est une API REST standard qui vous fournit des données au format JSON. Elle comporte deux parties principales (ou points de terminaison) : une pour obtenir des « Conversations » entières et une autre pour extraire les « Messages » individuels qu'elles contiennent. Une petite mise en garde : l'accès à l'API n'est pas toujours garanti. Vous devrez peut-être vérifier votre plan d'abonnement Ada, car elle peut parfois être un module complémentaire payant.

Comment démarrer avec l'API d'exportation de données d'Ada

En supposant que vous y ayez accès, la mise en route est assez simple. Il vous suffit de générer une clé API et de faire votre première requête. Mais comme vous le verrez bientôt, ce n'est pas la configuration qui est compliquée, ce sont les limitations qui peuvent causer de réels problèmes par la suite.

Générer votre clé API d'exportation de données d'Ada

Pour commencer, vous avez besoin d'une clé API pour prouver à Ada que vous êtes autorisé à demander des données. Seuls les administrateurs de compte peuvent en créer une.

-

Connectez-vous à votre tableau de bord Ada et allez dans Paramètres > Intégrations > APIs.

-

Cliquez sur Nouvelle clé API. Si vous n'en avez jamais créé auparavant, ce bouton pourrait indiquer « Commencer ».

-

Donnez à la clé un nom que vous reconnaîtrez plus tard, quelque chose comme « Clé-Exportation-Entrepôt-Données ».

-

Cliquez sur Générer la clé. Ada ne vous montre la clé qu'une seule fois, alors copiez-la immédiatement et stockez-la dans un endroit sécurisé, comme un gestionnaire de mots de passe d'équipe.

Lorsque vous ferez une requête, vous inclurez cette clé dans l'en-tête, formatée comme ceci : « Authorization: Bearer ».

Comprendre les contraintes et limitations clés de l'API d'exportation de données d'Ada

Bien, passons maintenant aux choses sérieuses. Bien que l'API vous donne un moyen d'accéder à vos données, elle est assortie de conditions importantes qui peuvent rendre une analyse opportune et utile très compliquée. Avant d'assigner un ingénieur à ce projet, vous devez savoir dans quoi vous vous engagez.

Les données ont toujours 24 à 48 heures de retard

Les nouvelles données de conversation mettent un à deux jours complets pour apparaître dans l'API. Cela signifie que vous ne regardez jamais ce qui se passe en ce moment. Si un nouveau bug provoque soudainement une avalanche de tickets de support, vous n'en verrez aucune trace dans vos exportations de données avant 48 heures. À ce moment-là, le mal est déjà fait. La surveillance en temps réel est totalement impossible.

Les limites de taux vous ralentiront

L'API vous limite à seulement trois requêtes par seconde pour chaque point de terminaison. Cela peut sembler suffisant, mais si vous avez un volume élevé de conversations, essayer de tout exporter devient incroyablement lent. Vos développeurs devront créer des scripts compliqués qui marquent soigneusement une pause entre les requêtes pour éviter d'être bloqués, transformant une simple exportation en un processus long et fastidieux.

Vous ne pouvez interroger qu'une fenêtre de 60 jours à la fois

Une seule requête ne peut pas couvrir plus d'une période de 60 jours. Vous voulez analyser les tendances de l'année dernière ? Vous devrez faire au moins six requêtes distinctes, puis trouver un moyen de rassembler toutes ces données vous-même. C'est une autre étape manuelle qui ajoute de la complexité et un risque d'erreurs.

Vous ne pouvez accéder qu'aux données des 12 derniers mois

L'API ne vous donnera aucune donnée de plus d'un an. Cela rend impossible toute analyse à long terme, d'une année sur l'autre. Si vous essayez de faire une planification stratégique approfondie ou de répondre à un audit de conformité pluriannuel, vous êtes dans une impasse.

Vous êtes limité à 10 000 enregistrements par requête

Chaque appel API, ou « page », ne peut retourner qu'un maximum de 10 000 enregistrements. Si vous avez des millions de conversations dans votre historique, vous devrez gérer des centaines, voire des milliers, de requêtes individuelles juste pour obtenir un ensemble de données complet.

Ce ne sont pas de simples obstacles techniques mineurs. Ils limitent fondamentalement ce que vous pouvez faire. Le simple délai des données signifie que vous êtes toujours en train de rattraper votre retard, réagissant aux problèmes bien après qu'ils aient commencé.

Le défi : transformer les données brutes en informations réelles

Obtenir un fichier JSON massif d'une API est une chose. Le faire parler pour en tirer des informations utiles en est une autre. L'exportation des données n'est que la première étape d'un parcours long et souvent coûteux.

Voici à quoi ressemble généralement ce processus dans le monde réel :

-

Écrire et maintenir des scripts : Un ingénieur de votre équipe doit écrire du code pour gérer la clé API, effectuer les appels et gérer soigneusement toute la pagination et les limites de taux dont nous venons de parler. Ce n'est pas une tâche ponctuelle. Le script devra être mis à jour et maintenu à chaque fois qu'Ada modifie son API.

-

Construire un processus ETL : Ensuite, ces données JSON brutes doivent être Extraites, Transformées dans un format propre et structuré (comme des tables dans une base de données), et Chargées (Load) dans un entrepôt de données comme Snowflake ou BigQuery. C'est un ensemble de compétences spécialisées.

-

Nettoyer et modéliser les données : Les données brutes sont presque toujours désordonnées. Un analyste de données doit ensuite passer du temps à les nettoyer et à construire des modèles de données pour qu'elles puissent être utilisées pour l'analyse.

-

Enfin, analyser et visualiser : Après tout cela, vous pouvez connecter un outil de BI à votre entrepôt et commencer à construire les tableaux de bord que vous vouliez depuis le tout début.

graph TD A[API d'exportation de données d'Ada] --> B{Écrire & maintenir des scripts}; B --> C[Extraire les données JSON brutes]; C --> D{Processus ETL}; D -- Transformer --> E[Structurer les données en tables]; E -- Charger --> F[Entrepôt de données (ex: Snowflake)]; F --> G{Nettoyer & modéliser les données}; G --> H[Connecter un outil de BI (ex: Tableau)]; H --> I[Analyser & visualiser les informations];

Et après tous ces efforts, vous pourriez découvrir qu'il manque aux données la seule chose dont vous avez vraiment besoin. Par exemple, un utilisateur sur un forum communautaire de Fivetran s'est plaint que des informations critiques comme la « classification de résolution automatisée » n'étaient même pas incluses dans son exportation de données Ada. Cela signifie que vous obtenez les transcriptions de discussion, mais pas le contexte pour savoir si le bot a réellement résolu le problème du client.

Alors, cela soulève la question : et si vous pouviez simplement sauter tout ça ?

Une meilleure approche : des données en différé à l'action instantanée

Au lieu de passer des semaines ou des mois à mettre en place un pipeline de données fastidieux, vous pouvez utiliser une plateforme qui intègre directement les analyses et les prévisions dont vous avez besoin dans votre flux de travail. Un outil comme eesel AI se connecte directement à votre service d'assistance, que ce soit Zendesk ou Freshdesk, et à vos sources de connaissances. Il vous donne les informations dont vous avez besoin en quelques minutes, pas en quelques mois.

Obtenez des informations immédiates avec des rapports exploitables

Alors que l'API d'exportation de données d'Ada vous fait attendre jusqu'à 48 heures, le tableau de bord analytique d'eesel AI vous offre une vue en direct de vos opérations de support. Vous pouvez suivre des indicateurs tels que les taux d'automatisation et les performances de l'assistance aux agents, et repérer les tendances dès qu'elles apparaissent.

Mais ce n'est pas tout. eesel AI ne se contente pas de vous lancer des graphiques. Il analyse automatiquement les conversations où l'IA n'a pas pu trouver de réponse et identifie les lacunes dans votre base de connaissances. Cela vous donne une liste claire et priorisée d'articles d'aide à rédiger en fonction de ce que vos clients demandent réellement. Vous pouvez arrêter de deviner quel contenu créer et commencer à rédiger des articles que vous savez pertinents pour réduire votre nombre de tickets.

Prévoyez les performances avec une simulation puissante

L'analyse des données passées est utile, mais pouvoir prédire avec précision les performances futures est un avantage considérable. Le mode simulation d'eesel AI vous permet de tester votre agent IA sur des milliers de vos tickets historiques réels dans un environnement totalement sûr.

Avant même que l'IA ne parle à un vrai client, vous pouvez voir exactement comment elle aurait traité les problèmes passés. Cela vous donne une prévision basée sur des données de votre taux de résolution attendu et des économies de coûts potentielles. C'est un moyen sans risque de renforcer la confiance, d'ajuster les réponses de votre IA et de transformer le processus réactif d'analyse des données en une stratégie proactive pour s'améliorer.

Arrêtez d'exporter, commencez à améliorer

L'API d'exportation de données d'Ada est un outil fonctionnel si tout ce dont vous avez besoin sont des journaux de conversation bruts. Mais ses limitations majeures, comme les délais de données et les limites de taux, combinées à l'énorme travail d'ingénierie nécessaire pour rendre les données utiles, en font un moyen lent et coûteux d'obtenir des réponses.

Les plateformes d'IA modernes comme eesel AI offrent une voie bien plus intelligente. En intégrant l'analyse et la simulation directement dans votre flux de travail de support, elles vous permettent de vous concentrer sur l'amélioration continue, et non sur la manipulation manuelle des données. Vous obtenez les informations dont vous avez besoin instantanément, sans toute la surcharge de travail.

Prêt à obtenir des réponses de vos données de support sans le casse-tête technique ? Essayez eesel AI gratuitement et découvrez comment vous pouvez commencer à améliorer vos opérations de support en quelques minutes.

Foire aux questions

L'API d'exportation de données d'Ada permet à votre équipe technique d'extraire par programmation les données brutes de conversation et de message de votre chatbot Ada. Elle est généralement utilisée pour l'intelligence économique, l'archivage à des fins de conformité et pour répondre aux demandes de données des clients.

Les données de l'API d'exportation de données d'Ada ne sont pas en temps réel ; elles ont toujours entre 24 et 48 heures de retard. Cela signifie que vous ne pouvez pas surveiller les événements actuels ni réagir aux problèmes immédiats au moment où ils se produisent.

Les limitations clés incluent un délai de données de 24 à 48 heures, des limites de taux strictes de trois requêtes par seconde, et une fenêtre de requête maximale de 60 jours. De plus, vous ne pouvez accéder qu'aux données des 12 derniers mois, et chaque requête est plafonnée à 10 000 enregistrements.

Oui, l'API d'exportation de données d'Ada ne donne accès qu'aux données des 12 derniers mois. Cela signifie que vous ne pouvez pas effectuer d'analyse d'une année sur l'autre ni accéder à des enregistrements plus anciens pour la planification stratégique à long terme ou pour des besoins de conformité.

Après l'exportation, vous devrez écrire et maintenir des scripts personnalisés, construire un processus ETL (Extraire, Transformer, Charger) pour déplacer les données dans un entrepôt, puis nettoyer et modéliser les données. Ce n'est qu'après cela que vous pourrez connecter un outil de BI pour créer des rapports et des tableaux de bord.

Oui, des plateformes comme eesel AI offrent une approche plus intégrée, se connectant directement à votre service d'assistance et à vos sources de connaissances. Elles fournissent des analyses immédiates, des rapports exploitables et des capacités de simulation sans nécessiter le développement d'un pipeline de données complexe.

Partager cet article

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.