Si eres desarrollador, probablemente hayas visto lo que pueden hacer modelos como GPT-4o y hayas pensado en construir algo con ellos. El punto de entrada principal es la API de OpenAI, pero trabajar directamente con ella implica escribir muchas solicitudes HTTP repetitivas. Ahí es donde entran en juego los SDKs (Kits de Desarrollo de Software) de OpenAI. Básicamente, son conjuntos de herramientas para diferentes lenguajes de programación que facilitan enormemente las llamadas a la API.

Pero aquí está el detalle: aunque los SDKs son geniales para empezar, construir una aplicación completa y lista para producción para algo como atención al cliente es un mundo aparte. No se trata solo de hacer unas cuantas llamadas a la API. Tienes que pensar en el historial de la conversación, obtener datos de diferentes fuentes y realizar un montón de pruebas. Todo eso suma mucho tiempo de ingeniería. Así que, vamos a ver qué son los SDKs de OpenAI, qué puedes hacer con ellos y algunas de las complejidades del mundo real que debes tener en cuenta. También exploraremos una forma de poner en marcha potentes agentes de IA mucho más rápido.

¿Qué son los SDKs de OpenAI?

En esencia, la API de OpenAI es un servicio RESTful con el que te comunicas a través de HTTP. Podrías construir esas solicitudes tú mismo, pero es un engorro y es fácil cometer errores. Los SDKs de OpenAI son bibliotecas oficiales que hacen el trabajo pesado por ti. Te proporcionan funciones y clases sencillas para usar la API directamente desde tu lenguaje de programación favorito.

Piensa en un SDK como un "wrapper" amigable. En lugar de preocuparte por los detalles de las cabeceras de autenticación, el formato de las solicitudes y el análisis de las respuestas, simplemente puedes hacer una llamada de función directa como "client.responses.create()".

OpenAI tiene SDKs oficiales para varios lenguajes populares:

-

Python: La opción preferida para la mayoría de los trabajos de IA y aprendizaje automático.

-

TypeScript / JavaScript (Node.js): Perfecto para aplicaciones web y servicios de backend.

-

.NET: Para cualquiera que trabaje en el mundo de C# y Microsoft.

-

Java: Una opción sólida para aplicaciones más grandes de estilo empresarial.

-

Go: Genial si necesitas velocidad y una buena concurrencia.

Y si tu lenguaje de preferencia no está en esa lista, es probable que la comunidad haya creado una biblioteca para él. La idea general es siempre la misma: instala el SDK, obtén tu clave de API secreta desde tu panel de OpenAI y podrás empezar a llamar a los modelos desde tu código.

Características clave y casos de uso de los SDKs de OpenAI

Una vez que estés listo, los SDKs te abren la puerta a un montón de capacidades diferentes. Estas son las principales cosas que la gente construye con ellos.

Generación de texto y respuestas

Este es el pan de cada día. Usando el endpoint responses.create, puedes enviar un prompt a un modelo como "gpt-4o" y obtener una respuesta en texto. Esta es la base para todo, desde un simple generador de contenido hasta un chatbot conversacional completo. Para dar contexto al modelo, puedes pasar una serie de mensajes en tu solicitud, lo que le ayuda a seguir el hilo de la conversación.

Multimodalidad (análisis de imágenes, audio y archivos)

Los modelos más nuevos como GPT-4o no se limitan solo al texto; son multimodales. Los SDKs de OpenAI te permiten incluir diferentes tipos de contenido en tus prompts:

-

Imágenes: Puedes pasar la URL de una imagen o subir una directamente y pedirle al modelo que te diga qué hay en ella, que responda preguntas sobre ella o incluso que extraiga texto de la misma.

-

Audio: Los modelos pueden transcribir archivos de audio a texto.

-

Archivos: Puedes subir documentos como PDFs y hacer que el modelo los resuma o responda preguntas basadas en su contenido.

Ampliación de modelos con herramientas (llamada a funciones)

Aquí es donde las cosas se ponen realmente interesantes. La función de "herramientas" (que antes se llamaba llamada a funciones) te permite dar al modelo un conjunto de funciones personalizadas que puede solicitar usar. Por ejemplo, podrías definir una función llamada get_weather. Si un usuario pregunta, "¿Qué tiempo hace en París?", el modelo no se inventará algo. Devolverá un objeto JSON diciendo que quiere llamar a tu función get_weather con el parámetro location: "Paris".

Tu código entonces ejecuta la función, obtiene los datos meteorológicos reales y devuelve esa información al modelo. El modelo utiliza estos datos para dar al usuario una respuesta que suene natural. Así es como se construyen aplicaciones que pueden interactuar con el mundo exterior.

Código del gráfico Mermaid graph TD; A[User asks: "What's the weather in Paris?"] --> B{Model receives prompt}; B --> C{Model identifies need for a tool}; C --> D[Model returns JSON to call 'get_weather(location: "Paris")']; D --> E[Your code executes the 'get_weather' function]; E --> F[External API provides weather data]; F --> G[Your code sends data back to the model]; G --> H{Model uses data to generate a response}; H --> I[Model replies: "The weather in Paris is sunny..."];

Un consejo rápido: aunque puedes construir tus propias llamadas a funciones para buscar datos de pedidos en tu base de datos, tienes que construir y alojar toda esa lógica de backend tú mismo. Una alternativa es una plataforma como eesel AI, que te ofrece Acciones de IA predefinidas y un constructor visual de flujos de trabajo. Puedes conectarte a herramientas como Shopify o bases de datos internas sin escribir toda la fontanería desde cero, ahorrando un montón de tiempo de desarrollo.

Construyendo agentes avanzados con el SDK de Agentes

Para tareas más complejas, OpenAI tiene un SDK de Agentes especializado. Sirve para construir aplicaciones "agénticas", donde una IA puede abordar problemas de varios pasos e incluso coordinarse con otros agentes de IA. Es algo muy potente, pero también supone un gran salto en complejidad.

El SDK de Agentes se basa en algunas ideas principales:

-

Agentes: Un LLM que tiene instrucciones específicas y un conjunto de herramientas con funciones que puede usar.

-

Transferencias (Handoffs): Esto permite que un agente pase una tarea a otro agente más especializado. Piensa en un agente de triaje general que transfiere un informe de error a un agente de soporte técnico.

-

Barandillas de seguridad (Guardrails): Son reglas que estableces para verificar el trabajo de un agente, asegurándote de que se mantenga en el tema y no se desvíe.

-

Sesiones: El SDK gestiona automáticamente el historial de la conversación por ti, incluso cuando las tareas se pasan entre diferentes agentes.

Usar el SDK de Agentes te permite crear una lógica bastante sofisticada en Python o TypeScript. Pero es una herramienta de muy bajo nivel. Construir algo lo suficientemente fiable para una empresa requiere una comprensión profunda del diseño de agentes y una ingeniería de software sólida.

Código del gráfico Mermaid graph TD; A[User: "My order #123 is delayed and I want to report a bug."] --> B(Triage Agent); B --> C{Task requires two actions}; C -- Handoff --> D(Order Status Agent); D --> E[Checks order database]; E --> F[Provides user with shipping update]; C -- Handoff --> G(Bug Report Agent); G --> H[Collects technical details from user]; H --> I[Creates Jira ticket]; I --> J(Guardrail Checks); J --> K[Final confirmation to user];

Aquí es realmente donde una plataforma especialmente diseñada resulta útil. Montar un sistema de soporte multiagente por tu cuenta es una tarea enorme. Para necesidades empresariales como el servicio al cliente, un enfoque de plataforma es casi siempre más rápido y fácil de escalar. Por ejemplo, eesel AI te ofrece un motor de flujo de trabajo totalmente personalizable. Puedes definir cómo deben comportarse tus agentes de IA, configurar escalaciones (que son como las transferencias) y elegir tus fuentes de conocimiento desde un panel de control sencillo. Esto te permite empezar a funcionar en minutos, no en meses.

Los costes ocultos y los desafíos de usar los SDKs de OpenAI

Los SDKs hacen que parezca fácil empezar, pero el camino desde un simple script hasta una aplicación en producción tiene algunos baches y costes ocultos que deberías conocer.

Entendiendo los precios de la API

El sistema de precios de OpenAI es principalmente de pago por uso, basado en "tokens" (que son aproximadamente partes de palabras). Pagas por los tokens que envías en tu prompt (entrada) y por los tokens que el modelo devuelve (salida). Estos costes pueden acumularse sin que te des cuenta, especialmente si envías prompts largos o gestionas muchas conversaciones.

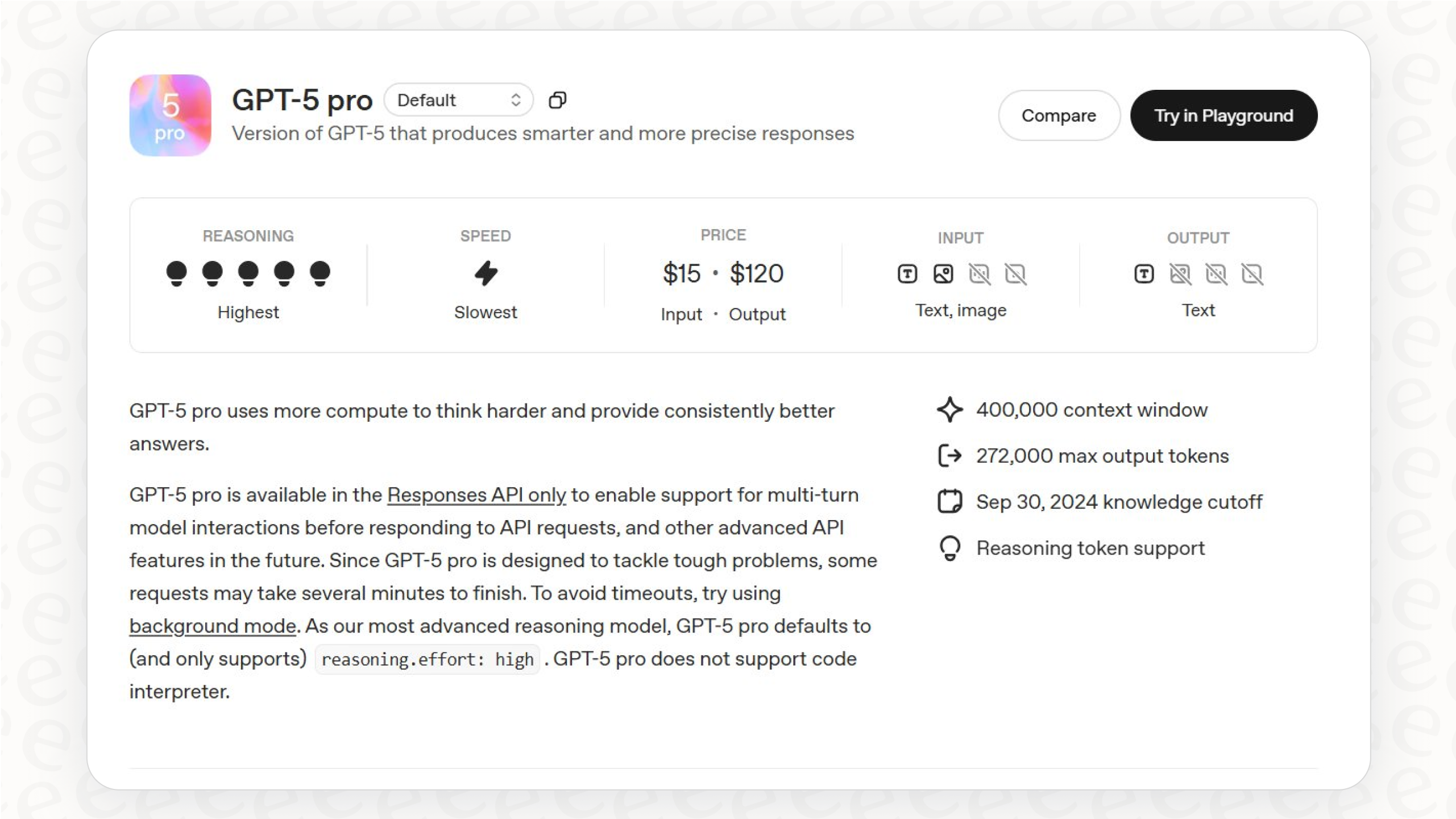

Aquí tienes un vistazo rápido a los precios estándar de algunos modelos (por cada millón de tokens, a finales de 2025):

| Modelo | Entrada (por 1M de tokens) | Salida (por 1M de tokens) |

|---|---|---|

| gpt-4o | $2.50 | $10.00 |

| gpt-4o-mini | $0.15 | $0.60 |

| gpt-4.1 | $2.00 | $8.00 |

| gpt-5-mini | $0.25 | $2.00 |

Fuente: Precios de OpenAI. Los precios son para el nivel estándar y pueden cambiar.

Y no son solo los modelos. Otras funciones también tienen costes:

-

Herramientas: Usar herramientas integradas como el Intérprete de Código o la Búsqueda de Archivos añade tarifas adicionales por sesión o basadas en el almacenamiento.

-

Ajuste Fino (Fine-Tuning): Si entrenas un modelo personalizado, pagarás por el proceso de entrenamiento y por usar el modelo.

Este sistema de precios por token puede hacer que tu factura mensual sea impredecible, lo cual no es ideal para presupuestar. En cambio, servicios como eesel AI ofrecen precios claros y predecibles basados en un número fijo de interacciones de IA. Sabes exactamente por lo que estás pagando, lo que facilita mucho la previsión de costes.

La sobrecarga de ingeniería de construir una solución completa

Una llamada a la API es solo una pequeña parte de una aplicación real. Un agente de soporte de IA verdaderamente útil necesita una gran infraestructura detrás, y toda ella tienes que construirla y mantenerla.

-

Gestión del Conocimiento (RAG): Para que una IA responda preguntas con precisión, necesita contexto de los documentos de tu empresa. Tendrás que construir un sistema de Generación Aumentada por Recuperación (RAG). Esto implica dividir tus documentos, crear embeddings, configurar una base de datos vectorial y construir una forma de recuperar la información correcta.

-

Integraciones: Tu IA necesita comunicarse con tu centro de ayuda (Zendesk), tus bases de conocimiento internas (Confluence, Google Docs) y otras herramientas empresariales (Shopify, Jira). Cada una de esas conexiones es un miniproyecto en sí misma.

-

Pruebas y Validación: ¿Cómo sabes si tu IA está ayudando de verdad o empeorando las cosas? Necesitas construir un marco de pruebas para ejecutarla con tus tickets de soporte anteriores y ver qué tan bien funciona.

-

Mantenimiento y Mejora: Los modelos se actualizan, tus documentos internos cambian y las necesidades de tu negocio evolucionan. Una solución personalizada necesita atención y alimentación constantes para seguir siendo eficaz.

Descripción Crear una infografía con un círculo central etiquetado "Aplicación de IA en Producción". Cuatro flechas apuntan desde el círculo hacia otras cuatro cajas:

-

Gestión del Conocimiento (RAG): Incluir iconos para la división de documentos, embeddings y una base de datos vectorial.

-

Integraciones: Incluir logos de herramientas populares como Zendesk, Shopify, Confluence y Jira.

-

Pruebas y Validación: Incluir iconos que representen pruebas A/B, métricas de rendimiento y análisis de datos.

-

Mantenimiento y Mejora: Incluir iconos para actualizaciones de modelos, ciclos de actualización de datos y monitorización continua.

La infografía debe representar visualmente que una simple llamada a la API es solo la punta del iceberg.

Estos son exactamente los quebraderos de cabeza que plataformas como eesel AI están diseñadas para resolver. eesel se conecta a todas tus fuentes de conocimiento con integraciones de un solo clic, se encarga de todo el proceso de RAG por ti e incluso tiene un potente modo de simulación para probar tu agente de IA con miles de tickets reales antes de que un solo cliente hable con él.

Un camino más sencillo hacia una IA lista para producción

Los SDKs de OpenAI son herramientas fantásticas para desarrolladores. Son los bloques de construcción esenciales para cualquiera que realice un trabajo de IA profundo y personalizado.

Pero para problemas empresariales específicos, como automatizar la atención al cliente, optimizar los centros de ayuda de TI o configurar un bot interno de preguntas y respuestas, construir desde cero suele ser un camino lento, caro y arriesgado. La pregunta no es solo qué es técnicamente posible, sino cuán rápido puedes obtener valor, cuán fiable será el producto final y cuál será el coste total a lo largo del tiempo.

¿Por qué pasar meses reinventando la rueda cuando una plataforma dedicada puede darte una solución más potente, integrada y probada en combate en una fracción del tiempo? Al encargarse de las partes complicadas como las canalizaciones de datos, las integraciones y la lógica del agente, plataformas como eesel AI permiten que tu equipo se concentre en lo que realmente importa: crear una gran experiencia para tus clientes y empleados.

Si tu objetivo es resolver un problema de soporte hoy, y no iniciar un proyecto de I+D a largo plazo, entonces un enfoque basado en una plataforma es probablemente la decisión correcta.

Lanza tu agente de IA en minutos

¿Listo para ver lo que un agente de soporte de IA de nivel de producción puede hacer por ti? Con eesel AI, puedes conectar tu centro de ayuda y tus bases de conocimiento con un solo clic, simular el rendimiento con tus datos reales y desplegar un agente de IA, copiloto o chatbot totalmente personalizados. Todo sin escribir una sola línea de código.

Comienza tu prueba gratuita hoy mismo y compruébalo por ti mismo.

Preguntas frecuentes

Los SDKs de OpenAI son bibliotecas oficiales para diversos lenguajes de programación que actúan como un 'wrapper' o capa de abstracción sobre la API de OpenAI. Se encargan de los detalles de bajo nivel como las solicitudes HTTP, la autenticación y el análisis de respuestas, permitiendo a los desarrolladores hacer llamadas a la API con simples llamadas a funciones específicas del lenguaje.

OpenAI proporciona SDKs oficiales para varios lenguajes de programación populares, incluyendo Python, TypeScript/JavaScript (Node.js), .NET (C#), Java y Go. Estos SDKs se adaptan a una amplia gama de entornos de desarrollo para construir diferentes tipos de aplicaciones.

Los SDKs de OpenAI habilitan capacidades multimodales al permitirte incluir varios tipos de contenido como URLs de imágenes, imágenes subidas, archivos de audio y documentos directamente en tus prompts. Esto permite que modelos como GPT-4o analicen y respondan a diversas entradas más allá del texto.

Sí, los SDKs de OpenAI son totalmente compatibles con la función de "herramientas" (anteriormente llamada llamada a funciones), que te permite definir funciones personalizadas que el modelo puede solicitar usar. Cuando el modelo determina que una función es relevante para la solicitud de un usuario, devolverá un objeto JSON especificando la función y sus parámetros para que tu código los ejecute.

Los desafíos clave incluyen una sobrecarga de ingeniería significativa para implementar la gestión del conocimiento (RAG), construir y mantener integraciones personalizadas y desarrollar marcos de prueba robustos. Estos aspectos exigen un tiempo de desarrollo considerable y un mantenimiento continuo para una solución lista para producción, además de los costes de la API.

El SDK de Agentes especializado está diseñado para construir aplicaciones agénticas sofisticadas, proporcionando características como transferencias de agentes, barandillas de seguridad (guardrails) para un comportamiento controlado y gestión automática de sesiones para el historial de conversaciones. Facilita un enfoque estructurado para la resolución de problemas de varios pasos y la coordinación de múltiples agentes de IA, simplificando la lógica compleja de los agentes.

Aunque los SDKs de OpenAI son excelentes para el desarrollo de IA personalizado y profundo, las plataformas dedicadas como eesel AI a menudo ofrecen un camino más rápido y eficiente hacia la producción para soluciones empresariales específicas. Estas plataformas abstraen la infraestructura compleja, las canalizaciones de datos y las integraciones, reduciendo significativamente la sobrecarga de ingeniería y acelerando el despliegue.

Compartir esta entrada

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.