Escribirle preguntas a un chatbot ya nos parece algo de lo más normal, ¿verdad? Pero la próxima gran revolución en la IA no tiene que ver con escribir, sino con hablar. Estamos a punto de tener una IA de voz conversacional en tiempo real que puede entendernos, interrumpir cuando es necesario y responder como lo haría otra persona. Es un cambio que promete una forma mucho más natural de interactuar con la tecnología.

Impulsando esta evolución se encuentran herramientas como la API Realtime de OpenAI, que ofrece a los desarrolladores los componentes básicos para estas experiencias fluidas y centradas en la voz. Pero aquí está el detalle: aunque la tecnología en sí es increíble, convertirla en una herramienta empresarial pulida y lista para el gran público es una historia completamente diferente. Es un viaje que generalmente requiere un conocimiento técnico considerable, muchas horas de desarrollo y una buena dosis de paciencia.

Así que, descorramos el telón de la API Realtime de OpenAI, veamos qué puede hacer y hablemos con sinceridad sobre lo que se necesita para construir con ella.

¿Qué es la API Realtime de OpenAI?

En esencia, la API Realtime de OpenAI es una herramienta que permite a los desarrolladores crear aplicaciones con conversaciones de voz a voz y de baja latencia. Si alguna vez has usado el Modo de Voz Avanzado de ChatGPT, este es el motor que hace posible ese tipo de interacción, pero ahora está disponible para que cualquiera lo use.

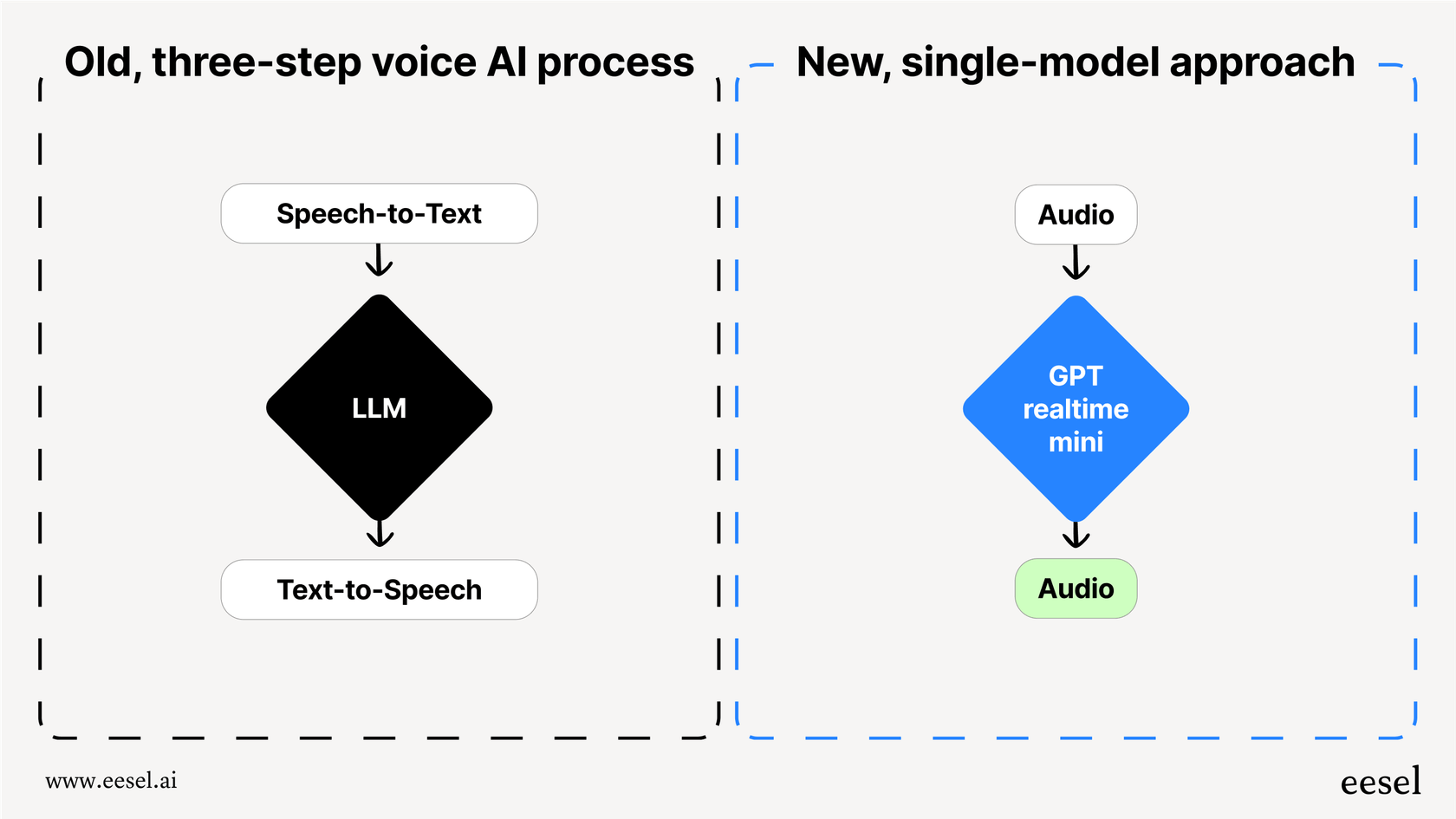

Antes de la llegada de esta API, construir un agente de voz era un dolor de cabeza, un proceso torpe y de múltiples pasos. Tenías que encadenar varias API diferentes:

-

Voz a texto (STT): Primero, usabas una API como Whisper para convertir las palabras habladas del usuario en texto.

-

Modelo de lenguaje grande (LLM): Luego, enviabas ese texto a una API como GPT-4 para que decidiera qué decir a continuación.

-

Texto a voz (TTS): Finalmente, usabas otra API para convertir la respuesta en texto de nuevo en audio.

Esta cadena de eventos funcionaba, pero era lenta. Cada paso añadía un pequeño retraso, creando una latencia incómoda que hacía que las conversaciones se sintieran forzadas y poco naturales. Y lo que es más importante, eliminaba todos los matices del habla humana. Aspectos como el tono, la emoción y el énfasis se perdían en el momento en que el audio se convertía en texto, dejándote con una interacción plana y robótica.

La API Realtime cambia esto por completo al usar un único modelo unificado (como "gpt-realtime") que maneja el audio de principio a [REDACTED]. Escucha el audio y genera una respuesta de audio directamente. Esto reduce drásticamente la latencia y preserva la riqueza del habla, allanando el camino para una IA más rápida, más expresiva y genuinamente conversacional.

Cómo funciona la API Realtime de OpenAI

La API no se trata solo de la voz; está diseñada para una comunicación multimodal de baja latencia. Esa es una forma elegante de decir que puede manejar diferentes tipos de información a la vez, haciendo que los agentes que construyas sean mucho más inteligentes y conscientes de su entorno.

Capacidades multimodales de la API Realtime de OpenAI

La API Realtime funciona con modelos como GPT-4o, que son "nativamente multimodales". Piénsalo de esta manera: a la IA no solo se le enseñó a leer texto. Fue entrenada desde el primer día para entender y procesar una mezcla de audio, imágenes y texto de forma conjunta. Esto permite interacciones que son mucho más dinámicas de lo que un simple agente de solo voz podría lograr.

Métodos de conexión

Para lograr esa velocidad en tiempo real, necesitas mantener una conexión constante abierta con la API. OpenAI proporciona algunos métodos de conexión, y la elección correcta realmente depende de lo que estés construyendo y de la pila tecnológica de tu equipo.

| Método de conexión | Caso de uso ideal | Carga técnica |

|---|---|---|

| WebRTC | Navegadores y aplicaciones del lado del cliente que necesitan la latencia más baja posible. | Alta (implica gestionar conexiones entre pares y ofertas/respuestas SDP). |

| WebSocket | Aplicaciones del lado del servidor donde la baja latencia sigue siendo una prioridad. | Media (más simple que WebRTC pero aún requiere gestionar una conexión persistente). |

| SIP | Integración con sistemas de telefonía VoIP (como en un centro de llamadas). | Alta (requiere conocimiento de protocolos e infraestructura de telefonía). |

Simplemente elegir y configurar el método de conexión correcto no es una tarea menor. Requiere una buena cantidad de planificación técnica y esfuerzo de desarrollo, y a menudo es uno de los primeros obstáculos con los que se encuentran los equipos al intentar construir un agente de voz personalizado.

Características clave de la API Realtime de OpenAI

Más allá de su diseño principal, la API Realtime incluye un conjunto de características que la convierten en un potente conjunto de herramientas para los desarrolladores. Estas son las piezas que usarás para crear agentes de voz inteligentes y dinámicos.

Interacción de voz a voz

Este es el plato fuerte. Debido a que un modelo como "gpt-realtime" trabaja directamente con audio, puede captar señales sutiles que los sistemas basados en texto siempre pasan por alto, como la risa, el sarcasmo o los cambios emocionales. Luego puede generar una respuesta que suena mucho más natural y expresiva. Con el lanzamiento general de la API, OpenAI incluso añadió dos nuevas voces, Marin y Cedar, que están disponibles exclusivamente aquí y suenan increíblemente realistas.

Detección de Actividad de Voz (VAD)

La Detección de Actividad de Voz es lo que hace que una conversación con IA se sienta menos como una transacción y más como una charla real. Es la función que le permite a la IA saber cuándo alguien ha comenzado o dejado de hablar. Esto es absolutamente esencial para un intercambio de turnos natural. Si un usuario quiere intervenir y cambiar de tema, puede simplemente empezar a hablar. El agente lo reconocerá y se adaptará en lugar de seguir adelante o esperar una pausa incómoda.

Llamada a funciones y herramientas

Un agente de voz solo es útil si realmente puede hacer cosas. La API Realtime admite la llamada a funciones, lo que permite al agente conectarse a herramientas y fuentes de datos externas para obtener información o completar tareas. Por ejemplo, un agente de soporte podría usar una función para buscar el estado del pedido de un cliente en tu sistema o procesar un reembolso en el momento. Si bien esto es increíblemente potente, depende de ti, el desarrollador, construir, conectar y mantener cada una de estas integraciones de herramientas.

Entradas de imagen y texto

Dado que la API es multimodal, los usuarios no están limitados solo a su voz. Pueden añadir otra información a la conversación. Un cliente podría estar en una llamada con un agente de soporte, enviar una captura de pantalla de un mensaje de error y preguntar: "¿Qué estoy viendo aquí?". El agente puede ver la imagen, entender el contexto y dar una respuesta hablada útil.

Casos de uso comunes y limitaciones de la API Realtime de OpenAI

El potencial de la IA de voz de baja latencia es enorme, pero algunos casos de uso se han vuelto rápidamente los más populares. También vale la pena ser realista sobre los obstáculos que enfrentarás al construir estas aplicaciones desde cero.

Casos de uso

-

Agentes de soporte al cliente: Responder llamadas entrantes, gestionar preguntas comunes y derivar problemas más complicados al agente humano adecuado.

-

Asistentes personales: Ayudar con la programación de citas, establecer recordatorios y obtener información con manos libres.

-

Aplicaciones para aprender idiomas: Crear compañeros de conversación realistas para ayudar a los usuarios a practicar un nuevo idioma.

-

Herramientas educativas: Construir tutores interactivos que puedan explicar verbalmente temas complejos y responder a las preguntas de los estudiantes.

Limitaciones de un enfoque de desarrollo propio (DIY)

Construir un agente de voz con la API en bruto puede sonar emocionante, pero es un proyecto de ingeniería masivo que va mucho más allá de simplemente llamar a un endpoint.

-

El esfuerzo de desarrollo es enorme: No estás simplemente conectando una API; estás construyendo una aplicación completa. Esto significa gestionar la infraestructura, manejar el estado de la conversación, diseñar la lógica y asegurarte de que todo el sistema sea fiable y escalable.

-

No incluye flujos de trabajo empresariales: La API te da el motor, pero tú tienes que construir el coche. Toda la lógica específica del negocio para clasificar tickets, escalar al equipo correcto, hacer seguimiento de las interacciones y generar informes sobre su rendimiento debe construirse desde cero.

-

Sin analíticas ni pruebas integradas: ¿Cómo sabes si tu agente es realmente bueno? Sin herramientas dedicadas, no hay una manera fácil de probar tu agente con conversaciones pasadas, medir su precisión o averiguar dónde se está quedando corta tu base de conocimientos.

Aquí es donde entra en juego el clásico debate de "desarrollar o comprar". Para los equipos que necesitan una solución de soporte con IA lista para producción sin esperar meses de desarrollo, una plataforma como eesel AI ofrece un camino mucho más directo. Proporciona un motor de flujos de trabajo sin código, integraciones con servicios de asistencia en un solo clic y potentes herramientas de simulación, lo que te permite empezar a funcionar en minutos, no en meses.

Precios de la API Realtime de OpenAI

La API se factura en función de los tokens de audio, que se calculan de manera diferente a los tokens de texto. Se te cobra tanto por el audio que envías al modelo (entrada) como por el audio que el modelo te envía a ti (salida). Esto puede dificultar la predicción de los costes, ya que dependen de la duración y complejidad de cada conversación.

Aquí tienes un vistazo rápido a los precios del modelo "gpt-realtime" (nivel estándar), que es un 20% más barato que la versión de previsualización:

| Tipo de Token | Precio por 1M de tokens |

|---|---|

| Entrada de Audio | 32,00 $ |

| Entrada de Audio en Caché | 0,40 $ |

| Salida de Audio | 64,00 $ |

(Información de precios basada en la página de precios de OpenAI.)

Aunque los precios basados en tokens son flexibles para los desarrolladores que solo están experimentando, pueden generar facturas impredecibles para las empresas con canales de soporte de alto volumen. Un mes ajetreado podría resultar en una factura sorprendentemente grande, lo que dificulta la elaboración de presupuestos eficaces.

La alternativa más sencilla a la API Realtime de OpenAI: agentes de soporte con IA de eesel AI

Construir directamente con la API Realtime de OpenAI es una opción fantástica para los desarrolladores que crean aplicaciones completamente nuevas desde cero. Sin embargo, para las empresas que buscan automatizar el soporte al cliente, mejorar su gestión de servicios de TI o potenciar las preguntas y respuestas internas, una plataforma dedicada es casi siempre la opción más rápida, rentable y potente desde el primer momento.

eesel AI es una plataforma completa de soporte con IA que utiliza el poder de modelos avanzados como los que están detrás de la API Realtime, pero te ahorra tener que escribir una sola línea de código para integraciones o gestión de flujos de trabajo.

Así es como aborda los desafíos del enfoque de desarrollo propio:

-

Puesta en marcha en minutos: En lugar de pasar meses lidiando con WebSockets e infraestructura, puedes conectar tu servicio de asistencia (como Zendesk, Freshdesk o [REDACTED]) y tus fuentes de conocimiento con un solo clic. Tu agente de IA puede empezar a aprender de tus tickets pasados, artículos del centro de ayuda y documentos internos de inmediato.

-

Pruebas con confianza: El modo de simulación de eesel AI te permite probar tu agente con miles de tus tickets históricos reales en un entorno seguro. Puedes ver cómo habría respondido, ajustar su comportamiento y obtener pronósticos precisos sobre las tasas de resolución y el ahorro de costes antes de que interactúe con un cliente real.

-

Control y personalización totales: Con un sencillo editor de prompts y un motor de flujos de trabajo sin código, tú decides exactamente qué tickets gestiona tu IA y qué acciones puede realizar. Puedes configurar reglas para escalar problemas complejos, etiquetar tickets automáticamente o incluso llamar a API externas para obtener información de pedidos.

-

Precios predecibles: Los planes de eesel AI se basan en un número fijo de interacciones de IA mensuales, sin sorpresas de tarifas por resolución. Esto hace que tu presupuesto sea simple y transparente, eliminando las conjeturas que conlleva un modelo variable basado en tokens.

Reflexiones finales sobre la API Realtime de OpenAI

La API Realtime de OpenAI es una pieza de tecnología realmente impresionante. Está cerrando la brecha entre cómo hablan los humanos y las máquinas, allanando el camino para un futuro en el que la IA centrada en la voz se sienta completamente natural. Ofrece a los desarrolladores un motor increíblemente potente para construir cosas asombrosas.

Sin embargo, el camino desde una clave de API hasta una herramienta empresarial fiable y lista para producción es largo y está lleno de desafíos técnicos. Para la mayoría de las empresas, especialmente aquellas centradas en el servicio al cliente y el soporte de TI, una plataforma construida para ese propósito específico simplemente ofrece valor de forma más rápida y fiable. Obtienes toda la potencia de la IA subyacente, pero envuelta en un conjunto de herramientas diseñadas para el trabajo exacto que necesitas hacer.

¿Listo para ver lo que un agente de soporte con IA diseñado específicamente puede hacer por ti? Comienza tu prueba gratuita con eesel AI y automatiza tu soporte de primera línea en minutos.

Preguntas frecuentes

La API Realtime de OpenAI está diseñada para permitir a los desarrolladores crear aplicaciones que admitan conversaciones de voz a voz con baja latencia. Utiliza un único modelo unificado para procesar el audio directamente, lo que permite experiencias fluidas y naturales centradas en la voz.

A diferencia de los enfoques anteriores de múltiples pasos, la API Realtime de OpenAI maneja el audio de principio a [REDACTED], lo que reduce significativamente la latencia y preserva matices sutiles como el tono y la emoción. Este procesamiento unificado conduce a interacciones de IA mucho más naturales y expresivas.

Para garantizar la velocidad en tiempo real, la API Realtime de OpenAI admite varios métodos de conexión. Estos incluyen WebRTC para aplicaciones basadas en navegador, WebSockets para uso del lado del servidor y SIP para la integración con sistemas de telefonía VoIP.

Sí, la API Realtime de OpenAI admite la llamada a funciones, lo que permite al agente de IA conectarse a herramientas y fuentes de datos externas. Los desarrolladores son responsables de construir, conectar y mantener estas integraciones para habilitar tareas específicas o la recuperación de información.

El precio de la API Realtime de OpenAI se basa en tokens de audio tanto para la entrada como para la salida, lo que puede dificultar la predicción de los costes. Para las empresas con un alto volumen de uso, este modelo basado en tokens puede generar facturas mensuales variables y potencialmente altas.

La API Realtime de OpenAI se ejecuta en modelos nativamente multimodales como GPT-4o, lo que le permite procesar una mezcla de audio, imágenes y texto. Esto significa que los usuarios pueden proporcionar contexto visual, como una captura de pantalla, junto con sus preguntas habladas para interacciones más ricas y completas.

Compartir esta entrada

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.