Todos sabemos que los modelos de lenguaje grandes (LLM) tienen mucha labia. Pueden redactar correos, responder a preguntas de trivial e incluso improvisar un soneto si se lo pides. Pero ¿qué hay de hacer cosas de verdad? ¿Cómo conseguimos que dejen de hablar y empiecen a interactuar con el mundo real, como buscar un pedido, actualizar un ticket de soporte o consultar una base de datos?

Ese es el trabajo de Function Calling de OpenAI (que ahora han rebautizado oficialmente como "Tools" o Herramientas). Es la pieza del rompecabezas que conecta las habilidades conversacionales de una IA con la acción en el mundo real. Es lo que convierte a un simple bot de preguntas y respuestas en un agente que puede trabajar de verdad con el software de tu empresa.

En esta guía, explicaremos qué es el Function Calling, cómo funciona y algunas de las complejidades ocultas con las que te toparás si intentas construir algo con esta tecnología desde cero. Y lo que es más importante, veremos cómo las plataformas modernas pueden encargarse del trabajo pesado, permitiéndote crear potentes agentes de IA sin necesidad de tener un equipo de ingeniería dedicado a tu disposición.

¿Qué es el Function Calling de OpenAI?

Dicho de forma sencilla, el Function Calling de OpenAI es una función que te permite informar a un LLM sobre las herramientas que tienes disponibles. Le describes tus funciones al modelo y este puede analizar la solicitud de un usuario y pedir usar una de ellas. Para ello, genera un objeto JSON bien estructurado con todos los detalles que tu aplicación necesita para ejecutar la función.

Un error común es pensar que el modelo ejecuta el código por sí mismo. No es así. Simplemente le dice a tu aplicación qué código debe ejecutar y qué información debe usar.

Piensa en el LLM como un asistente muy inteligente que conoce a fondo todas tus herramientas. Cuando surge una tarea, no puede usar las herramientas por sí mismo, pero puede pasarte la correcta (el nombre de la función) y decirte exactamente cómo usarla (los argumentos). Tu aplicación es la que realmente se ensucia las manos y hace el trabajo.

Aunque OpenAI empezó a llamar a esta función "Tools" (Herramientas) para reflejar mejor lo que puede hacer, la mayoría de la gente sigue usando el término "Function Calling" para describir el concepto.

¿Cómo funciona el flujo de Function Calling de OpenAI?

Conseguir que una IA use una herramienta no es una única llamada a la API; es más bien una conversación de ida y vuelta entre tu aplicación y el modelo. Es un pequeño baile que sigue un patrón bastante predecible.

Aquí tienes un vistazo paso a paso de cómo se desarrolla:

-

Le muestras al modelo tus herramientas. Primero, le das al modelo una lista de las funciones que puede usar. Esto incluye el nombre de la función, una descripción clara de lo que hace y los parámetros específicos que necesita para funcionar (todo ello presentado en un formato llamado esquema JSON). La calidad de tu descripción lo es todo, ya que es la forma en que el modelo decide cuándo sugerir una herramienta.

-

El usuario pide algo. Un usuario escribe una solicitud en lenguaje natural, como: «¿Cuál es el estado de mi pedido n.º 12345?».

-

El modelo elige una herramienta. El modelo lee la solicitud. Si detecta una coincidencia con una de las descripciones de tus funciones, responde con un mensaje especial pidiéndole a tu aplicación que llame a esa función. También proporciona los argumentos que extrajo de la petición del usuario (por ejemplo,

"{"function": "get_order_status", "arguments": {"order_id": "12345"}}"). -

Tu aplicación hace el trabajo. Tu código toma esta respuesta estructurada y ejecuta la función real

get_order_status. Podría conectarse a tu base de datos o a una API externa para obtener la información, que en este caso es «Enviado». -

Le devuelves el resultado al modelo. Finalmente, haces una última llamada a la API del modelo, esta vez incluyendo el resultado de la función en el historial del chat. Ahora el modelo tiene la última pieza del rompecabezas y puede dar al usuario una respuesta amable y natural, como: «Tu pedido n.º 12345 ha sido enviado».

Este pequeño viaje de ida y vuelta permite a la IA combinar sus habilidades conversacionales con datos y acciones en tiempo real, lo que la hace mucho más útil.

Recurso 1: [Flujo de trabajo], Diagrama que ilustra el proceso de cinco pasos del Function Calling de OpenAI, desde la solicitud del usuario hasta la respuesta final generada por la IA.

Casos de uso comunes para el Function Calling de OpenAI

El Function Calling es lo que lleva a un chatbot de ser una simple novedad a convertirse en un potente agente capaz de gestionar flujos de trabajo empresariales reales. Estas son algunas de las formas más comunes en que la gente lo está utilizando.

Conectarse a tus datos en tiempo real

Este es el caso de uso más directo. Permite a una IA acceder a información en tiempo real, privada o dinámica que no estaba en sus datos de entrenamiento originales. Una IA puede convertirse en experta en las operaciones específicas de tu negocio casi al instante.

Por ejemplo, una IA de atención al cliente podría buscar el estado de un pedido en una base de datos de Shopify, comprobar la disponibilidad de vuelos a través de la API de una aerolínea o extraer los detalles de una cuenta de tu CRM interno.

Realizar tareas en otras aplicaciones

Además de obtener información, el Function Calling permite a una IA activar flujos de trabajo y realizar cambios en otros sistemas. Puede convertirse en una parte activa de tus procesos de negocio.

Por ejemplo, un bot de soporte de TI podría recibir una solicitud y crear automáticamente un nuevo ticket en Jira Service Management. O bien, un asistente de ventas podría tomar los detalles de una conversación y añadir un nuevo cliente potencial a tu CRM sin que nadie tenga que introducir los datos manualmente.

Convertir texto desordenado en datos limpios

En ocasiones, el objetivo no es responder a una pregunta, sino extraer y formatear información de forma fiable. El Function Calling es ideal para esto porque puedes definir los parámetros de una función como una plantilla en la que quieres que encajen los datos.

Un ejemplo perfecto es procesar un correo electrónico de soporte entrante. La IA puede leer un bloque de texto, extraer el nombre del usuario, la empresa, el tipo de problema y el nivel de urgencia, y luego darle a todo el formato de un objeto JSON perfecto. Ese objeto se puede usar para crear un nuevo ticket, perfectamente categorizado, en tu servicio de asistencia.

Los desafíos ocultos de construir con Function Calling de OpenAI

Pasar de una demostración interesante a una aplicación lista para producción que utiliza Function Calling es un salto bastante grande. Construir directamente con la API es potente, pero conlleva algunos verdaderos quebraderos de cabeza de ingeniería que muchos equipos no ven venir.

Desafíos de orquestación

¿Qué ocurre cuando una tarea necesita varios pasos? Para encontrar el pedido de un cliente, puede que primero necesites encontrar su ID de cliente usando su correo electrónico, y luego usar ese ID para buscar sus pedidos. El modelo no maneja este tipo de lógica de varios pasos por sí solo. Tienes que construir y mantener una "máquina de estados" en tu propio código para gestionar la secuencia.

Fiabilidad y manejo de errores

Los modelos no siempre actúan como esperas. A veces pueden "alucinar" argumentos que no existen, llamar a la función incorrecta o simplemente no llamar a ninguna cuando es obviamente necesario. Esto significa que tu equipo tiene que escribir una tonelada de lógica de validación, comprobación de errores y reintentos para que el sistema sea fiable.

Algunos desarrolladores incluso recurren a prácticamente gritarle al modelo en sus mensajes de sistema, escribiendo cosas como «NO ASUMAS VALORES PARA LOS PARÁMETROS» en mayúsculas, solo para que se comporte. Esa no es una forma escalable de construir un sistema de producción.

Encadenamiento de funciones: un punto débil conocido

Aun con las mejores indicaciones, los modelos a menudo tienen dificultades para planificar y ejecutar una tarea que requiere varias llamadas a funciones diferentes en un orden específico. Son bastante buenos eligiendo la siguiente mejor herramienta para un solo paso, pero pueden perderse en un flujo de trabajo más complejo. De nuevo, esto significa que tienes que escribir código personalizado, a menudo complicado, para gestionar el flujo y guiar al modelo de un paso al siguiente.

El desarrollo y el mantenimiento pueden ser un verdadero lastre

Definir esquemas de funciones en JSON es un trabajo tedioso y es fácil cometer un error de sintaxis. Cada vez que quieres añadir una nueva herramienta o actualizar una antigua, tienes que volver a sumergirte en el código. Mantener este código sincronizado con tus herramientas reales, gestionar diferentes versiones y simplemente estar al día con los frecuentes cambios en la API de OpenAI se convierte en una sangría constante de tiempo de ingeniería.

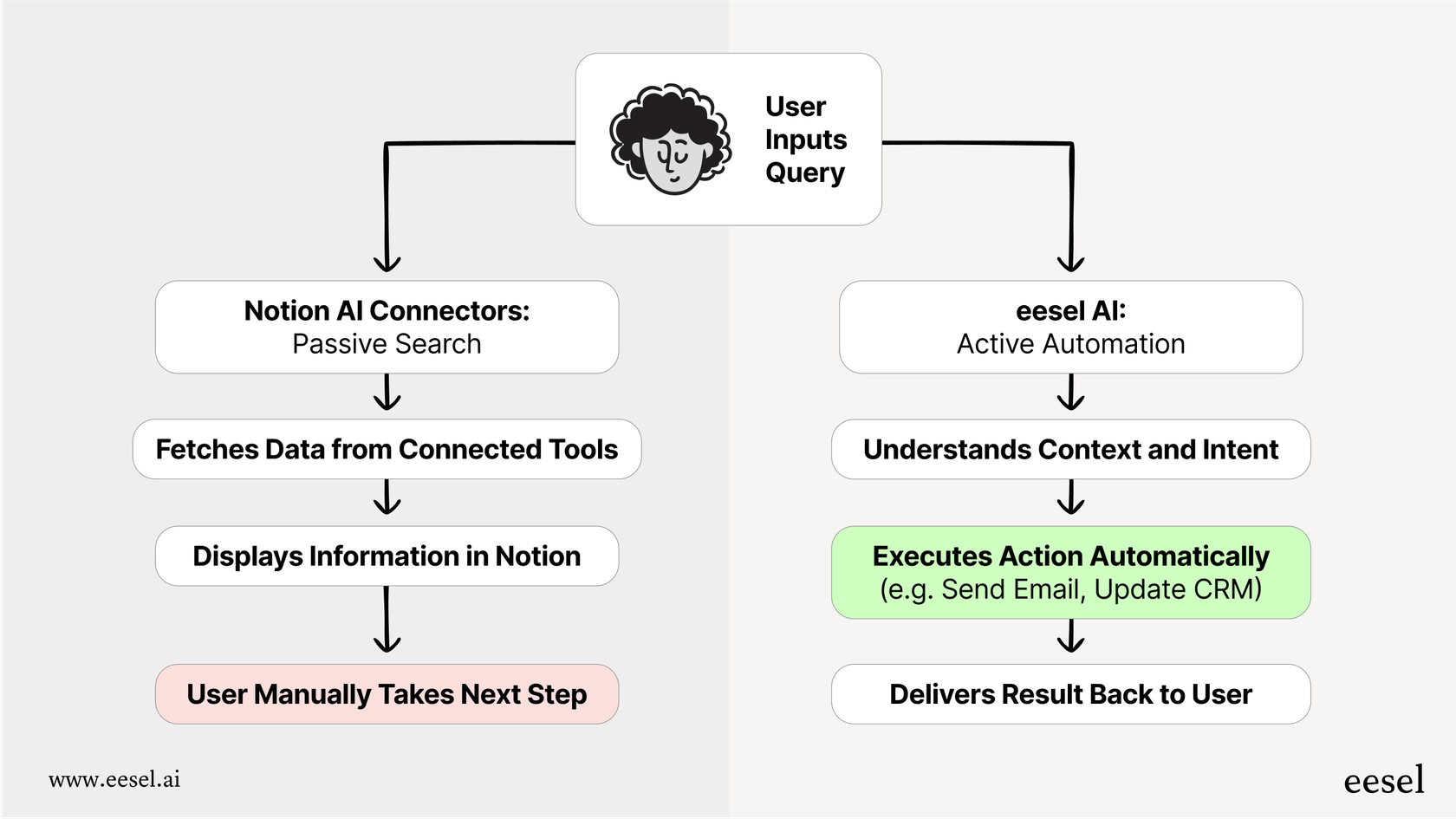

Una forma más sencilla de crear agentes de IA

El enfoque de «hazlo tú mismo» para el Function Calling es potente, pero no es práctico para la mayoría de los equipos de soporte y TI que necesitan soluciones fiables sin un equipo de ingeniería dedicado. Aquí es donde plataformas como eesel AI pueden marcar una gran diferencia. eesel AI se encarga de todo el trabajo sucio entre bastidores del Function Calling a través de una interfaz intuitiva, convirtiendo un difícil desafío de programación en un flujo de trabajo sencillo.

Del código complejo a un motor de flujos de trabajo sin código

En lugar de escribir scripts de Python y máquinas de estado para gestionar las llamadas a funciones, eesel AI te ofrece un constructor de flujos de trabajo visual. Puedes configurar reglas, rutas de escalado y secuencias de acciones sin escribir una sola línea de código. Esto te da un control total sobre el comportamiento de tu IA, permitiéndote diseñar flujos de trabajo sofisticados que se ejecutan de forma fiable en todo momento. Tú decides exactamente qué tickets debe gestionar la IA y qué debe hacer, paso a paso.

Acciones preconstruidas y conexiones personalizadas sencillas

eesel AI viene con una biblioteca de acciones listas para usar para servicios de asistencia populares como Zendesk y Freshdesk. Tareas comunes como «etiquetar ticket», «añadir nota interna» o «cerrar ticket» están a solo un clic de distancia.

¿Necesitas conectarte a una herramienta personalizada o a una API interna? eesel AI también lo hace sencillo. Puedes configurar fácilmente acciones personalizadas para buscar información o activar flujos de trabajo en cualquier sistema externo, encargándose por ti de toda la tediosa creación de esquemas JSON. Así es como los equipos pueden lanzar sus proyectos en minutos, no en meses.

Prueba tu implementación con confianza antes de lanzarla

Una de las mayores preocupaciones del enfoque «hazlo tú mismo» es la incertidumbre. ¿Funcionará realmente el agente como se espera con los problemas reales de los clientes? eesel AI resuelve esto con su modo de simulación. En lugar de desplegar el código y cruzar los dedos, puedes ejecutar tu agente de IA en miles de tus tickets pasados en un entorno seguro. Puedes ver exactamente cómo habría respondido, qué acciones habría tomado y cuál sería tu tasa de automatización. Esto te permite afinar todo y probar con confianza antes de que interactúe con un cliente real.

Recurso 2: [Captura de pantalla], El modo de simulación en eesel AI, que muestra cómo un agente que usa Function Calling de OpenAI se habría desempeñado en tickets anteriores.

Ve más allá de la conversación y empieza a actuar

El Function Calling de OpenAI es el motor que permite a la IA realizar un trabajo real, pero la API en bruto es en realidad solo una caja de piezas. Construir un agente de IA fiable y de calidad de producción desde cero te da la máxima flexibilidad, pero tiene un alto coste en términos de complejidad, falta de fiabilidad y mantenimiento continuo.

Plataformas como eesel AI ofrecen toda la potencia del Function Calling sin los quebraderos de cabeza de la ingeniería. Dan a los equipos la capacidad de desplegar agentes de IA capaces y personalizados que están estrechamente integrados con sus herramientas de negocio, cerrando finalmente la brecha entre simplemente hablar y realmente hacer.

¿Listo para construir un agente de IA que tome acciones reales?

Si estás listo para construir un agente de IA que se conecte a tus herramientas y automatice tu soporte, regístrate gratis en eesel AI y lanza tu primer agente de IA en minutos. No se requiere programación.

Preguntas frecuentes

El Function Calling de OpenAI (ahora a menudo llamado "Tools" o Herramientas) es una función que te permite describir las funciones que tienes disponibles a un LLM. Resuelve el problema de conectar las habilidades conversacionales de una IA con acciones del mundo real, permitiéndole pedir a tu aplicación que realice tareas como buscar datos o actualizar sistemas.

No, el LLM no ejecuta tu código. Simplemente analiza la solicitud de un usuario y, si es apropiado, responde con un objeto JSON estructurado que indica qué función debe ejecutar tu aplicación y qué argumentos usar. Tu aplicación es la que ejecuta esa función.

El proceso implica que tu aplicación primero describe sus herramientas al modelo. Cuando un usuario hace una solicitud, el modelo sugiere una función y sus argumentos. Luego, tu aplicación ejecuta esa función y, finalmente, le devuelves el resultado al modelo para que pueda formular una respuesta en lenguaje natural al usuario.

Las empresas lo usan comúnmente para conectar las IA a datos en tiempo real, como buscar el estado de los pedidos en una base de datos o los detalles de una cuenta en un CRM. También se utiliza para activar acciones en otras aplicaciones, como crear un ticket en Jira, o para extraer y formatear datos específicos a partir de texto desordenado.

Los desafíos clave incluyen la orquestación de flujos de trabajo de varios pasos, garantizar la fiabilidad con un manejo de errores robusto y la dificultad del modelo para encadenar múltiples funciones. También hay una sobrecarga significativa de desarrollo y mantenimiento debido a la definición manual de esquemas JSON y los cambios en la API.

Plataformas como eesel AI proporcionan constructores de flujos de trabajo visuales y acciones preconstruidas, abstrayendo la codificación compleja, la orquestación y el manejo de errores. Simplifican la definición de herramientas personalizadas y ofrecen modos de simulación para probar los agentes con confianza antes de su despliegue.

Compartir esta entrada

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.