El mundo de la IA se mueve a una velocidad de vértigo. En un minuto oyes hablar de un nuevo modelo y, al siguiente, ya parece noticia vieja. Para cualquiera que intente construir algo con IA, elegir el modelo de lenguaje grande (LLM) adecuado puede parecer menos una elección estratégica y más bien un intento de subirse a un tren en marcha.

Cuando necesitas construir algo real, tienes que dejar de lado el "hype" y descubrir qué funciona de verdad. Dos de los pesos pesados del momento son Gemini de Google y Mistral AI. Vienen de lugares muy diferentes y tienen ideas distintas sobre cómo construir una IA potente. Esta guía te guiará en el debate Gemini vs. Mistral, comparando su rendimiento, su coste y cómo se posicionan para el uso empresarial diario.

Gemini vs. Mistral: ¿Qué son Google Gemini y Mistral AI?

Antes de entrar en materia, conozcamos rápidamente a estos dos contendientes. No son simplemente cerebros de IA intercambiables; tienen orígenes y objetivos diferentes.

Google Gemini: el gigante

Gemini es la creación de Google y cuenta con el respaldo total de una de las mayores empresas tecnológicas del mundo. Es un modelo multimodal, que es solo una forma técnica de decir que fue diseñado desde el principio para entender texto, código, imágenes y vídeo, todo a la vez. Encontrarás Gemini impulsando herramientas como Gemini Advanced e integrado en el ecosistema de Google, desde Workspace hasta la plataforma de nivel empresarial Vertex AI.

El principal atractivo de Gemini es su enorme escala. Tiene acceso a los gigantescos conjuntos de datos de Google y demuestra una habilidad impresionante en tareas que requieren un pensamiento complejo y de varios pasos. Está diseñado para ser una IA todoterreno que puede manejar prácticamente cualquier cosa que le eches.

Mistral AI: el aspirante

Por otro lado, tenemos a Mistral AI, una empresa con sede en París que saltó a la fama por centrarse en la eficiencia y en los modelos de código abierto. Aunque ofrecen modelos comerciales de pago, son muy conocidos por sus modelos de "pesos abiertos" como Mistral 7B y Mixtral. Esto significa que publican los archivos principales del modelo, permitiendo a los desarrolladores ajustarlos, afinarlos y ejecutarlos en sus propios servidores.

Mistral se ha forjado una sólida reputación entre los desarrolladores por crear modelos que ofrecen un rendimiento muy superior al esperado para su tamaño. Ofrecen un gran rendimiento sin exigir un almacén lleno de GPUs. Sus respuestas suelen describirse como concisas y directas, lo que los convierte en los favoritos para los flujos de trabajo empresariales en los que solo se necesita una respuesta fiable, sin palabrería extra.

Gemini vs. Mistral: Rendimiento y capacidades

Entonces, ¿qué tal se desenvuelven? El "mejor" modelo realmente depende de lo que estés tratando de lograr. Una IA que es brillante escribiendo un correo electrónico de marketing creativo podría no ser la adecuada para generar código limpio y listo para producción.

Gemini vs. Mistral: Razonamiento, precisión y el "factor paja"

Pasa cinco minutos en cualquier foro de desarrolladores y verás un tema común: la gente habla mucho de la vibra de las respuestas. Los usuarios suelen decir que los modelos de Mistral van directos al grano. Te dan una respuesta sin introducciones conversacionales como "¡Esa es una gran pregunta!" u otro tipo de relleno que a veces puede entorpecer las respuestas de los modelos más grandes. Para muchos usos empresariales, este estilo directo y "sin paja" parece más predecible y fiable.

Por supuesto, cualquier modelo puede "alucinar" o inventarse cosas, pero la concisión de Mistral puede hacerlo sentir más fiable para tareas sencillas. Gemini, por otro lado, suele dar respuestas más detalladas y completas. Esto puede ser genial para hacer brainstorming o cuando necesitas una inmersión profunda en un tema complicado, pero también puede significar que tienes que leer más texto para encontrar la respuesta principal.

También vale la pena recordar que el rendimiento puede cambiar drásticamente según la tarea. Por ejemplo, una comparación directa sobre la precisión del OCR encontró que Gemini Flash 2.0 era bastante más preciso que el modelo OCR de Mistral en un conjunto variado de documentos. Es un buen recordatorio de que los benchmarks publicados por las propias empresas no siempre reflejan el rendimiento en el mundo real. Tienes que probarlo por ti mismo.

Fortalezas en tareas específicas

Veamos cómo se comportan estos modelos en algunas tareas empresariales comunes.

-

Programación: Ambos modelos son bastante útiles para generar código. Sin embargo, encontrarás a muchos desarrolladores inclinándose por Mistral para escenarios de producción. Su resultado suele ser más limpio y consistente, lo que facilita su integración en flujos de trabajo automatizados. Mistral también tiene modelos especializados como Codestral, que están afinados específicamente para la programación.

-

Escritura y creatividad: Aquí es donde Gemini suele brillar. Su estilo conversacional y exhaustivo es muy adecuado para la escritura creativa, el brainstorming de textos de marketing y la generación de texto que se sienta humano. El tono predeterminado de Mistral tiende a ser más profesional y fáctico, lo cual es perfecto para informes o resúmenes, pero quizás no para tu próxima gran campaña publicitaria.

-

Análisis de documentos y datos: Gemini tiene una ventaja enorme aquí debido a su gigantesca ventana de contexto. La ventana de contexto es básicamente la cantidad de información que el modelo puede mantener en su memoria a corto plazo. Con Gemini 1.5 Pro capaz de manejar hasta 2 millones de tokens (eso es alrededor de 1.5 millones de palabras), puede procesar documentos increíblemente largos, bases de código enteras u horas de vídeo. Los modelos de Mistral, como Mistral Large con su ventana de 32.000 tokens, están mucho más limitados en este aspecto.

Una tabla de comparación directa

Aquí tienes un resumen rápido de sus diferencias cualitativas.

| Característica | Google Gemini | Mistral AI | Ganador |

|---|---|---|---|

| Estilo de respuesta | Más conversacional y completo, puede ser extenso. | Conciso, directo y al grano; menos "paja". | Depende del caso de uso |

| Programación | Sólidas capacidades de programación de propósito general. | Muy apreciado por la generación de código limpio y estable; modelos especializados. | Mistral (para producción) |

| Tareas creativas | A menudo preferido para brainstorming y escritura de estilo humano. | Tono más fáctico y profesional por defecto. | Gemini |

| Análisis de documentos | Excelente debido a su enorme ventana de contexto (hasta 2M de tokens). | Limitado por una ventana de contexto más pequeña (ej., 32K tokens). | Gemini |

| Confianza percibida | A veces puede parecer demasiado cauto o rechazar preguntas políticas. | La franqueza a menudo se percibe como más estable y fiable para los negocios. | Mistral (para negocios) |

Gemini vs. Mistral: Especificaciones técnicas y características

Para cualquiera que esté construyendo con estos modelos, los detalles técnicos son donde la teoría se convierte en práctica. Así es como se comparan.

Familias de modelos y variantes

Tanto Google como Mistral ofrecen un menú de modelos diseñados para diferentes necesidades, permitiéndote equilibrar rendimiento, velocidad y coste.

-

Gemini: Las dos opciones principales disponibles a través de su API son Gemini 1.5 Pro, su modelo más potente y de gama alta, y Gemini 1.5 Flash, que está diseñado para la velocidad y la eficiencia en situaciones de alto volumen.

-

Mistral: Su línea tiene más niveles:

- Modelos de pesos abiertos: Mistral 7B y Mixtral 8x7B son las opciones preferidas por los desarrolladores que quieren alojar los modelos ellos mismos o afinarlos con sus propios datos.

- Modelos comerciales: Mistral Small, Mistral Medium y Mistral Large 2 son sus modelos optimizados a los que puedes acceder a través de una API, ofreciendo una buena mezcla de precio y potencia.

- Modelos especializados: También crean modelos específicos como Codestral, que está centrado exclusivamente en la generación y finalización de código.

Gemini vs. Mistral: Ventana de contexto y fecha de corte de conocimiento

La ventana de contexto es una de las mayores diferencias técnicas entre ellos. Como mencionamos, la capacidad de Gemini 1.5 Pro para procesar hasta 2 millones de tokens es un gran avance para cualquiera que trabaje con grandes volúmenes de información. La ventana de 32.000 tokens de Mistral Large sigue siendo muy útil, pero simplemente no está en la misma liga.

Otra cosa a tener en cuenta es la fecha de corte de conocimiento, que es la fecha de "caducidad" de los datos de entrenamiento del modelo. Algunos de los modelos de Mistral tienen una fecha de corte ligeramente más antigua, pero esto se está volviendo menos problemático. Ambas compañías ahora ofrecen modelos que pueden realizar búsquedas web en tiempo real para obtener la información más reciente.

API y ecosistemas para desarrolladores

Ambas plataformas ofrecen una experiencia bastante fluida para los desarrolladores. Vertex AI de Google es una plataforma masiva y preparada para empresas con una enorme caja de herramientas, muchas integraciones y documentación detallada para construir con Gemini.

La API de Mistral, que ellos llaman "la Plateforme", recibe muchos elogios por ser simple y fácil de usar, lo que encaja con su actitud de priorizar al desarrollador. Está diseñada para que sea sencillo empezar y puedas ponerte en marcha rápidamente.

Gemini vs. Mistral: Precios y aplicación empresarial

Al final del día, la decisión a menudo se reduce al dinero y al valor para el negocio. Veamos cómo se comparan sus precios y cómo puedes usar realmente estos modelos en tu empresa sin contratar a todo un nuevo equipo de ingeniería.

Un desglose de los modelos de precios

Ambas compañías utilizan principalmente un modelo de pago por token para sus APIs. Se te cobra por la cantidad de texto que envías al modelo (entrada) y la cantidad de texto que el modelo devuelve (salida).

- Gemini (a través de Vertex AI): Los precios de Google son bastante competitivos, especialmente para su rápido modelo Flash.

Fuente: Página de precios de Google Cloud

| Modelo | Precio de entrada / 1M de tokens | Precio de salida / 1M de tokens |

|---|---|---|

| Gemini 1.5 Pro | 3,50 $ | 10,50 $ |

| Gemini 1.5 Flash | 0,35 $ | 1,05 $ |

- Mistral: Los precios de la API de Mistral también son competitivos, y sus modelos más pequeños y eficientes son particularmente económicos.

Fuente: Sitio web de Mistral AI

| Modelo | Precio de entrada / 1M de tokens | Precio de salida / 1M de tokens |

|---|---|---|

| Mistral Large 2 | 3,00 $ | 9,00 $ |

| Mistral Small | 0,50 $ | 1,50 $ |

| Codestral | 1,00 $ | 3,00 $ |

Mistral también tiene una suscripción "Le Chat Pro" por unos 15 $ al mes, dirigida a particulares y equipos pequeños que quieran usar su chatbot sin lidiar con la API.

Aplicando modelos de IA en tu negocio: la forma fácil

Elegir un modelo y pagar por el acceso a la API es solo el primer paso. El verdadero trabajo es convertir esa potencia bruta en una herramienta empresarial útil, como un agente de atención al cliente que realmente ayude a la gente. Esto generalmente implica una configuración muy complicada:

-

Tienes que conectar el modelo a todo el conocimiento de tu empresa, que podría estar repartido entre un centro de ayuda, wikis internas, Google Docs y conversaciones antiguas.

-

Necesitas construir un motor de flujos de trabajo que sepa cuándo escalar un ticket, cómo etiquetarlo correctamente o cuándo hacer cosas personalizadas como buscar el estado de un pedido.

-

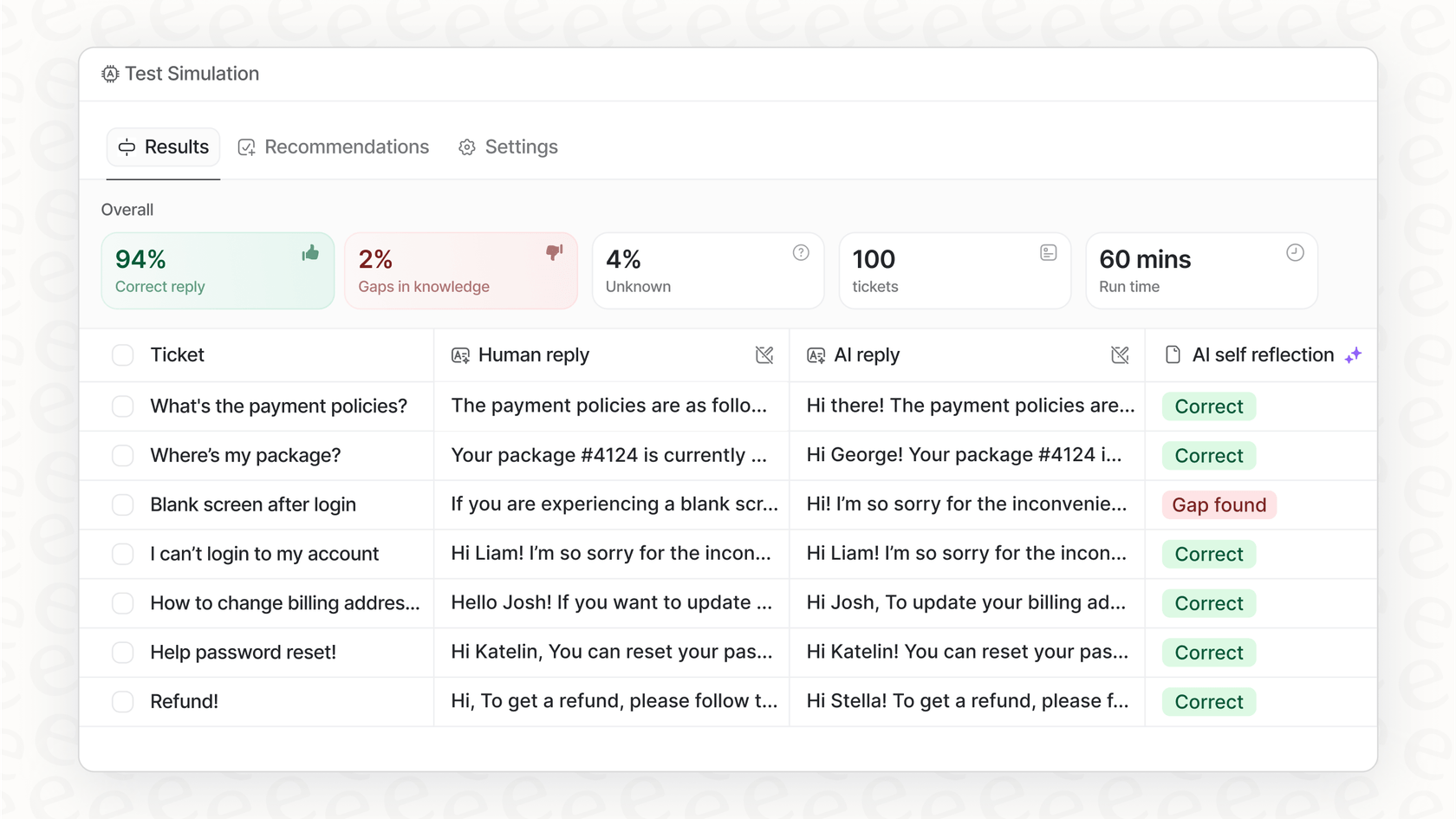

Necesitas una forma segura de probar todo con tus propios datos antes de dejar que hable con un cliente real.

Eso es un montón de trabajo pesado, y es exactamente el problema que una plataforma como eesel AI está diseñada para resolver. En lugar de que pases meses construyendo toda esta infraestructura desde cero, eesel AI te ofrece una solución de autoservicio que hace el trabajo duro por ti. Actúa como una capa inteligente sobre los potentes modelos de Google y Mistral, haciéndolos útiles para tu negocio desde el primer momento.

- Unificación instantánea del conocimiento: eesel AI se conecta a todas tus herramientas con integraciones de un solo clic para plataformas como Zendesk y Confluence. Aprende de tu centro de ayuda, tus documentos e incluso de tus tickets de soporte anteriores para ponerse al día sobre tu negocio desde el primer día.

Tomando la decisión correcta para tus necesidades

Entonces, ¿cuál es el veredicto final en el enfrentamiento Gemini vs. Mistral? Sinceramente, no hay un único ganador. Todo se reduce a lo que necesitas hacer. Aquí tienes una guía rápida:

-

Elige Gemini si tu tarea principal es analizar documentos o conjuntos de datos enormes, si ya estás integrado en el ecosistema de Google Cloud, o si necesitas una redacción creativa de primer nivel y funciones multimodales.

-

Elige Mistral si lo que más te importa es la eficiencia, el coste y tener la flexibilidad de modelos de código abierto que puedes alojar tú mismo. También es probablemente la mejor opción si necesitas una IA que te dé respuestas concisas y listas para el negocio sin la paja extra.

El mejor modelo es siempre el que se ajusta al trabajo que necesitas hacer. Pero recuerda, el modelo en sí es solo una pieza del rompecabezas. La verdadera magia ocurre cuando lo integras y lo usas dentro de tus flujos de trabajo para resolver problemas de negocio reales.

¿Listo para convertir el poder de estos modelos de IA de primer nivel en resultados de negocio reales? eesel AI te ofrece la plataforma completa para construir, simular y lanzar agentes de IA para atención al cliente y conocimiento interno, todo en unos pocos clics. Comienza tu prueba gratuita hoy.

Este vídeo ofrece una útil prueba cara a cara para ver cómo se desenvuelven Gemini y Mistral AI en diversas tareas.

Preguntas frecuentes

Los modelos de Mistral suelen ser preferidos por su franqueza y sus respuestas "sin paja", lo que los hace ideales para flujos de trabajo empresariales que necesitan respuestas fiables y concisas sin relleno conversacional adicional.

Gemini 1.5 Pro tiene una clara ventaja aquí debido a su enorme ventana de contexto de 2 millones de tokens, lo que le permite ingerir y analizar muchísima más información que las ofertas actuales de Mistral.

Los modelos más pequeños y eficientes de Mistral ofrecen precios competitivos para tareas de alto volumen. El modelo 1.5 Flash de Gemini también proporciona una opción muy rentable en cuanto a velocidad y eficiencia.

Mistral AI es muy conocido por sus modelos de pesos abiertos como Mistral 7B y Mixtral, que brindan a los desarrolladores la flexibilidad de alojarlos, modificarlos y afinarlos en sus propios servidores.

Gemini suele brillar en tareas creativas, ofreciendo un estilo más conversacional y completo, adecuado para textos de marketing, brainstorming y generación de textos que se sienten matizados y humanos.

Aunque ambos ofrecen APIs, integrar modelos como Gemini o Mistral de manera efectiva a menudo requiere un desarrollo significativo. Plataformas como eesel AI simplifican esto proporcionando una capa inteligente para unificar el conocimiento y lanzar agentes de IA rápidamente, independientemente del modelo subyacente.

Compartir esta entrada

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.