Seamos honestos, la IA generativa se siente un poco como magia. Escribes un mensaje, y unos segundos después, tienes un correo electrónico, un fragmento de código o incluso un sitio web completo. Es perfecto. Pero esa sensación de "sin esfuerzo" esconde un gran secreto: la máquina detrás de la cortina es increíblemente voraz en cuanto a energía, y su apetito está creciendo como loco.

Con el lanzamiento de modelos más nuevos como GPT-5 en el horizonte, los investigadores están comenzando a dar la alarma sobre cuánta energía consumen estas cosas. Esto no es solo un problema ambiental abstracto, rápidamente se está convirtiendo en un problema real de negocios. Los costos ocultos de operar estos modelos masivos, que lo hacen todo, están volviéndose demasiado grandes para ignorar.

En este artículo, levantaremos la cortina sobre el "qué" y el "por qué" de las demandas energéticas de la IA. Veremos el verdadero impacto ambiental y te mostraremos una manera más inteligente para que tu negocio adopte la IA de una manera sostenible y mucho más efectiva.

¿Qué es el uso de energía de ChatGPT?

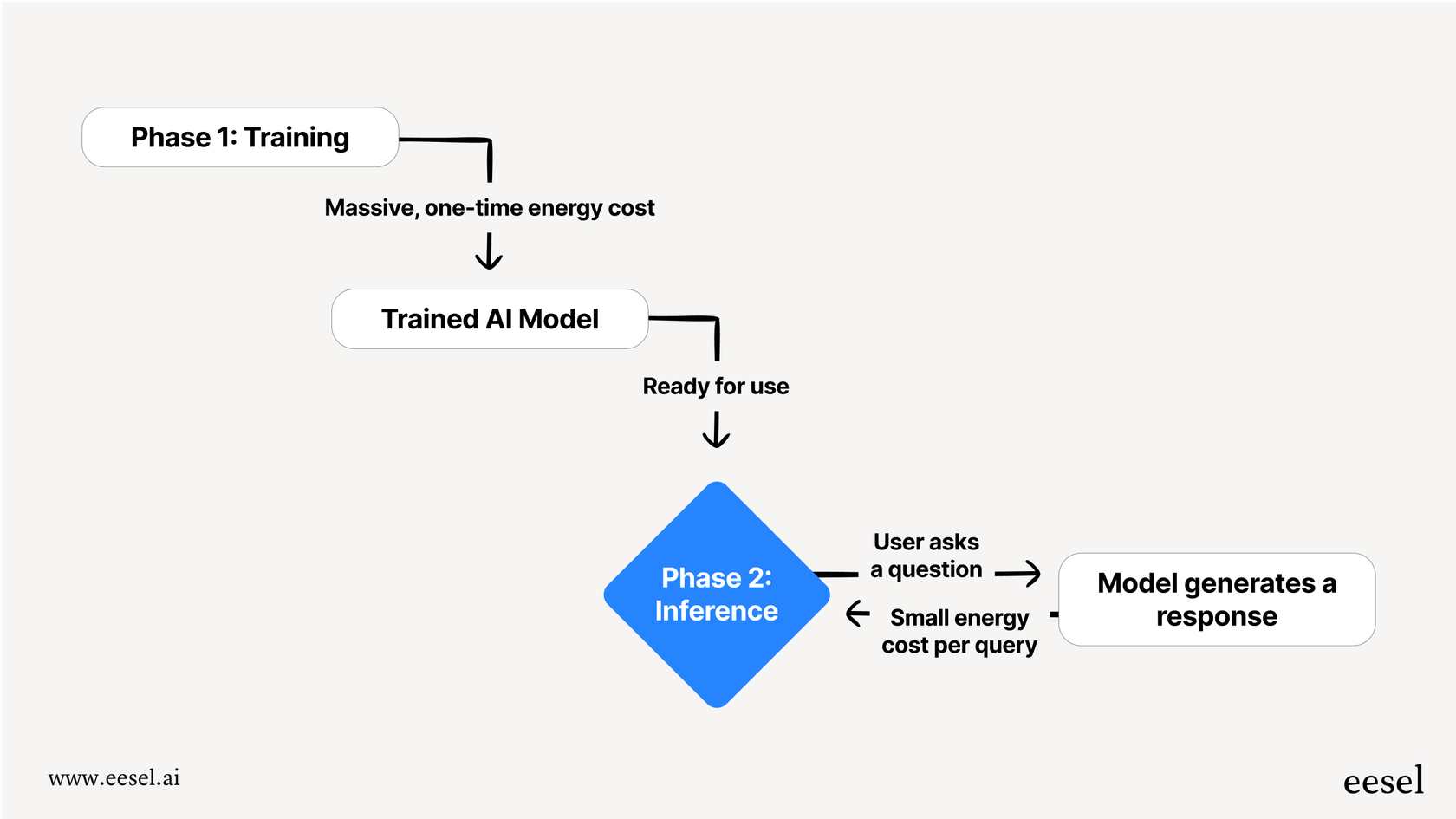

Cuando hablamos de una IA que consume energía, no es solo una cosa. El proceso se divide en dos fases principales: entrenamiento e inferencia. La forma más fácil de pensarlo es como una IA yendo a la escuela, y luego una IA realmente yendo a trabajar.

Entrenamiento Esta es la fase de "escolarización" de la IA, y es increíblemente intensa. Implica alimentar a un modelo con una cantidad colosal de datos, a menudo una gran parte de internet, para que pueda aprender patrones, lenguaje y conceptos. Esto requiere una enorme cantidad de poder de cómputo funcionando 24/7 durante semanas o incluso meses. Es un enorme costo energético único que debe pagarse por cada nueva versión de un modelo.

Inferencia La inferencia es lo que sucede cuando realmente usas la IA, como cuando le haces una pregunta a ChatGPT. El modelo toma lo que aprendió durante el entrenamiento para "inferir" la mejor respuesta. Aunque una sola consulta usa una pequeña fracción de la energía necesaria para el entrenamiento, es el volumen total lo que es asombroso. Para una herramienta que maneja miles de millones de solicitudes al día, la energía total gastada en inferencia durante su vida útil puede fácilmente superar el costo inicial de entrenamiento.

Una mirada más cercana al sorprendente uso de energía de ChatGPT

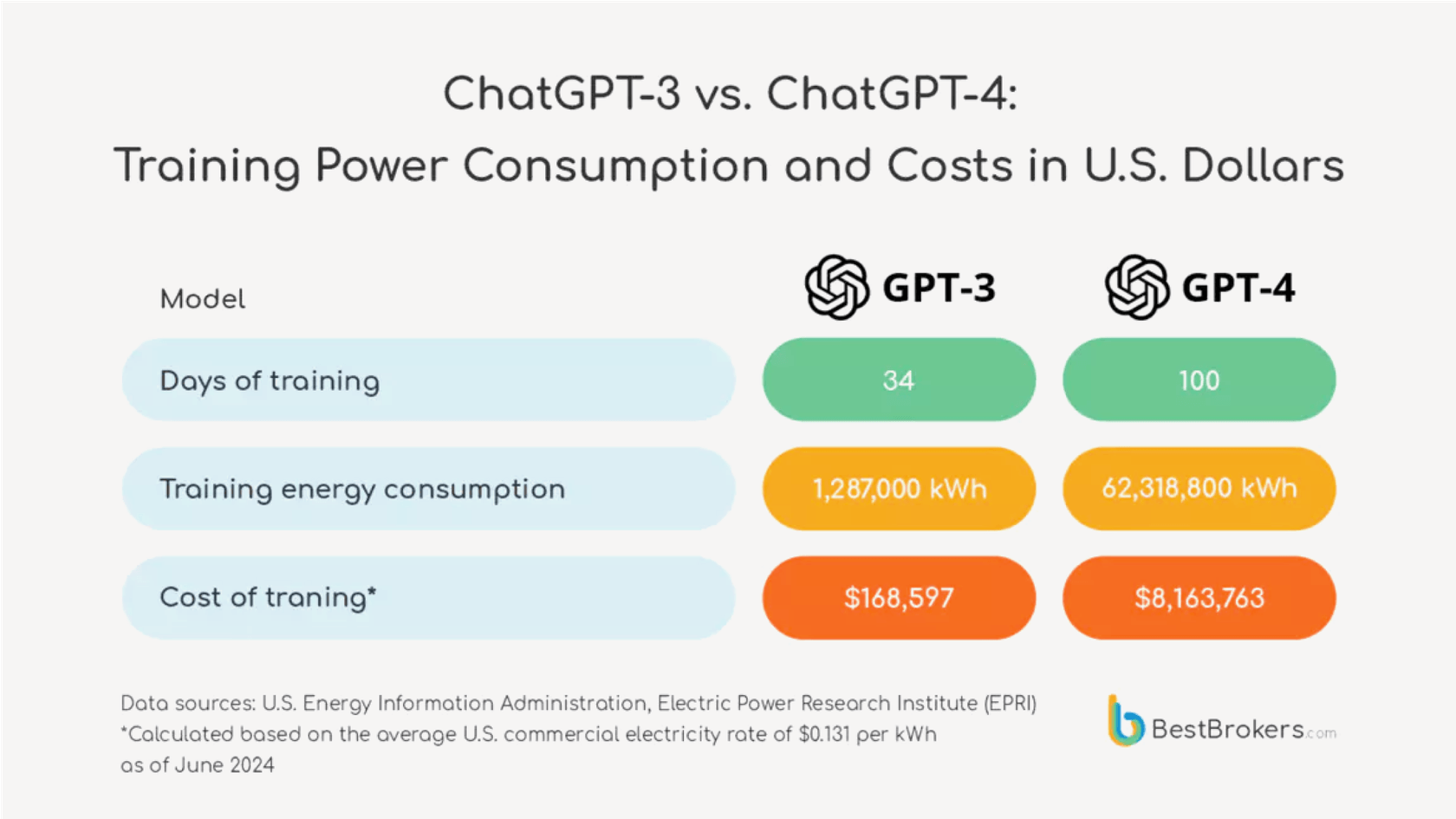

El salto en la demanda de energía de una generación de modelos a la siguiente no es un pequeño paso adelante, es un gran salto.

Pongamos algunos números reales a esto. A mediados de 2023, pedirle a un modelo como ChatGPT una receta simple podría haber usado alrededor de 2 vatios-hora de electricidad. Ahora, avanzando hacia el próximo GPT-5. Los investigadores del laboratorio de IA de la Universidad de Rhode Island estiman que el nuevo modelo podría usar un promedio de 18 vatios-hora para una respuesta de longitud media, y a veces hasta 40 vatios-hora.

Una comparación visual lado a lado.

- A la izquierda, bajo el título "GPT-4 (2023)", un icono de una pequeña bombilla con el texto "2 vatios-hora por consulta" al lado. Debajo de eso, el texto dice: "Suficiente para encender una bombilla durante 2 minutos."

- A la derecha, bajo el título "GPT-5 (Estimado)", un icono de una bombilla mucho más grande y brillante con el texto "18 vatios-hora por consulta" al lado. Debajo de eso, el texto dice: "Suficiente para encender la misma bombilla durante 18 minutos."

- Una gran flecha apuntando de izquierda a derecha muestra un "9x Aumento" en el consumo de energía. El diseño general debe ser limpio y fácil de leer, enfatizando el drástico aumento en la demanda de energía.

Eso es un gran aumento. Muestra que cada nueva generación de estos modelos que lo hacen todo se está volviendo exponencialmente más voraz en cuanto a energía.

Para darte un poco de perspectiva, 18 vatios-hora es suficiente para encender una bombilla incandescente antigua durante 18 minutos. Ahora, piensa en el panorama más amplio. Se informa que ChatGPT maneja alrededor de 2.5 mil millones de solicitudes al día. Si todas esas fueran manejadas por GPT-5, el consumo total de energía diario podría ser suficiente para alimentar 1.5 millones de hogares en EE.UU. De repente, esa respuesta de IA "sin esfuerzo" no parece tan gratuita, ¿verdad?

| Versión del Modelo | Energía Promedio por Consulta (Vatios-hora) | Equivalente en el Mundo Real |

|---|---|---|

| Era GPT-4 (2023) | ~2 Wh | Encender una bombilla incandescente durante 2 minutos |

| GPT-4o | ~0.34 Wh (figura de Altman) | Una bombilla de alta eficiencia por unos minutos |

| GPT-5 (Estimado) | ~18 Wh | Encender una bombilla incandescente durante 18 minutos |

Secretos y costos ocultos del uso de energía de ChatGPT

Tratar de averiguar el verdadero costo ambiental de la IA es un negocio sorprendentemente turbio, principalmente porque las empresas que construyen estos modelos son increíblemente secretas sobre cuántos recursos utilizan.

¿Dónde están los datos oficiales sobre el uso de energía de ChatGPT?

OpenAI y sus competidores no han publicado cifras oficiales de energía específicas del modelo desde que GPT-3 salió en 2020. El CEO de OpenAI, Sam Altman, compartió en su blog que una consulta usa alrededor de 0.34 vatios-hora, pero esos números vinieron sin ningún contexto sobre qué modelo estaba hablando o cualquier dato para respaldarlo, haciéndolos prácticamente imposibles de verificar.

Esta falta de transparencia es un gran problema. Como señaló un experto en clima, "Me sorprende que puedas comprar un coche y saber cuántas millas por galón consume, pero usamos todas estas herramientas de IA todos los días y no tenemos absolutamente ninguna métrica de eficiencia." Sin datos claros, es difícil para cualquier negocio tomar una decisión informada sobre el verdadero costo de las herramientas que están usando.

Uso de energía de ChatGPT: Se trata de más que solo electricidad

El precio ambiental va mucho más allá de la factura de electricidad. Hay algunos otros costos ocultos que no se mencionan lo suficiente.

- Es un trabajo sediento: Los centros de datos se calientan increíblemente, y enfriarlos requiere una cantidad sorprendente de agua fresca. Se estimó que solo entrenar GPT-3 usó más de 700,000 litros de agua. A medida que los modelos se hacen más grandes, su sed de agua crece, poniendo una verdadera presión sobre los recursos locales.

- Hardware y desechos electrónicos: La IA generativa funciona con procesadores especializados y voraces en energía (GPUs). La fabricación de estos chips tiene su propia huella ambiental, desde la minería de materias primas hasta la energía utilizada para fabricarlos. La carrera constante por hardware más potente también significa que los chips más antiguos se descartan más rápido, sumando a un enorme problema de desechos electrónicos.

- Diseñados para ser reemplazados: El mundo de la IA se mueve a la velocidad de la luz. Se lanzan nuevos modelos cada pocos meses, haciendo que los antiguos queden obsoletos casi de la noche a la mañana. Esto significa que la enorme cantidad de energía que se invirtió en entrenar un modelo que se reemplaza tan rápidamente se desperdicia esencialmente.

Un camino más inteligente: Eficiencia más allá del alto uso de energía de ChatGPT

La estrategia actual de simplemente construir modelos de IA más grandes y más grandes de propósito general es un enfoque de fuerza bruta. No es sostenible, y para la mayoría de las empresas, ni siquiera es la mejor herramienta para el trabajo.

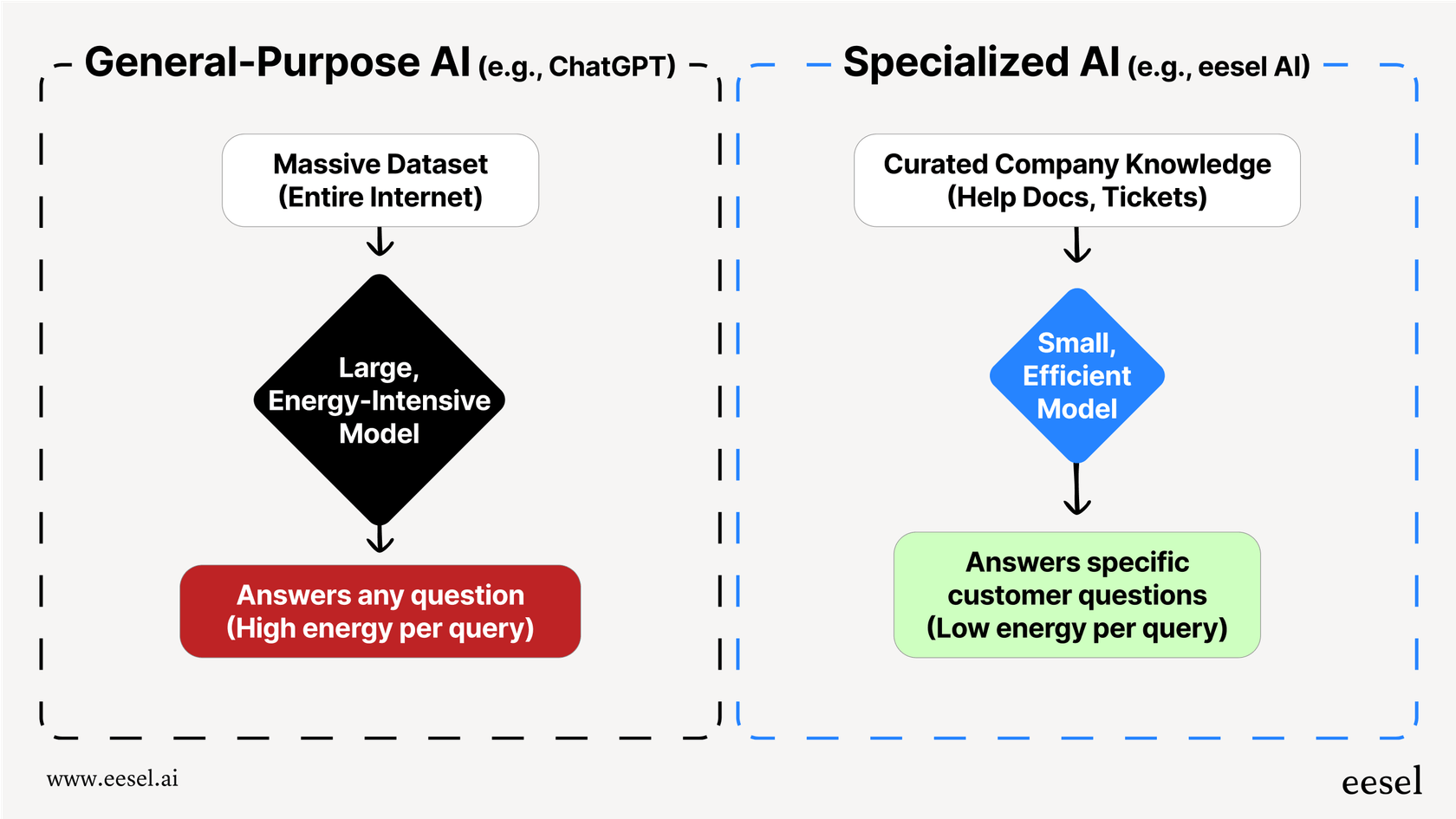

El problema es que modelos como ChatGPT están diseñados para saber un poco sobre todo, desde sonetos de Shakespeare hasta física cuántica. Para hacer eso, tienen que ser enormes, lo que los hace increíblemente intensivos en energía. Pero si solo necesitas responder a la pregunta de un cliente sobre tu política de envíos, usar una IA general masiva es un completo exceso. Es como usar una supercomputadora para hacer matemáticas básicas, simplemente no es eficiente.

Hay una manera mucho más inteligente de hacer esto: usar modelos de IA más pequeños y especializados que están entrenados solo con los datos que necesitan para hacer su trabajo. Este enfoque es mucho más eficiente por diseño. Entrenar una IA en un conjunto curado de los artículos de ayuda de tu empresa, tickets de soporte pasados y documentos de productos toma una fracción minúscula de la energía necesaria para entrenarla en todo internet.

El resultado no es solo una IA más sostenible, es una mejor. Una IA especializada da respuestas que son más precisas, consistentes y perfectamente alineadas con la marca porque no se distrae con información irrelevante de sitios web públicos.

Esta es toda la idea detrás de lo que hacemos en eesel AI. En lugar de pedirte que desmanteles tus sistemas existentes y los reemplaces con una sola IA voraz en energía, eesel se conecta directamente a tu mesa de ayuda y fuentes de conocimiento. Aprende de tu contenido en las herramientas que ya usas, como Zendesk, Confluence, y Google Docs, para crear un agente de soporte de IA eficiente y preciso. Esto te permite evitar el enorme drenaje de energía y los dolores de cabeza operativos de un modelo de propósito general mientras das mejores respuestas, más relevantes, a tus clientes.

Tu estrategia de IA y el impacto del uso de energía de ChatGPT

El consumo de energía de los grandes modelos de IA ya no es solo un tema para los investigadores, es un problema real de negocios. Con cada nueva generación, modelos como GPT-5 se están volviendo exponencialmente más voraces en energía, y su verdadero costo está oculto tras un muro de secretismo e incluye mucho más que solo electricidad.

Para la mayoría de las necesidades empresariales, especialmente en servicio al cliente o soporte interno, usar una IA gigante de propósito general no es la opción más efectiva o responsable. Es ineficiente, costoso y a menudo da respuestas menos precisas para tu caso de uso específico.

Un enfoque especializado e integrado es una alternativa mucho más sostenible, rentable y precisa. Al entrenar una IA en tu propio conocimiento, puedes construir un sistema que sea tanto poderoso como eficiente.

Si estás listo para construir un sistema de soporte de IA poderoso y eficiente sin la enorme factura de energía, mira cómo eesel AI funciona con tus herramientas existentes para ofrecer respuestas precisas y alineadas con la marca. Comienza una prueba gratuita o reserva una demostración hoy.

Preguntas frecuentes

La alta demanda de energía indica ineficiencia. Usar un modelo masivo y de propósito general para una tarea empresarial específica es como usar una supercomputadora para hacer cálculos simples, es excesivo y a menudo conduce a resultados menos precisos y más lentos para tus necesidades específicas.

Es mucho más que solo electricidad. La huella ambiental total incluye un consumo masivo de agua para enfriar los centros de datos, los recursos necesarios para fabricar hardware especializado y un creciente problema de desechos electrónicos a medida que la tecnología antigua se reemplaza rápidamente.

Sí, el aumento es significativo. Las estimaciones sugieren que los modelos más nuevos pueden ser exponencialmente más voraces en cuanto a energía, con algunas consultas utilizando casi diez veces la electricidad de las versiones anteriores. Esta tendencia de "más grande es mejor" no es sostenible.

Las principales empresas de IA son muy reservadas sobre su consumo de recursos, tratándolo como un secreto comercial. Esta falta de transparencia dificulta que las empresas y los consumidores comprendan los verdaderos costos ambientales y financieros de las herramientas que utilizan.

Absolutamente. Un modelo especializado se entrena solo con los datos relevantes de tu empresa, lo que requiere una fracción mínima de energía. Esto resulta en un sistema mucho más eficiente que no solo es sostenible, sino que también proporciona respuestas más precisas y relevantes para tu caso de uso específico.

Aunque el entrenamiento es increíblemente intensivo en energía, el volumen puro de consultas diarias (inferencia) puede fácilmente superar el costo inicial de entrenamiento a lo largo de la vida útil del modelo. Para una herramienta con miles de millones de usuarios diarios, la energía acumulada gastada en inferencia se convierte en el factor dominante.

Compartir esta entrada

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.