Generative KI ist in aller Munde, aber seien wir ehrlich, es gibt da einen großen Elefanten im Raum: Vertrauen. Besonders, wenn es um Kundendaten geht. Wie können Sie diese leistungsstarken neuen Tools nutzen, ohne den Datenschutz zu gefährden? Das ist eine berechtigte Sorge, die auch Kunden teilen. Tatsächlich sind fast drei Viertel von ihnen besorgt darüber, dass Unternehmen KI auf unethische Weise einsetzen könnten.

Der Salesforce Einstein Trust Layer ist der Versuch von Salesforce, dieses Problem zu lösen. Es ist ein Framework, das entwickelt wurde, um die nativen KI-Funktionen für große Unternehmen sicher genug zu machen, indem es sie in eine Schutzschicht aus Sicherheits- und Datenkontrollen hüllt.

Aber was genau leistet er im Alltag? Und noch wichtiger: Ist er die richtige Wahl für Ihr gesamtes Support-Team? Dieser Leitfaden führt Sie durch den Trust Layer, erklärt, was er ist, seine Hauptfunktionen, seine Grenzen in der Praxis und sein verwirrendes Preismodell. Am Ende werden Sie ein klares Bild haben, das Ihnen bei der Entscheidung hilft, ob dies die Lösung ist, die Sie benötigen, oder ob Sie mit einem flexibleren Tool besser bedient wären.

Was ist der Salesforce Einstein Trust Layer?

Einfach ausgedrückt ist der Salesforce Einstein Trust Layer ein Sicherheitsnetz für alle KI-Tools, die in die Salesforce-Plattform integriert sind. Es ist kein separates Add-on, das Sie kaufen; es ist die Hintergrundarchitektur, die immer aktiv ist, wenn Sie Tools wie Einstein Copilot oder den Prompt Builder verwenden.

Seine Hauptaufgabe ist es, als sicherer Vermittler zu fungieren. Er sitzt zwischen dem von Ihnen eingegebenen Prompt und dem Large Language Model (LLM), das eine Antwort entwickelt. In dieser Position fängt er Ihre Daten ab, führt eine Reihe von Sicherheitsprüfungen durch und stellt sicher, dass Ihre sensiblen Unternehmens- und Kundendaten die Salesforce-Umgebung niemals verlassen. Stellen Sie ihn sich wie einen Türsteher für Ihre KI vor. Er steht zwischen Ihrer Anfrage und dem KI-Modell, prüft die „Identität“ Ihrer Daten und sorgt dafür, dass nichts Sensibles an ihm vorbeikommt.

graph TD A[User enters a prompt in Salesforce] --> B{Einstein Trust Layer}; B --> C[1. Secure Data Retrieval from CRM]; C --> D[2. Data Masking for PII]; D --> E[3. Prompt Defense & Toxicity Check]; E --> F[LLM Partner e.g., OpenAI]; F --> G{Einstein Trust Layer}; G --> H[4. Toxicity Check on Response]; H --> I[5. Un-masking Data]; I --> J[User receives a secure, relevant response]; style F fill:#ADD8E6,stroke:#333,stroke-width:2px style B fill:#90EE90,stroke:#333,stroke-width:2px style G fill:#90EE90,stroke:#333,stroke-width:2px Alternativer Titel: Ein Workflow-Diagramm des Salesforce Einstein Trust Layer in Aktion.

Hauptmerkmale des Salesforce Einstein Trust Layer

Der Trust Layer ist keine einzelne Komponente; er besteht aus einer Handvoll von Elementen, die zusammenarbeiten, um Ihre KI-Interaktionen sicher zu halten. Um wirklich zu verstehen, was er leistet, muss man sich jedes Teil ansehen. Hier ist eine Aufschlüsselung seiner wichtigsten Merkmale.

Sicherer Datenabruf und dynamisches Grounding

Eine der größten Enttäuschungen bei der Verwendung einer allgemeinen KI wie ChatGPT ist, dass sie absolut nichts über Ihr Unternehmen weiß. Bitten Sie sie, eine Kunden-E-Mail zu schreiben, und Sie erhalten eine Vorlage, die klingt, als wäre sie von einem Roboter verfasst worden. Hier hilft das dynamische Grounding. Der Trust Layer versorgt die KI in Echtzeit mit Kontext aus Ihren CRM-Daten, was ihre Antworten wesentlich relevanter und persönlicher macht.

Dies wird durch den sicheren Datenabruf gesteuert. Der Trust Layer überprüft doppelt, dass die KI nur auf Daten zugreift, die der Benutzer auch einsehen darf. Er respektiert automatisch alle Ihre bestehenden Salesforce-Benutzerberechtigungen und Feldebenensicherheit, sodass ein Mitarbeiter nicht versehentlich Informationen aus einem Datensatz verwenden kann, auf den er keinen Zugriff haben sollte.

Datenmaskierung für private Informationen

Dies ist ein entscheidender Punkt. Bevor ein Prompt an ein externes LLM gesendet wird, findet und verbirgt die Datenmaskierungsfunktion des Trust Layer automatisch sensible Informationen. Sie sucht nach Details wie Namen, E-Mail-Adressen, Telefonnummern und Kreditkarteninformationen und ersetzt sie durch generische Platzhalter.

Dafür werden zwei Methoden verwendet: musterbasierte Erkennung (für Dinge in einem Standardformat, wie eine Telefonnummer) und feldbasierte Erkennung (die die Datenklassifizierungen verwendet, die Sie bereits in Salesforce eingerichtet haben). Nachdem das LLM seine Antwort zurückgesendet hat, hebt der Trust Layer die Maskierung der Daten auf und fügt die echten Informationen wieder ein. Der Benutzer sieht die korrekten Details, aber das LLM hat die privaten Daten nie gesehen.

Beschreibung: Die Infografik sollte zwei Seiten haben.

Linke Seite (Vorher): Zeigt eine Benutzereingabe, die sensible Daten wie „John Does Telefonnummer lautet 555-1234“ enthält. Die Daten sind rot hervorgehoben. Ein Pfeil zeigt von hier auf das Einstein Trust Layer-Symbol.

Rechte Seite (Nachher): Zeigt den an das LLM gesendeten Prompt mit den maskierten Daten: „Die Telefonnummer von [NAME] lautet [TELEFONNUMMER]“. Ein Pfeil zeigt vom LLM zurück zum Trust Layer, der dann die endgültige, demaskierte Antwort an den Benutzer sendet.

Alternativer Titel: Wie der Salesforce Einstein Trust Layer Datenmaskierung zum Schutz personenbezogener Daten einsetzt.

Zero-Data-Retention-Richtlinie

Eine häufige Sorge bei KI-Modellen von Drittanbietern ist, was mit Ihren Daten geschieht, nachdem Sie sie verwendet haben. Salesforce begegnet dem mit seiner Zero-Data-Retention-Richtlinie. Sie haben Vereinbarungen mit ihren LLM-Partnern, wie OpenAI, um zu garantieren, dass Ihre Daten niemals gespeichert oder zum Training ihrer Modelle verwendet werden.

Das bedeutet, nachdem die KI Ihnen eine Antwort gegeben hat, werden Ihr Prompt und alle darin enthaltenen Daten von den Servern des LLM gelöscht. Nichts wird zur Überprüfung, zum Training oder für irgendetwas anderes aufbewahrt, was ein wesentlicher Bestandteil des Schutzes Ihrer Daten ist.

Toxizitätserkennung und Prompt-Verteidigung

Seien wir ehrlich, KI-Modelle können manchmal voreingenommene, unangemessene oder einfach nur seltsame Antworten generieren (oft als „Halluzinationen“ bezeichnet). Der Trust Layer verfügt über eine Toxizitätserkennung, die sowohl den Prompt des Benutzers als auch die Antwort der KI auf schädliche oder beleidigende Inhalte überprüft und alles markiert, was unangemessen erscheint.

Er verwendet auch eine Prompt-Verteidigung, was im Grunde eine Reihe von Anweisungen ist, die dem LLM sagen, wie es sich verhalten soll. Diese Leitplanken halten die KI an der kurzen Leine, reduzieren die Wahrscheinlichkeit, dass sie vom Thema abweicht, und schützen vor Angriffen, bei denen jemand versucht, die KI dazu zu bringen, ihre eigenen Sicherheitsregeln zu brechen.

Audit-Trail und Überwachung

Um die Verantwortlichkeit aller zu gewährleisten, führt der Trust Layer einen detaillierten Audit-Trail. Jeder Prompt, jede Antwort und jedes Benutzerfeedback wird protokolliert und sicher in der Salesforce Data Cloud gespeichert. Dies gibt Administratoren die Möglichkeit zu sehen, wie KI genutzt wird, spezifische Konversationen zu überprüfen und sicherzustellen, dass alles den Unternehmensrichtlinien entspricht.

Einschränkungen des Salesforce Einstein Trust Layer

Obwohl der Salesforce Einstein Trust Layer eine ziemlich gute Arbeit leistet, um KI-Konversationen zu sichern, die innerhalb der Salesforce-Plattform stattfinden, schafft die Tatsache, dass er fest integriert ist, für die meisten Teams heute echte Probleme.

Das Problem: Ein geschlossenes Ökosystem

Das größte Problem ist, dass der Einstein Trust Layer nur dazu konzipiert ist, Daten zu schützen, die in Salesforce ein- und ausgehen. Aber das Wissen Ihres Unternehmens befindet sich nicht nur an einem Ort. Die meisten Support-Teams sind auf eine Vielzahl verschiedener Tools angewiesen. Ihre Hilfeartikel könnten in einem Zendesk-Helpcenter liegen, Ihre internen Prozessdokumente in Confluence und die neuesten Produktupdates in einer Reihe von Google Docs.

Die KI von Salesforce kann auf dieses externe Wissen nicht einfach oder sicher zugreifen. Dies führt zu Wissenssilos und zwingt Ihre KI, Antworten auf der Grundlage eines winzigen Ausschnitts des gesamten Wissens Ihres Unternehmens zu finden. Das Ergebnis? Unvollständige Antworten und unzufriedene Kunden.

Komplizierte und langsame Einrichtung

Der Einstieg in Einstein ist nicht so einfach wie das Umlegen eines Schalters. Um überhaupt berechtigt zu sein, müssen Sie einen der teuersten Pläne von Salesforce haben, und dann müssen Sie ein kostspieliges Add-on kaufen. Das Ganze beinhaltet einen langen Verkaufszyklus und ein langwieriges Implementierungsprojekt.

Dies fühlt sich völlig unpassend für die Funktionsweise moderner Software an. Teams wollen Tools, die sie selbst ausprobieren und einrichten können, normalerweise in wenigen Minuten. Gezwungen zu sein, „Ihren Salesforce-Kundenbetreuer zu kontaktieren“, nur um anzufangen, ist ein riesiges Hindernis, das alles verlangsamt und eine Schicht frustrierender Bürokratie hinzufügt.

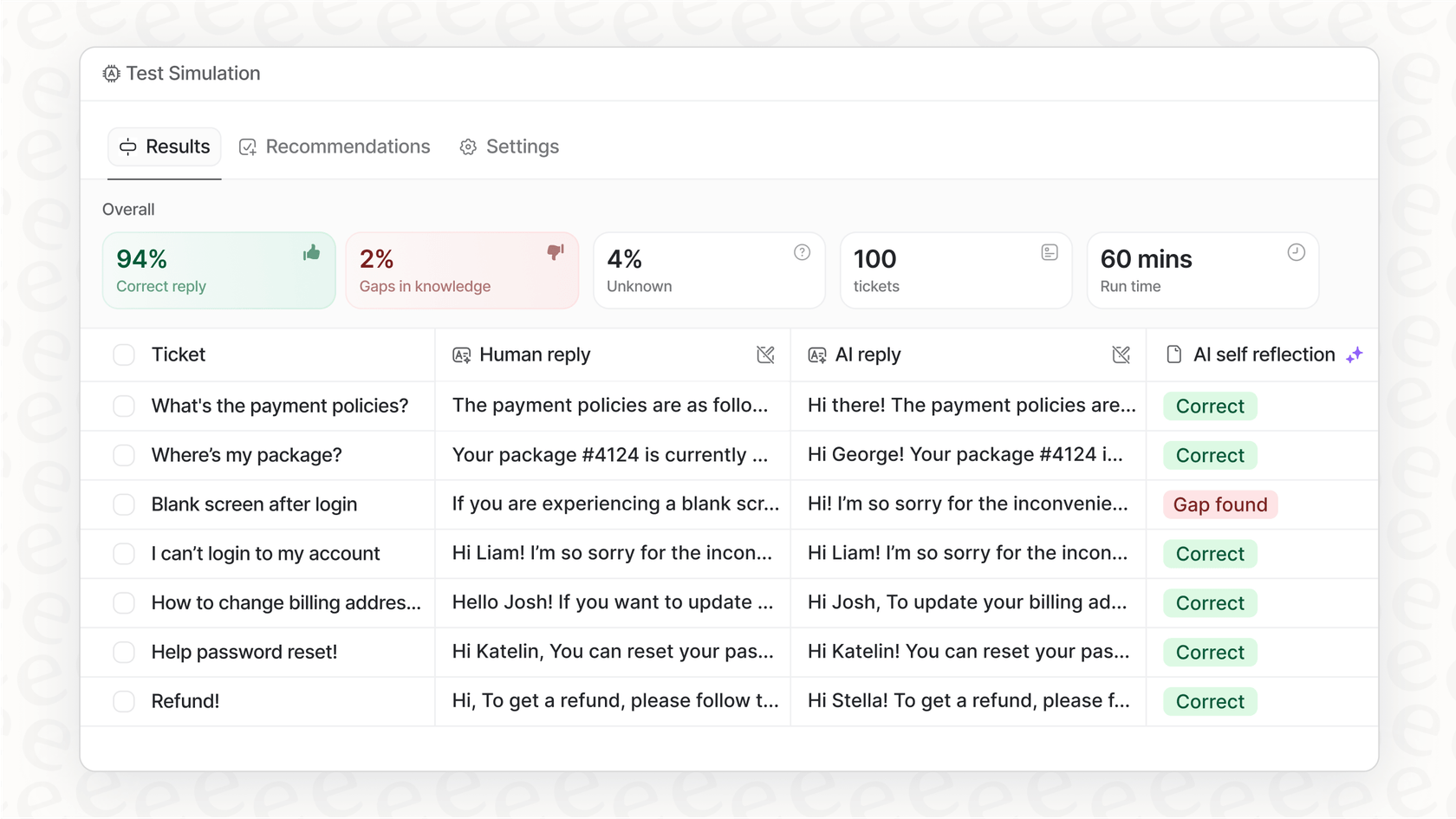

Die Angst vor einem „Big Bang“-Rollout

Ein neues KI-System an Live-Kundenchats zu testen, ist eine nervenaufreibende Vorstellung. Obwohl Salesforce einige Tools dafür hat, bietet es keine einfache Möglichkeit zu simulieren, wie die KI bei Tausenden Ihrer tatsächlichen vergangenen Tickets abschneiden würde. Ohne eine solche Art von historischem Testlauf ist es nahezu unmöglich zu wissen, wie gut die KI sein wird oder wie viele Tickets sie tatsächlich lösen kann.

Dieser Mangel an einem guten Simulationsmodus macht es für Support-Leiter schwierig, Automatisierung mit Zuversicht einzuführen. Sie werden oft in einen „Alles oder Nichts“-Start gedrängt, der den Arbeitsablauf Ihres Teams durcheinanderbringen und zu einem schrecklichen Kundenerlebnis führen kann, wenn die KI noch nicht ganz bereit für den Einsatz ist.

Salesforce Einstein Trust Layer: Preise und Pakete

Wenn Sie versuchen, einen einfachen Preis für die generative KI von Salesforce zu finden, suchen Sie vergeblich. Die Preisgestaltung ist verwirrend und alles andere als transparent.

Laut der eigenen Dokumentation von Salesforce ist deren generative KI nur verfügbar, wenn Sie einen Enterprise-, Performance- oder Unlimited-Plan haben. Darüber hinaus müssen Sie eines ihrer Add-ons kaufen, wie „Einstein for Service“ oder „Einstein 1 Service“. Und was kosten die? Sie haben es erraten: Sie müssen „Ihren Salesforce-Kundenbetreuer kontaktieren“, um ein Angebot zu erhalten.

Das bedeutet für Sie konkret:

-

Hohe Einstiegskosten: Sie müssen bereits für einen der Top-Pläne von Salesforce bezahlen, bevor Sie überhaupt über deren KI-Tools nachdenken können.

-

Überraschungskosten: Der Preis des Add-ons ist ein Geheimnis. Dies führt zu unvorhersehbaren Ausgaben, die privat verhandelt werden, was eine Budgetplanung unmöglich macht.

-

Anbieterabhängigkeit: Dieses Preismodell ist darauf ausgelegt, Sie tiefer in die Salesforce-Welt zu ziehen, was es schwieriger und teurer macht, später zu anderen Tools zu wechseln, wenn sich Ihre Bedürfnisse ändern.

Die Alternative: Eine flexible KI-Schicht für all Ihre Tools

Für Teams, die eine KI-Lösung benötigen, die mit all ihren Tools funktioniert, nicht nur mit einem, gibt es einen besseren Weg. eesel AI wurde entwickelt, um diese flexible KI-Schicht zu sein, die die Probleme geschlossener Plattformen wie Salesforce löst.

In Minuten live gehen, nicht in Monaten

Vergessen Sie die langen Verkaufsgespräche und Implementierungsprojekte, die Salesforce erfordert. eesel AI ist vollständig im Self-Service. Sie können sich anmelden, Ihren Helpdesk wie Zendesk oder Freshdesk mit einem einzigen Klick verbinden und haben in wenigen Minuten einen funktionierenden AI Copilot – ohne obligatorische Demo oder Verkaufsgespräch.

Besser noch, eesel AI verfügt über einen leistungsstarken Simulationsmodus, mit dem Sie Ihr Setup an Tausenden Ihrer vergangenen Support-Tickets testen können. Dies gibt Ihnen eine solide Prognose Ihrer Automatisierungsrate und Kosteneinsparungen, bevor Sie live gehen, und macht jegliches Rätselraten bei Ihrem Rollout überflüssig.

Verbinden Sie Ihr gesamtes Wissen, nicht nur Salesforce-Daten

eesel AI verbindet sich mit all Ihren Wissensquellen, nicht nur mit einer einzigen Plattform. Es integriert sich mit über 100 Tools, einschließlich Wikis wie Confluence und Google Docs, Chat-Anwendungen wie Slack und sogar E-Commerce-Plattformen wie Shopify. Indem es Ihre vergangenen Tickets und Makros zusammen mit Ihren Hilfeartikeln und internen Dokumenten analysiert, baut eesel AI eine wirklich vollständige Wissensdatenbank auf. Dies stellt sicher, dass Ihre KI jedes Mal genaue, kontextbezogene Antworten liefert, egal wo sich die Informationen befinden.

Volle Kontrolle und klare Preise

Mit eesel AI erhalten Sie eine vollständig anpassbare Workflow-Engine, sodass Sie genau entscheiden können, welche Tickets die KI bearbeiten soll und was sie tun kann, von der einfachen Triage bis zur Abfrage von Bestellinformationen.

Und wenn es um die Kosten geht, gibt es keine versteckten Haken. eesel AI bietet transparente, vorhersehbare Preispläne ohne Gebühren pro gelöstem Fall. Sie können mit einem flexiblen monatlichen Plan beginnen und jederzeit kündigen, was Ihnen die Freiheit gibt, nach oben oder unten zu skalieren, ohne in einem langfristigen Vertrag gefangen zu sein.

| Merkmal | Salesforce Einstein Trust Layer | eesel AI |

|---|---|---|

| Einrichtungszeit | Wochen bis Monate; Vertrieb erforderlich | Minuten; vollständig im Self-Service |

| Wissensquellen | Hauptsächlich Salesforce-Daten | Über 100 Integrationen (Helpdesks, Wikis usw.) |

| Simulation | Begrenzt und komplex zu konfigurieren | Integriert; Simulation mit Tausenden von früheren Tickets |

| Preismodell | Intransparent; erfordert Enterprise-Pläne + Add-ons | Transparente, feste monatliche Gebühren; keine versteckten Kosten |

| Flexibilität | Bindet Sie an das Salesforce-Ökosystem | Funktioniert mit Ihren bestehenden Tools |

Vertrauen in KI bedeutet mehr als eine einzige Plattform

Der Salesforce Einstein Trust Layer ist ein solides und notwendiges Sicherheits-Framework, wenn Ihr Unternehmen voll und ganz auf Salesforce setzt. Er bietet wichtige Funktionen wie Datenmaskierung, Zero-Retention-Richtlinien und einen Audit-Trail, die für jede KI auf Unternehmensebene eine Grundvoraussetzung sind.

Allerdings ist seine größte Stärke, tief in Salesforce verwoben zu sein, auch seine größte Schwäche. Er schafft ein geschlossenes Ökosystem, das einfach nicht zur Arbeitsweise moderner Teams passt, bei denen das Wissen über Dutzende verschiedener Tools verteilt ist. In der heutigen Welt muss eine vertrauenswürdige KI mehr als nur sicher sein; sie muss das Gesamtbild sehen.

Für die meisten Support-Teams muss eine wirklich hilfreiche KI-Lösung flexibel und einfach einzurichten sein und in der Lage sein, all Ihr Wissen zu verbinden, wo auch immer es sich befindet. Echtes Vertrauen aufzubauen bedeutet, Ihrem Team eine KI zu geben, die das vollständige Bild hat und nicht nur einen winzigen Ausschnitt davon.

Nächste Schritte

Wenn Sie nach einer sicheren KI-Lösung suchen, die mit all Ihren bereits vorhandenen Tools funktioniert, nicht nur mit einem, dann sind Sie bereit für einen flexibleren Ansatz.

Starten Sie kostenlos mit eesel AI und sehen Sie, wie schnell Sie den Support automatisieren können, indem Sie sich mit den Tools verbinden, die Ihr Team bereits liebt.

Häufig gestellte Fragen

Der Salesforce Einstein Trust Layer ist eine Sicherheitsarchitektur, die in die nativen KI-Funktionen von Salesforce integriert ist. Seine Hauptfunktion besteht darin, als sicherer Vermittler zwischen Benutzereingaben und großen Sprachmodellen (Large Language Models) zu fungieren und sicherzustellen, dass sensible Unternehmens- und Kundendaten innerhalb der Salesforce-Umgebung geschützt bleiben.

Er verwendet eine Datenmaskierungsfunktion, die sensible Details wie Namen und Kreditkarteninformationen automatisch identifiziert und durch generische Platzhalter ersetzt, bevor der Prompt an ein externes LLM gesendet wird. Nachdem das LLM eine Antwort geliefert hat, demaskiert der Trust Layer die Daten. Außerdem wird eine Zero-Data-Retention-Richtlinie angewendet, die sicherstellt, dass Ihre Daten niemals gespeichert oder zum Training von Drittanbieter-Modellen verwendet werden.

Eine wesentliche Einschränkung besteht darin, dass der Salesforce Einstein Trust Layer hauptsächlich dazu konzipiert ist, Daten ausschließlich innerhalb der Salesforce-Plattform zu schützen und zu nutzen. Das bedeutet, er hat Schwierigkeiten, auf Wissen zuzugreifen oder es zu sichern, das in anderen Tools wie Zendesk, Confluence oder Google Docs gespeichert ist, was zu Wissenssilos und potenziell unvollständigen KI-Antworten führt.

Der Zugang zur generativen KI von Salesforce, die den Salesforce Einstein Trust Layer beinhaltet, steht nur Kunden mit Enterprise-, Performance- oder Unlimited-Plänen zur Verfügung. Zusätzlich müssen Benutzer ein separates, oft nicht öffentlich gelistetes Add-on wie „Einstein for Service“ erwerben, dessen spezifische Preisgestaltung eine direkte Absprache mit einem Salesforce-Kundenbetreuer erfordert.

Der Salesforce Einstein Trust Layer verwendet dynamisches Grounding, um die KI mit Echtzeit-Kontext aus Ihren CRM-Daten zu versorgen, was die Antworten relevanter und persönlicher macht. Er umfasst auch Mechanismen zur Toxizitätserkennung und Prompt-Verteidigung, um unangemessene Inhalte zu erkennen, sowie Leitplanken, die die KI auf dem richtigen Weg halten und die Wahrscheinlichkeit irrelevanter oder schädlicher Ergebnisse verringern.

Die Einrichtung des Salesforce Einstein Trust Layer ist in der Regel kein schneller Prozess und erfordert oft einen langen Verkaufszyklus sowie ein ausgedehntes Implementierungsprojekt. Die Berechtigung erfordert, einen der teuersten Pläne von Salesforce zu haben, gefolgt vom Kauf eines zusätzlichen, kostspieligen Add-ons, was es weniger zu einer Self-Service-Lösung macht.

Diesen Beitrag teilen

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.