Wenn Sie Entwickler sind, haben Sie wahrscheinlich schon gesehen, was Modelle wie GPT-4o leisten können, und darüber nachgedacht, selbst etwas damit zu entwickeln. Der wichtigste Einstiegspunkt ist die OpenAI-API, aber die direkte Arbeit damit bedeutet, eine Menge an wiederkehrendem Code für HTTP-Anfragen schreiben zu müssen. Genau hier kommen die OpenAI-SDKs (Software Development Kits) ins Spiel. Sie sind im Grunde Werkzeugkästen für verschiedene Programmiersprachen, die den Aufruf der API erheblich vereinfachen.

Aber hier ist die Sache: Während die SDKs großartig für den Einstieg sind, ist die Entwicklung einer vollwertigen, produktionsreifen App für etwas wie den Kundensupport eine ganz andere Hausnummer. Es geht nicht nur um ein paar API-Aufrufe. Man muss an den Gesprächsverlauf denken, Daten aus verschiedenen Quellen einbeziehen und unzählige Tests durchführen. Das alles summiert sich zu einer Menge an Entwicklungszeit. Lassen Sie uns also durchgehen, was die OpenAI-SDKs sind, was Sie damit machen können und welche realen Komplexitäten es zu beachten gilt. Wir werden auch einen Weg betrachten, wie man leistungsstarke KI-Agenten viel schneller zum Laufen bringen kann.

Was sind die OpenAI-SDKs?

Im Kern ist die OpenAI-API ein RESTful-Dienst, mit dem Sie über HTTP kommunizieren. Sie könnten diese Anfragen selbst erstellen, aber das ist mühsam und fehleranfällig. OpenAI-SDKs sind offizielle Bibliotheken, die Ihnen die schwere Arbeit abnehmen. Sie bieten Ihnen einfache Funktionen und Klassen, um die API direkt aus Ihrer bevorzugten Programmiersprache heraus zu nutzen.

Stellen Sie sich ein SDK als eine benutzerfreundliche Hülle vor. Anstatt sich mit den Details von Authentifizierungs-Headern, der Formatierung von Anfragen und dem Parsen von Antworten herumzuschlagen, können Sie einfach einen direkten Funktionsaufruf wie „client.responses.create()“ tätigen.

OpenAI hat offizielle SDKs für eine Reihe beliebter Sprachen:

-

Python: Die erste Wahl für die meisten KI- und maschinellen Lernprojekte.

-

TypeScript / JavaScript (Node.js): Perfekt für Web-Apps und Backend-Dienste.

-

.NET: Für alle, die in der Welt von C# und Microsoft arbeiten.

-

Java: Eine solide Wahl für größere Anwendungen im Unternehmensstil.

-

Go: Großartig, wenn Sie Geschwindigkeit und gute Nebenläufigkeit benötigen.

Und wenn Ihre bevorzugte Sprache nicht auf dieser Liste steht, hat die Community wahrscheinlich eine Bibliothek dafür entwickelt. Das allgemeine Prinzip ist immer dasselbe: Installieren Sie das SDK, holen Sie sich Ihren geheimen API-Schlüssel aus Ihrem OpenAI-Dashboard und Sie können damit beginnen, die Modelle aus Ihrem Code aufzurufen.

Hauptfunktionen und Anwendungsfälle für die OpenAI-SDKs

Sobald Sie eingerichtet sind, eröffnen die SDKs die Tür zu vielen verschiedenen Möglichkeiten. Hier sind die wichtigsten Dinge, die damit entwickelt werden.

Text- und Antwortgenerierung

Das ist das A und O. Mit dem Endpunkt responses.create können Sie einen Prompt an ein Modell wie „gpt-4o“ senden und eine Textantwort erhalten. Dies ist die Grundlage für alles, von einem einfachen Inhaltsgenerator bis hin zu einem vollwertigen konversationellen Chatbot. Um dem Modell Kontext zu geben, können Sie eine Reihe von Nachrichten in Ihrer Anfrage übergeben, was ihm hilft, den Überblick über das Gespräch zu behalten.

Multimodalität (Bild-, Audio- und Dateianalyse)

Neuere Modelle wie GPT-4o sind nicht nur auf Text beschränkt; sie sind multimodal. Mit den OpenAI-SDKs können Sie verschiedene Arten von Inhalten in Ihre Prompts einfügen:

-

Bilder: Sie können eine Bild-URL übergeben oder eines direkt hochladen und das Modell bitten, Ihnen zu sagen, was darauf zu sehen ist, Fragen dazu zu beantworten oder sogar Text daraus zu extrahieren.

-

Audio: Die Modelle können Audiodateien in Text transkribieren.

-

Dateien: Sie können Dokumente wie PDFs hochladen und das Modell diese zusammenfassen oder Fragen basierend auf deren Inhalt beantworten lassen.

Modelle mit Tools erweitern (Funktionsaufrufe)

Hier wird es richtig interessant. Die „Tools“-Funktion (früher Funktionsaufrufe genannt) ermöglicht es Ihnen, dem Modell eine Reihe von benutzerdefinierten Funktionen zur Verfügung zu stellen, die es anfordern kann. Sie könnten beispielsweise eine Funktion namens get_weather definieren. Wenn ein Benutzer fragt: „Wie ist das Wetter in Paris?“, wird das Modell nicht einfach etwas erfinden. Es wird ein JSON-Objekt zurückgeben, das besagt, dass es Ihre Funktion get_weather mit dem Parameter location: "Paris" aufrufen möchte.

Ihr Code führt dann die Funktion aus, ruft die tatsächlichen Wetterdaten ab und speist diese Informationen zurück in das Modell. Das Modell verwendet diese Daten dann, um dem Benutzer eine natürlich klingende Antwort zu geben. So bauen Sie Apps, die mit der Außenwelt interagieren können.

Ein schneller Tipp: Während Sie Ihre eigenen Funktionsaufrufe erstellen können, um Bestelldaten aus Ihrer Datenbank abzufragen, müssen Sie die gesamte Backend-Logik selbst erstellen und hosten. Eine Alternative ist eine Plattform wie eesel AI, die Ihnen vorgefertigte KI-Aktionen und einen visuellen Workflow-Builder bietet. Sie können sich mit Tools wie Shopify oder internen Datenbanken verbinden, ohne die gesamte Infrastruktur von Grund auf neu schreiben zu müssen, was eine Menge Entwicklungszeit spart.

Entwicklung fortschrittlicher Agenten mit dem Agents SDK

Für komplexere Aufgaben hat OpenAI ein spezialisiertes Agents SDK. Dieses ist für die Entwicklung von "agentischen" Apps gedacht, bei denen eine KI mehrstufige Probleme bewältigen und sogar mit anderen KI-Agenten koordinieren kann. Das ist leistungsstark, aber auch ein großer Schritt in Sachen Komplexität.

Das Agents SDK basiert auf einigen Hauptideen:

-

Agenten: Ein LLM mit spezifischen Anweisungen und einem Toolkit von Funktionen, die es verwenden kann.

-

Übergaben (Handoffs): Dies ermöglicht es einem Agenten, eine Aufgabe an einen anderen, spezialisierteren Agenten weiterzugeben. Stellen Sie sich einen allgemeinen Triage-Agenten vor, der einen Fehlerbericht an einen technischen Support-Agenten übergibt.

-

Schutzmechanismen (Guardrails): Dies sind Regeln, die Sie einrichten, um die Arbeit eines Agenten zu überprüfen und sicherzustellen, dass er beim Thema bleibt und nicht aus dem Ruder läuft.

-

Sitzungen (Sessions): Das SDK verwaltet den Gesprächsverlauf automatisch für Sie, selbst wenn Aufgaben zwischen verschiedenen Agenten übergeben werden.

Mit dem Agents SDK können Sie recht anspruchsvolle Logik in Python oder TypeScript erstellen. Aber es ist ein sehr grundlegendes Werkzeug. Etwas zu bauen, das für ein Unternehmen zuverlässig genug ist, erfordert ein tiefes Verständnis des Agenten-Designs und solide Softwareentwicklung.

Genau hier ist eine speziell entwickelte Plattform wirklich nützlich. Ein Multi-Agenten-Supportsystem selbst zusammenzustellen, ist ein riesiges Unterfangen. Für geschäftliche Anforderungen wie den Kundenservice ist ein plattformbasierter Ansatz fast immer schneller und einfacher zu skalieren. Zum Beispiel bietet Ihnen eesel AI eine vollständig anpassbare Workflow-Engine. Sie können definieren, wie sich Ihre KI-Agenten verhalten sollen, Eskalationen einrichten (die wie Übergaben funktionieren) und Ihre Wissensquellen über ein einfaches Dashboard auswählen. So können Sie in Minuten live gehen, nicht in Monaten.

Die versteckten Kosten und Herausforderungen bei der Nutzung von OpenAI-SDKs

Die SDKs lassen den Einstieg einfach erscheinen, aber der Weg von einem einfachen Skript zu einer produktionsreifen App hat einige Hürden und versteckte Kosten, die Sie kennen sollten.

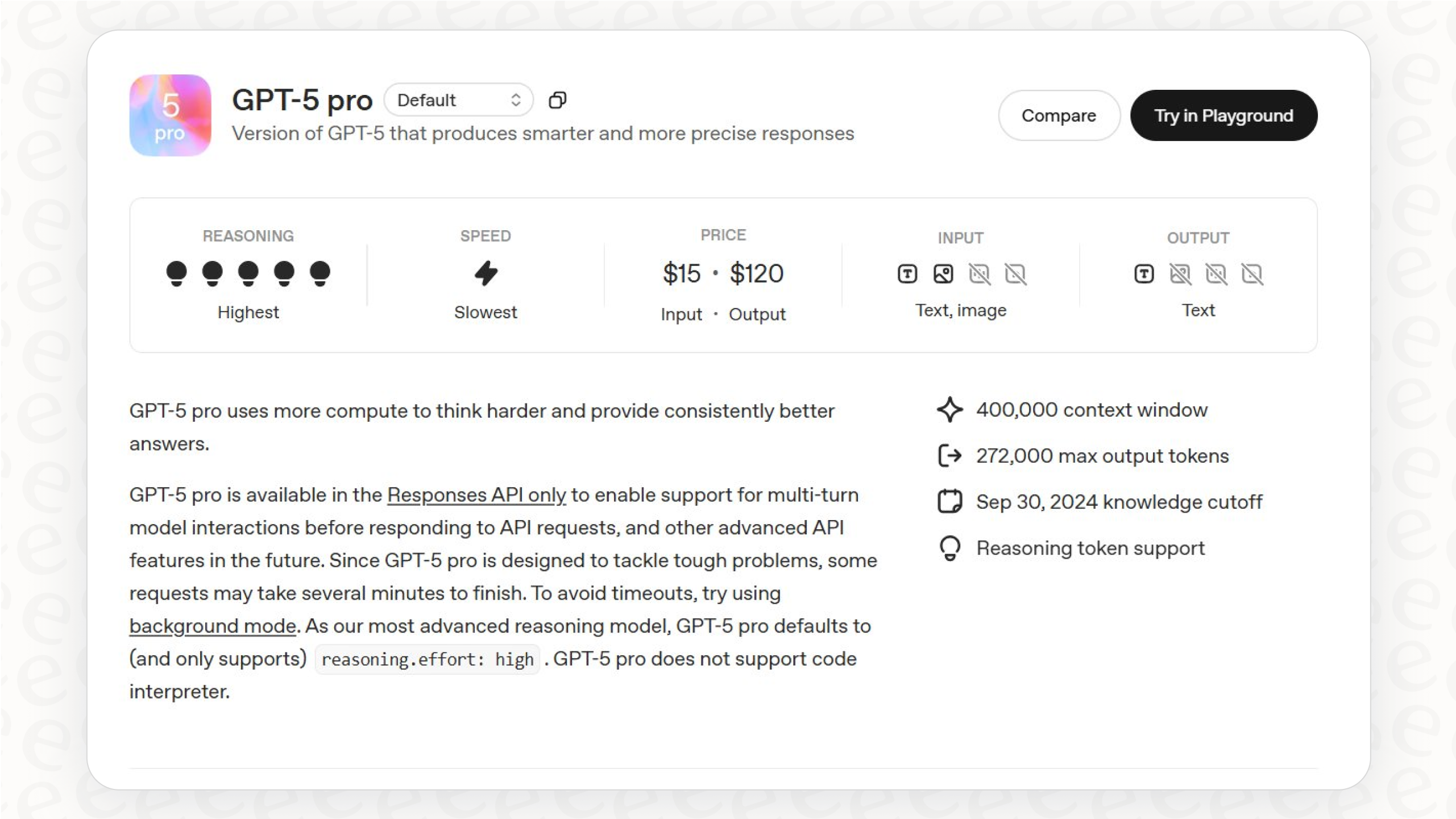

Die API-Preise verstehen

Die Preisgestaltung von OpenAI basiert hauptsächlich auf einem Pay-as-you-go-Modell, das auf „Tokens“ (grob gesagt, Wortteilen) basiert. Sie zahlen für die Tokens, die Sie in Ihrem Prompt senden (Input), und die Tokens, die das Modell zurücksendet (Output). Diese Kosten können sich unbemerkt summieren, besonders wenn Sie lange Prompts senden oder viele Gespräche führen.

Hier ist ein kurzer Überblick über die Standardpreise für einige Modelle (pro 1 Million Tokens, Stand Ende 2025):

| Modell | Input (pro 1 Mio. Tokens) | Output (pro 1 Mio. Tokens) |

|---|---|---|

| gpt-4o | 2,50 $ | 10,00 $ |

| gpt-4o-mini | 0,15 $ | 0,60 $ |

| gpt-4.1 | 2,00 $ | 8,00 $ |

| gpt-5-mini | 0,25 $ | 2,00 $ |

Quelle: OpenAI Pricing. Die Preise gelten für die Standardstufe und können sich ändern.

Und es sind nicht nur die Modelle. Andere Funktionen haben auch Kosten:

-

Tools: Die Verwendung integrierter Tools wie Code Interpreter oder File Search verursacht zusätzliche Gebühren pro Sitzung oder basierend auf dem Speicherplatz.

-

Fine-Tuning: Wenn Sie ein benutzerdefiniertes Modell trainieren, zahlen Sie für den Trainingsprozess und für die Nutzung des Modells.

Diese Pro-Token-Preisgestaltung kann Ihre monatliche Rechnung unvorhersehbar machen, was für die Budgetierung nicht ideal ist. Im Gegensatz dazu bieten Dienste wie eesel AI klare, vorhersagbare Preise, die auf einer festen Anzahl von KI-Interaktionen basieren. Sie wissen genau, wofür Sie bezahlen, was die Kostenprognose erheblich erleichtert.

Der technische Aufwand für die Entwicklung einer Komplettlösung

Ein API-Aufruf ist nur ein winziger Teil einer echten Anwendung. Ein wirklich hilfreicher KI-Support-Agent benötigt eine ganze Menge an Infrastruktur dahinter, die Sie alle selbst erstellen und warten müssen.

-

Wissensmanagement (RAG): Damit eine KI Fragen genau beantworten kann, benötigt sie Kontext aus den Dokumenten Ihres Unternehmens. Sie müssen ein Retrieval-Augmented Generation (RAG)-System aufbauen. Dies beinhaltet das Aufteilen Ihrer Dokumente, das Erstellen von Embeddings, das Einrichten einer Vektordatenbank und das Entwickeln einer Methode, um die richtigen Informationen abzurufen.

-

Integrationen: Ihre KI muss mit Ihrem Helpdesk (Zendesk, [Intercom]), Ihren internen Wissensdatenbanken (Confluence, Google Docs) und anderen Geschäftstools (Shopify, Jira) kommunizieren. Jede dieser Verbindungen ist ein eigenes kleines Projekt.

-

Testen und Validierung: Woher wissen Sie, ob Ihre KI tatsächlich hilft oder die Dinge verschlimmert? Sie müssen ein Test-Framework erstellen, um sie gegen Ihre vergangenen Support-Tickets laufen zu lassen, um zu sehen, wie gut sie funktioniert.

-

Wartung und Verbesserung: Modelle werden aktualisiert, Ihre internen Dokumente ändern sich und Ihre Geschäftsanforderungen entwickeln sich weiter. Eine benutzerdefinierte Lösung erfordert ständige Pflege und Wartung, um effektiv zu bleiben.

Beschreibung Erstellen Sie eine Infografik mit einem zentralen Kreis mit der Aufschrift "Produktionsreife KI-App". Vier Pfeile zeigen vom Kreis weg zu vier anderen Kästen:

-

Wissensmanagement (RAG): Fügen Sie Symbole für das Aufteilen von Dokumenten, Embedding und eine Vektordatenbank hinzu.

-

Integrationen: Fügen Sie Logos beliebter Tools wie Zendesk, Shopify, Confluence und Jira hinzu.

-

Testen & Validierung: Fügen Sie Symbole hinzu, die A/B-Tests, Leistungskennzahlen und Datenanalyse darstellen.

-

Wartung & Verbesserung: Fügen Sie Symbole für Modell-Updates, Datenaktualisierungszyklen und kontinuierliche Überwachung hinzu.

Die Infografik sollte visuell darstellen, dass ein einfacher API-Aufruf nur die Spitze des Eisbergs ist.

Das sind genau die Kopfschmerzen, für deren Lösung Plattformen wie eesel AI entwickelt wurden. eesel verbindet sich mit all Ihren Wissensquellen durch Ein-Klick-Integrationen, kümmert sich um die gesamte RAG-Pipeline für Sie und verfügt sogar über einen leistungsstarken Simulationsmodus, um Ihren KI-Agenten an Tausenden von echten Tickets zu testen, bevor auch nur ein einziger Kunde mit ihm spricht.

Ein einfacherer Weg zu produktionsreifer KI

OpenAI-SDKs sind fantastische Entwickler-Tools. Sie sind die wesentlichen Bausteine für jeden, der tiefgreifende, benutzerdefinierte KI-Arbeit leistet.

Aber für spezifische Geschäftsprobleme wie die Automatisierung des Kundensupports, die Optimierung von IT-Helpdesks oder die Einrichtung eines internen Q&A-Bots ist der Aufbau von Grund auf oft ein langsamer, teurer und riskanter Weg. Die Frage ist nicht nur, was technisch möglich ist, sondern wie schnell Sie einen Mehrwert erzielen können, wie zuverlässig das Endprodukt sein wird und was die Gesamtkosten im Laufe der Zeit sein werden.

Warum Monate damit verbringen, das Rad neu zu erfinden, wenn eine dedizierte Plattform Ihnen in einem Bruchteil der Zeit eine leistungsfähigere, integrierte und praxiserprobte Lösung bieten kann? Indem Plattformen wie eesel AI die komplizierten Teile wie Datenpipelines, Integrationen und Agentenlogik übernehmen, kann sich Ihr Team auf das konzentrieren, was wirklich zählt: ein großartiges Erlebnis für Ihre Kunden und Mitarbeiter zu schaffen.

Wenn Ihr Ziel darin besteht, heute ein Support-Problem zu lösen und nicht, ein langfristiges F&E-Projekt zu starten, dann ist ein plattformbasierter Ansatz wahrscheinlich die richtige Wahl.

Gehen Sie mit Ihrem KI-Agenten in wenigen Minuten live

Bereit zu sehen, was ein produktionsreifer KI-Support-Agent für Sie tun kann? Mit eesel AI können Sie Ihren Helpdesk und Ihre Wissensdatenbanken mit einem Klick verbinden, die Leistung anhand Ihrer realen Daten simulieren und einen vollständig angepassten KI-Agenten, Copilot oder Chatbot einführen. Alles, ohne eine einzige Zeile Code zu schreiben.

Starten Sie noch heute Ihre kostenlose Testversion und überzeugen Sie sich selbst.

Häufig gestellte Fragen

OpenAI-SDKs sind offizielle Bibliotheken für verschiedene Programmiersprachen, die als Wrapper um die OpenAI-API fungieren. Sie kümmern sich um grundlegende Details wie HTTP-Anfragen, Authentifizierung und das Parsen von Antworten, sodass Entwickler API-Aufrufe mit einfachen, sprachspezifischen Funktionsaufrufen durchführen können.

OpenAI bietet offizielle SDKs für mehrere beliebte Programmiersprachen an, darunter Python, TypeScript/JavaScript (Node.js), .NET (C#), Java und Go. Diese SDKs decken eine breite Palette von Entwicklungsumgebungen für die Erstellung verschiedener Arten von Anwendungen ab.

Die OpenAI-SDKs ermöglichen multimodale Fähigkeiten, indem sie es Ihnen erlauben, verschiedene Inhaltstypen wie Bild-URLs, hochgeladene Bilder, Audiodateien und Dokumente direkt in Ihre Prompts einzubinden. Dies ermöglicht es Modellen wie GPT-4o, über reinen Text hinaus auf vielfältige Eingaben zu analysieren und zu reagieren.

Ja, die OpenAI-SDKs unterstützen vollständig die „Tools“-Funktion (früher als Funktionsaufrufe bekannt), mit der Sie benutzerdefinierte Funktionen definieren können, deren Verwendung das Modell anfordern kann. Wenn das Modell feststellt, dass eine Funktion für die Anfrage eines Benutzers relevant ist, gibt es ein JSON-Objekt zurück, das die Funktion und ihre Parameter für die Ausführung durch Ihren Code angibt.

Zu den größten Herausforderungen gehören ein erheblicher technischer Aufwand für die Implementierung des Wissensmanagements (RAG), die Erstellung und Wartung benutzerdefinierter Integrationen und die Entwicklung robuster Test-Frameworks. Diese Aspekte erfordern neben den API-Kosten einen beträchtlichen Entwicklungsaufwand und laufende Wartung für eine produktionsreife Lösung.

Das spezialisierte Agents SDK ist für die Erstellung anspruchsvoller agentischer Anwendungen konzipiert und bietet Funktionen wie Agenten-Übergaben (Handoffs), Schutzmechanismen (Guardrails) für kontrolliertes Verhalten und automatische Sitzungsverwaltung für den Gesprächsverlauf. Es erleichtert einen strukturierten Ansatz für mehrstufige Problemlösungen und die Koordination mehrerer KI-Agenten und vereinfacht komplexe Agentenlogik.

Obwohl OpenAI-SDKs hervorragend für benutzerdefinierte und tiefgreifende KI-Entwicklungen geeignet sind, bieten dedizierte Plattformen wie eesel AI oft einen schnelleren und effizienteren Weg zur Produktionsreife für spezifische Geschäftslösungen. Diese Plattformen abstrahieren komplexe Infrastruktur, Datenpipelines und Integrationen, was den technischen Aufwand erheblich reduziert und die Bereitstellung beschleunigt.

Diesen Beitrag teilen

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.