Wir alle wissen, dass große Sprachmodelle (LLMs) große Töne spucken können. Sie können E-Mails am laufenden Band produzieren, Quizfragen beantworten und auf Befehl sogar ein Sonett verfassen. Aber was ist mit dem tatsächlichen Tun von Dingen? Wie bringen wir sie dazu, nicht nur zu reden, sondern auch mit der realen Welt zu interagieren, wie zum Beispiel eine Bestellung nachzuschlagen, ein Support-Ticket zu aktualisieren oder eine Datenbank abzufragen?

Das ist die Aufgabe von OpenAI Function Calling (das sie jetzt offiziell in „Tools“ umbenannt haben). Es ist das Puzzleteil, das die Konversationsfähigkeiten einer KI mit realen Aktionen verbindet. Es ist das, was einen einfachen Frage-Antwort-Bot in einen Agenten verwandelt, der tatsächlich mit Ihrer Unternehmenssoftware arbeiten kann.

In diesem Leitfaden werden wir erläutern, was Function Calling ist, wie es funktioniert und auf einige der versteckten Komplexitäten eingehen, auf die Sie stoßen werden, wenn Sie versuchen, damit von Grund auf zu entwickeln. Noch wichtiger ist, dass wir uns ansehen, wie moderne Plattformen die Schwerstarbeit übernehmen können, sodass Sie leistungsstarke KI-Agenten erstellen können, ohne ein dediziertes Ingenieurteam in Bereitschaft halten zu müssen.

Was ist OpenAI Function Calling?

Einfach ausgedrückt ist OpenAI Function Calling eine Funktion, mit der Sie einem LLM mitteilen können, welche Werkzeuge Ihnen zur Verfügung stehen. Sie beschreiben dem Modell Ihre Funktionen, und es kann dann die Anfrage eines Benutzers analysieren und darum bitten, eine davon zu verwenden. Dies geschieht, indem es ein sauberes JSON-Objekt ausgibt, das alle Details enthält, die Ihre App zum Ausführen der Funktion benötigt.

Ein häufiges Missverständnis ist die Annahme, das Modell führe den Code selbst aus. Das tut es nicht. Es teilt Ihrer Anwendung nur mit, welchen Code sie ausführen und welche Informationen sie verwenden soll.

Stellen Sie sich das LLM als einen wirklich klugen Assistenten vor, der Ihren gesamten Werkzeugkasten in- und auswendig kennt. Wenn eine Aufgabe anfällt, kann er die Werkzeuge nicht selbst benutzen, aber er kann Ihnen das richtige reichen (den Funktionsnamen) und Ihnen genau sagen, wie Sie es verwenden sollen (die Argumente). Ihre Anwendung ist diejenige, die sich tatsächlich die Hände schmutzig macht und die Arbeit erledigt.

Obwohl OpenAI diese Funktion kürzlich „Tools“ nannte, um besser zu erfassen, was sie kann, verwenden die meisten Leute immer noch den Begriff „Function Calling“, um das Konzept zu beschreiben.

Wie funktioniert der OpenAI Function Calling-Ablauf?

Eine KI dazu zu bringen, ein Werkzeug zu verwenden, ist kein einzelner API-Aufruf; es ist eher ein Hin- und Her-Gespräch zwischen Ihrer App und dem Modell. Es ist ein kleiner Tanz, der einem ziemlich vorhersehbaren Muster folgt.

Hier ist ein Schritt-für-Schritt-Blick darauf, wie es abläuft:

-

Sie zeigen dem Modell Ihre Werkzeuge. Zuerst geben Sie dem Modell eine Liste der Funktionen, die es verwenden kann. Dazu gehören der Name der Funktion, eine klare Beschreibung ihrer Aufgabe und die spezifischen Parameter, die sie benötigt (alles in einem Format namens JSON-Schema dargelegt). Die Qualität Ihrer Beschreibung ist entscheidend, denn so erkennt das Modell, wann es ein Werkzeug vorschlagen soll.

-

Der Benutzer bittet um etwas. Ein Benutzer gibt eine Anfrage in einfacher Sprache ein, wie zum Beispiel: „Wie ist der Status meiner Bestellung #12345?“

-

Das Modell wählt ein Werkzeug aus. Das Modell liest die Anfrage. Wenn es eine Übereinstimmung mit einer Ihrer Funktionsbeschreibungen findet, antwortet es mit einer speziellen Nachricht, in der es Ihre Anwendung auffordert, diese Funktion aufzurufen. Es liefert auch die Argumente, die es aus der Eingabeaufforderung des Benutzers extrahiert hat (zum Beispiel:

{"function": "get_order_status", "arguments": {"order_id": "12345"}}). -

Ihre App erledigt die Arbeit. Ihr Code nimmt diese strukturierte Antwort entgegen und führt die eigentliche Funktion „get_order_status“ aus. Er könnte sich mit Ihrer Datenbank oder einer externen API verbinden, um die Information zu erhalten, die in diesem Fall „Versandt“ lautet.

-

Sie geben das Ergebnis an das Modell zurück. Schließlich tätigen Sie einen letzten API-Aufruf an das Modell, diesmal unter Einbeziehung des Funktionsergebnisses im Chatverlauf. Nun hat das Modell das letzte Puzzleteil und kann dem Benutzer eine freundliche, natürliche Antwort geben, wie zum Beispiel: „Ihre Bestellung #12345 wurde versandt.“

Dieser kleine Kreislauf ermöglicht es der KI, ihre Konversationsfähigkeiten mit Echtzeitdaten und -aktionen zu verbinden, was sie um einiges nützlicher macht.

Häufige Anwendungsfälle für OpenAI Function Calling

Function Calling macht aus einem Chatbot, der eine einfache Spielerei ist, einen leistungsstarken Agenten, der echte Geschäftsprozesse bewältigen kann. Hier sind einige der häufigsten Arten, wie Menschen es einsetzen.

Anbindung an Ihre Live-Daten

Dies ist der einfachste Anwendungsfall. Er ermöglicht einer KI den Zugriff auf Echtzeit-, private oder dynamische Informationen, die nicht in ihren ursprünglichen Trainingsdaten enthalten waren. Eine KI kann fast augenblicklich zu einem Experten für Ihre spezifischen Geschäftsabläufe werden.

Zum Beispiel könnte eine KI für den Kundensupport den Status einer Bestellung in einer Shopify-Datenbank nachschlagen, die Flugverfügbarkeit über die API einer Fluggesellschaft prüfen oder Kontodetails aus Ihrem internen CRM abrufen.

Aufgaben in anderen Apps erledigen

Über das reine Abrufen von Informationen hinaus ermöglicht Function Calling einer KI, Arbeitsabläufe auszulösen und Änderungen in anderen Systemen vorzunehmen. Sie kann zu einem aktiven Teil Ihrer Geschäftsprozesse werden.

Zum Beispiel könnte ein IT-Support-Bot eine Anfrage erhalten und automatisch ein neues Ticket in Jira Service Management erstellen. Oder ein Vertriebsassistent könnte Details aus einem Gespräch übernehmen und einen neuen Lead in Ihr CRM eintragen, ohne dass jemand manuelle Dateneingaben vornehmen muss.

Unstrukturierte Texte in saubere Daten umwandeln

Manchmal geht es nicht darum, eine Frage zu beantworten, sondern darum, Informationen zuverlässig zu extrahieren und zu formatieren. Function Calling eignet sich hierfür hervorragend, da Sie die Parameter einer Funktion als Vorlage definieren können, in die die Daten passen sollen.

Ein perfektes Beispiel ist die Verarbeitung einer eingehenden Support-E-Mail. Die KI kann einen langen Textblock lesen, den Namen des Benutzers, das Unternehmen, den Problemtyp und die Dringlichkeitsstufe extrahieren und alles in ein perfektes JSON-Objekt formatieren. Dieses Objekt kann dann verwendet werden, um ein neues, perfekt kategorisiertes Ticket in Ihrem Helpdesk zu erstellen.

Die versteckten Herausforderungen beim Entwickeln mit OpenAI Function Calling

Der Sprung von einer coolen Demo zu einer produktionsreifen Anwendung, die Function Calling verwendet, ist ziemlich groß. Das direkte Entwickeln mit der API ist leistungsstark, bringt aber einige ernsthafte technische Kopfschmerzen mit sich, die viele Teams nicht vorhersehen.

Herausforderungen bei der Orchestrierung

Was passiert, wenn eine Aufgabe mehrere Schritte erfordert? Um die Bestellung eines Kunden zu finden, müssen Sie vielleicht zuerst seine Kunden-ID über seine E-Mail-Adresse finden und dann diese ID verwenden, um seine Bestellungen nachzuschlagen. Das Modell handhabt diese Art von mehrstufiger Logik nicht von allein. Sie müssen in Ihrem eigenen Code eine „Zustandsmaschine“ erstellen und warten, um die Abfolge zu verwalten.

Zuverlässigkeit und Fehlerbehandlung

Modelle verhalten sich nicht immer so, wie man es erwartet. Sie können manchmal Argumente „halluzinieren“, die nicht existieren, die falsche Funktion aufrufen oder einfach keine aufrufen, obwohl es offensichtlich notwendig wäre. Das bedeutet, dass Ihr Team eine Menge Validierungs-, Fehlerprüfungs- und Wiederholungslogik schreiben muss, um das System zuverlässig zu machen.

Manche Entwickler greifen sogar darauf zurück, das Modell in ihren Systemnachrichten praktisch anzuschreien, indem sie Dinge wie „WERTE FÜR PARAMETER NICHT ANNEHMEN“ in Großbuchstaben schreiben, nur um es zum richtigen Verhalten zu bewegen. Das ist kaum eine skalierbare Methode, um ein Produktionssystem zu bauen.

Verketten von Funktionen: Eine bekannte Schwachstelle

Selbst mit den besten Prompts haben Modelle oft Schwierigkeiten, eine Aufgabe zu planen und auszuführen, die mehrere verschiedene Funktionsaufrufe in einer bestimmten Reihenfolge erfordert. Sie sind ziemlich gut darin, das nächstbeste Werkzeug für einen einzelnen Schritt auszuwählen, können sich aber in einem komplexeren Arbeitsablauf verlieren. Auch hier bedeutet das, dass Sie benutzerdefinierten, oft komplizierten Code schreiben müssen, um den Fluss zu steuern und das Modell von einem Schritt zum nächsten zu leiten.

Entwicklung und Wartung können eine echte Belastung sein

Das Definieren von Funktionsschemata in JSON ist eine mühsame Arbeit, und es ist leicht, einen Syntaxfehler zu machen. Jedes Mal, wenn Sie ein neues Werkzeug hinzufügen oder ein altes aktualisieren möchten, müssen Sie wieder in den Code eintauchen. Diesen Code mit Ihren tatsächlichen Werkzeugen synchron zu halten, verschiedene Versionen zu verwalten und einfach nur mit den häufigen Änderungen an der OpenAI-API Schritt zu halten, wird zu einer ständigen Belastung für die Entwicklungszeit.

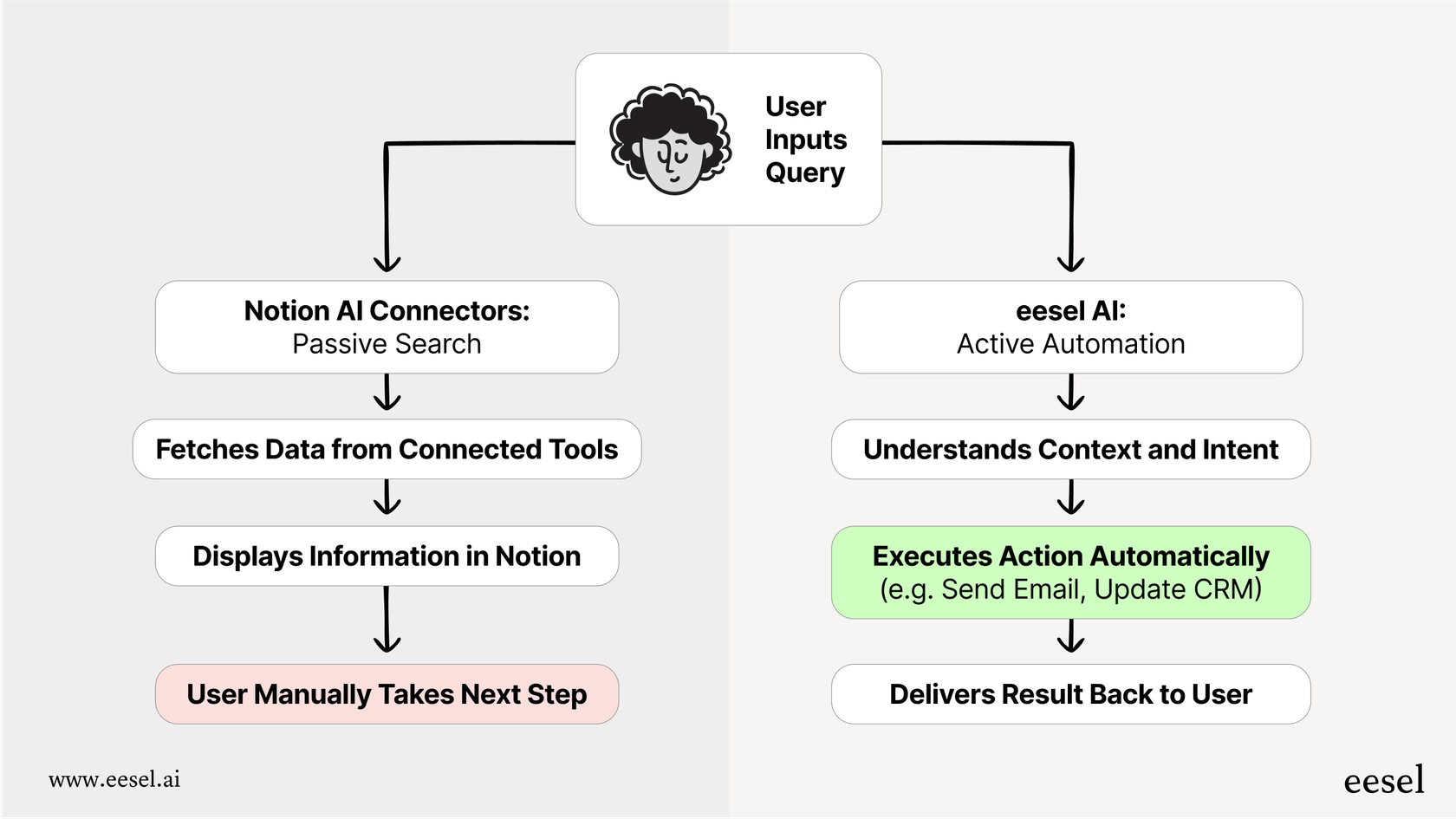

Ein einfacherer Weg, KI-Agenten zu erstellen

Der Do-it-yourself-Ansatz für Function Calling ist leistungsstark, aber für die meisten Support- und IT-Teams, die zuverlässige Lösungen ohne eine dedizierte Engineering-Crew benötigen, nicht praktikabel. Hier können Plattformen wie eesel AI einen großen Unterschied machen. eesel AI übernimmt die gesamte unübersichtliche Arbeit hinter den Kulissen des Function Calling über eine intuitive Benutzeroberfläche und verwandelt eine schwierige Programmieraufgabe in einen einfachen Arbeitsablauf.

Von komplexem Code zu einer No-Code-Workflow-Engine

Anstatt Python-Skripte und Zustandsmaschinen zu schreiben, um Funktionsaufrufe zu verwalten, bietet Ihnen eesel AI einen visuellen Workflow-Builder. Sie können Regeln, Eskalationspfade und Aktionssequenzen einrichten, ohne eine einzige Zeile Code zu schreiben. Dies gibt Ihnen die vollständige Kontrolle über das Verhalten Ihrer KI und ermöglicht es Ihnen, anspruchsvolle Arbeitsabläufe zu entwerfen, die jedes Mal zuverlässig ausgeführt werden. Sie entscheiden genau, welche Tickets die KI bearbeiten und was sie Schritt für Schritt tun soll.

Vorgefertigte Aktionen und einfache benutzerdefinierte Anbindungen

eesel AI wird mit einer Bibliothek von einsatzbereiten Aktionen für beliebte Helpdesks wie Zendesk und Freshdesk geliefert. Häufige Aufgaben wie „Ticket taggen“, „interne Notiz hinzufügen“ oder „Ticket schließen“ sind nur einen Klick entfernt.

Müssen Sie eine Verbindung zu einem benutzerdefinierten Tool oder einer internen API herstellen? eesel AI macht auch das einfach. Sie können problemlos benutzerdefinierte Aktionen einrichten, um Informationen nachzuschlagen oder Arbeitsabläufe in jedem externen System auszulösen, wobei die gesamte mühsame Erstellung von JSON-Schemata für Sie erledigt wird. So können Teams in Minuten statt Monaten live gehen.

Testen Sie Ihre Implementierung vor dem Start mit Zuversicht

Eine der größten Sorgen beim DIY-Ansatz ist die Unsicherheit. Wird der Agent bei echten Kundenproblemen tatsächlich wie erwartet funktionieren? eesel AI löst dieses Problem mit seinem Simulationsmodus. Anstatt Code bereitzustellen und die Daumen zu drücken, können Sie Ihren KI-Agenten an Tausenden Ihrer vergangenen Tickets in einer sicheren Umgebung ausführen. Sie können genau sehen, wie er reagiert hätte, welche Aktionen er ergriffen hätte und wie hoch Ihre Automatisierungsrate wäre. So können Sie alles feinabstimmen und mit Zuversicht testen, bevor er jemals mit einem echten Kunden interagiert.

Gehen Sie über Gespräche hinaus und fangen Sie an zu handeln

OpenAI Function Calling ist der Motor, der es KI ermöglicht, echte Arbeit zu leisten, aber die rohe API ist wirklich nur ein Kasten mit Einzelteilen. Einen zuverlässigen, produktionsreifen KI-Agenten von Grund auf zu bauen, bietet Ihnen ultimative Flexibilität, ist aber mit hohen Kosten in Bezug auf Komplexität, Unzuverlässigkeit und laufende Wartung verbunden.

Plattformen wie eesel AI bieten die ganze Leistungsfähigkeit von Function Calling ohne den technischen Aufwand. Sie geben Teams die Möglichkeit, fähige, benutzerdefinierte KI-Agenten bereitzustellen, die eng mit ihren Geschäftswerkzeugen integriert sind und endlich die Lücke zwischen bloßem Reden und tatsächlichem Handeln schließen.

Bereit, einen KI-Agenten zu bauen, der echte Maßnahmen ergreift?

Wenn Sie bereit sind, einen KI-Agenten zu erstellen, der sich mit Ihren Werkzeugen verbindet und Ihren Support automatisiert, melden Sie sich kostenlos bei eesel AI an und starten Sie Ihren ersten KI-Agenten in wenigen Minuten. Kein Programmieren erforderlich.

Häufig gestellte Fragen

OpenAI Function Calling (jetzt oft „Tools“ genannt) ist eine Funktion, mit der Sie einem LLM Ihre verfügbaren Funktionen beschreiben können. Es löst das Problem, die Konversationsfähigkeiten einer KI mit realen Aktionen zu verbinden, und ermöglicht es ihr, Ihre Anwendung aufzufordern, Aufgaben wie das Nachschlagen von Daten oder das Aktualisieren von Systemen durchzuführen.

Nein, das LLM führt Ihren Code nicht aus. Es analysiert lediglich die Anfrage eines Benutzers und antwortet gegebenenfalls mit einem strukturierten JSON-Objekt, das angibt, welche Funktion Ihre Anwendung ausführen und welche Argumente sie verwenden soll. Ihre Anwendung führt dann diese Funktion aus.

Der Prozess beginnt damit, dass Ihre App dem Modell ihre Werkzeuge beschreibt. Wenn ein Benutzer eine Anfrage stellt, schlägt das Modell eine Funktion und deren Argumente vor. Ihre Anwendung führt dann diese Funktion aus, und schließlich geben Sie das Ergebnis an das Modell zurück, damit es eine natürlichsprachige Antwort für den Benutzer formulieren kann.

Unternehmen verwenden es häufig, um KIs mit Live-Daten zu verbinden, wie z. B. das Nachschlagen von Bestellstatus in einer Datenbank oder von Kontodetails in einem CRM. Es wird auch verwendet, um Aktionen in anderen Apps auszulösen, wie das Erstellen eines Jira-Tickets, oder um spezifische Daten aus unstrukturiertem Text zu extrahieren und zu formatieren.

Zu den größten Herausforderungen gehören die Orchestrierung mehrstufiger Arbeitsabläufe, die Gewährleistung der Zuverlässigkeit durch eine robuste Fehlerbehandlung und die Schwierigkeit des Modells, mehrere Funktionen miteinander zu verketten. Außerdem gibt es einen erheblichen Entwicklungs- und Wartungsaufwand durch die manuelle Definition von JSON-Schemata und API-Änderungen.

Plattformen wie eesel AI bieten visuelle Workflow-Builder und vorgefertigte Aktionen, die die komplexe Programmierung, Orchestrierung und Fehlerbehandlung abstrahieren. Sie vereinfachen die Definition von benutzerdefinierten Werkzeugen und bieten Simulationsmodi, um Agenten vor der Bereitstellung zuverlässig zu testen.

Diesen Beitrag teilen

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.