Sie möchten also Ihre eigenen Dokumente in die Modelle von OpenAI einbinden. Das ist ein ziemlich häufiges Ziel: Sie möchten einen Kundensupport-Bot erstellen, der Ihre Hilfedokumente wirklich kennt, oder ein Modell mit den privaten Daten Ihres Unternehmens feinabstimmen. Die OpenAI Files API ist Ihre Eintrittskarte, um das zu ermöglichen.

Aber es gibt einen Haken: Die direkte Arbeit mit der API kann sich so anfühlen, als würden Sie unzählige Rohre verlegen, nur um das Wasser zum Laufen zu bringen. Es ist ein code-intensiver Prozess mit vielen Schritten, langen Wartezeiten für die Verarbeitung und einer kniffligen Dateiverwaltung.

Dieser Leitfaden führt Sie durch den gesamten Prozess, von den grundlegenden API-Aufrufen bis zu den häufigsten Problemen, auf die Entwickler stoßen. Wir werden behandeln, wie Sie Dateien auf dem Do-it-yourself-Weg hochladen, verwalten und verwenden, und dann einen viel einfacheren Weg für Unternehmen aufzeigen, die einfach nur Ergebnisse sehen wollen.

Was ist die OpenAI Files API?

Die OpenAI Files API ist eine Sammlung von Werkzeugen, mit denen Sie Dateien auf den Servern von OpenAI hochladen, verwalten und löschen können. Stellen Sie es sich wie ein Cloud-Laufwerk vor, das speziell für die Dokumente gedacht ist, die Ihre KI-Anwendungen verwenden sollen.

Wenn Sie eine Datei hochladen, müssen Sie ihr einen „Zweck“ (purpose) zuweisen, was einfach eine Möglichkeit ist, OpenAI mitzuteilen, wie Sie sie verwenden möchten. Die Hauptzwecke, die Sie sehen werden, sind:

-

„assistants“: Dieser Zweck dient dazu, Dokumente für die Assistants API bereitzustellen. Er wird oft mit dem „file_search“-Tool (früher als Retrieval bezeichnet) verwendet, wodurch ein Assistent Informationen in Ihren Dateien nachschlagen kann, um Fragen zu beantworten.

-

„fine-tune“: Diesen Zweck verwenden Sie, wenn Sie Trainingsdaten für die Erstellung eines benutzerdefinierten, feinabgestimmten Modells bereitstellen.

-

„vision“: Wie Sie vielleicht schon vermuten, dient dieser Zweck dem Hochladen von Bildern zur Analyse durch Modelle wie GPT-4o.

-

„batch“: Dieser Zweck ist für die Eingabe von Dateien in die Batch API gedacht, was praktisch ist, um große Aufträge auszuführen, ohne in Echtzeit darauf warten zu müssen.

Im Grunde ist die Files API der erste Schritt zur Entwicklung einer KI, die mehr weiß als nur das, was sie aus dem öffentlichen Internet gelernt hat.

Wie man die OpenAI Files API verwendet (der entwicklerintensive Weg)

Der direkte Weg über die API gibt Ihnen die volle Kontrolle, bedeutet aber auch, dass Sie für das Schreiben des Codes zur Verwaltung aller Abläufe verantwortlich sind. Schauen wir uns an, wie das für einige häufige Szenarien aussieht.

Dateien programmatisch hochladen und verwalten

Der Kern der API beschränkt sich auf einige wenige Hauptbefehle. Bevor Sie beginnen, benötigen Sie das OpenAI SDK für die Sprache Ihrer Wahl. Für Python ist das nur ein schnelles „pip install openai“.

Also, machen wir uns die Hände mit etwas Code schmutzig. So sieht der grundlegende Arbeitsablauf aus:

- Eine Datei hochladen: Zuerst öffnen Sie eine Datei von Ihrem Computer und laden sie hoch, wobei Sie OpenAI mitteilen, welchen Zweck sie hat.

from openai import OpenAI

client = OpenAI()

# Upload a file with an "assistants" purpose

file = client.files.create(

file=open("my-knowledge-base.pdf", "rb"),

purpose="assistants"

)

print(file.id)

- Dateien auflisten: Möchten Sie alles sehen, was Sie hochgeladen haben? Sie können eine Liste aller Dateien in Ihrer Organisation abrufen.

all_files = client.files.list()

print(all_files)

- Eine Datei überprüfen: Nachdem Sie eine Datei hochgeladen haben, können Sie ihre Metadaten überprüfen, um ihren Status zu sehen, der „uploaded“, „processed“ oder „error“ sein wird.

file_info = client.files.retrieve("YOUR_FILE_ID")

print(file_info.status)

- Eine Datei löschen: Wenn Sie eine Datei nicht mehr benötigen, können Sie sie entfernen, um Ihren Speicher aufzuräumen.

client.files.delete("YOUR_FILE_ID")

Diese Schritte sehen für ein oder zwei Dateien einfach genug aus. Aber was ist, wenn Sie Hunderte oder Tausende haben? Die API bietet keine Massenoperationen, also müssten Sie Ihre eigenen Skripte erstellen, um jede einzelne Datei in einer Schleife zu verarbeiten. An diesem Punkt fühlt sich der entwicklergeführte Ansatz wie eine echte Plackerei an.

Die API mit Assistenten und Dateisuche verwenden

Schnallen Sie sich an, denn der nächste Teil ist ein mehrstufiger Tanz. Wenn Sie möchten, dass ein Assistent eine Ihrer hochgeladenen Dateien tatsächlich zur Beantwortung von Fragen verwendet, müssen Sie mit sogenannten Vector Stores (Vektorspeichern) arbeiten. Ein Vektorspeicher ist im Grunde eine verarbeitete und indizierte Sammlung Ihrer Dateien, die für eine schnelle Suche optimiert ist.

Hier ist der typische Arbeitsablauf, den Sie von Grund auf neu erstellen müssten:

-

Laden Sie Ihre Datei(en) mit der Files API hoch.

-

Erstellen Sie einen Vektorspeicher.

-

Fügen Sie Ihre hochgeladene(n) Datei(en) zu diesem neuen Vektorspeicher hinzu.

-

Warten. Und den Status der Datei immer wieder überprüfen (oder „pollen“), bis sie vollständig verarbeitet ist.

-

Erstellen Sie einen Assistenten und stellen Sie sicher, dass Sie das „file_search“-Tool aktivieren.

-

Verknüpfen Sie Ihren Vektorspeicher mit dem Assistenten.

-

Erstellen Sie einen Thread, um eine Konversation zu starten.

-

Fügen Sie die Frage des Benutzers zum Thread hinzu.

-

Erstellen Sie einen „Run“, damit der Assistent die Frage verarbeitet.

-

Pollen Sie den Status des Runs, bis er schließlich als „completed“ angezeigt wird.

-

Und schließlich können Sie die Antwort des Assistenten aus dem Thread abrufen.

Fällt Ihnen das ganze Polling auf? Nachdem Sie eine Datei zu einem Vektorspeicher hinzugefügt haben, können Sie sie nicht sofort verwenden. Ihre Anwendung muss die API immer wieder fragen: „Ist es schon fertig?“ Das fügt eine zusätzliche Komplexitätsebene hinzu und bedeutet, dass Sie eine solide Fehlerbehandlung und Zustandsverwaltung entwickeln müssen, nur damit es zuverlässig funktioniert.

Für Teams ohne dedizierte KI-Ingenieure ist der Aufbau und die Wartung dieses gesamten Systems eine ziemlich große Aufgabe. Es ist eine häufige Beschwerde in Entwickler-Communitys, wo die Leute oft überrascht sind, wie viel Arbeit es kostet, etwas zu tun, das so einfach klingt: „Fragen aus meinen Dokumenten beantworten.“

Preise und Einschränkungen der OpenAI Files API

Bevor Sie loslegen und mit dem Bauen beginnen, ist es eine gute Idee zu wissen, worauf Sie sich bei Kosten und Einschränkungen einlassen.

Wie viel kostet die Nutzung der OpenAI Files API?

Wenn Sie die Files API verwenden, zahlen Sie nicht nur für die Tokens des Modells. Ihnen wird auch der Speicherplatz in Rechnung gestellt, den Ihre Dateien belegen.

-

Speicherkosten: OpenAI berechnet die Speicherung Ihrer Dateien und deren indizierten Versionen in Vektorspeichern. Der aktuelle Preis beträgt $0.10 pro GB pro Tag, wobei das erste GB kostenlos ist.

-

Token-Kosten: Wenn ein Assistent „file_search“ verwendet, um eine Antwort zu finden, werden die relevanten Teile Ihres Dokuments in das Kontextfenster des Modells eingefügt. Das verbraucht Prompt-Tokens, die Ihnen in Rechnung gestellt werden.

Dieses zweigeteilte Preismodell kann es schwierig machen, Ihre monatliche Rechnung vorherzusagen, da sie davon abhängt, wie viele Daten Sie speichern und wie oft Ihr Assistent sie verwendet.

Häufige Herausforderungen und Einschränkungen

Die rohe API ist leistungsstark, hat aber ein paar Eigenheiten, die Sie ausbremsen können.

-

Sie können Aktionen nicht stapelweise ausführen: Die API unterstützt kein Hochladen oder Löschen mehrerer Dateien auf einmal. Sie müssen ein Skript schreiben, um sie einzeln durchzugehen, was schmerzhaft langsam sein kann.

-

Es gibt keine visuelle Benutzeroberfläche: Sie können sich nicht einfach in ein Dashboard einloggen, um alle Ihre hochgeladenen Dateien zu sehen, ihren Status zu überprüfen oder herauszufinden, welche Assistenten sie verwenden. Das macht die Verwaltung und das Debugging zu einem echten Albtraum.

-

Sie müssen warten... und prüfen... und noch mehr warten: Wie bereits erwähnt, ist die Dateiverarbeitung asynchron. Ihr Code muss ständig bei der API nachfragen, ob eine Datei bereit ist, was Ihre Logik verkompliziert und zu Verzögerungen führen kann.

-

Das Wissensmanagement wird unübersichtlich: Die Verknüpfung spezifischer Dateien mit spezifischen Assistenten erfordert das Jonglieren mit „Vector Store“-IDs und „tool_resources“-Objekten. Es gibt keine einfache Möglichkeit, einfach zu sagen: „Hey, beantworte diese Frage nur mit diesen drei Dokumenten“, ohne sorgfältige Programmierung.

Diese Einschränkungen führen oft dazu, dass ein anfangs einfach erscheinendes Projekt zu einem großen Ingenieuraufwand ausufert. Sie verbringen am Ende mehr Zeit damit, grundlegende Dateiverwaltungstools zu entwickeln, als mit Ihrer eigentlichen Anwendung.

Der einfachere Weg: Verwalten Sie Ihr Wissen mit einer integrierten Plattform

Alles selbst auf der OpenAI Files API aufzubauen, gibt Ihnen Flexibilität, ist aber ein enormer Zeitfresser. Für die meisten Unternehmen, insbesondere in den Bereichen Kundensupport oder IT, ist eine fertige Plattform, die all diese Komplexität verbirgt, eine viel bessere Lösung.

Hier kommt eine Lösung wie eesel AI ins Spiel. Sie wurde entwickelt, um das vorhandene Wissen Ihres Unternehmens mit einem KI-Agenten zu verbinden, ohne dass Sie eine einzige Zeile API-Code schreiben müssen.

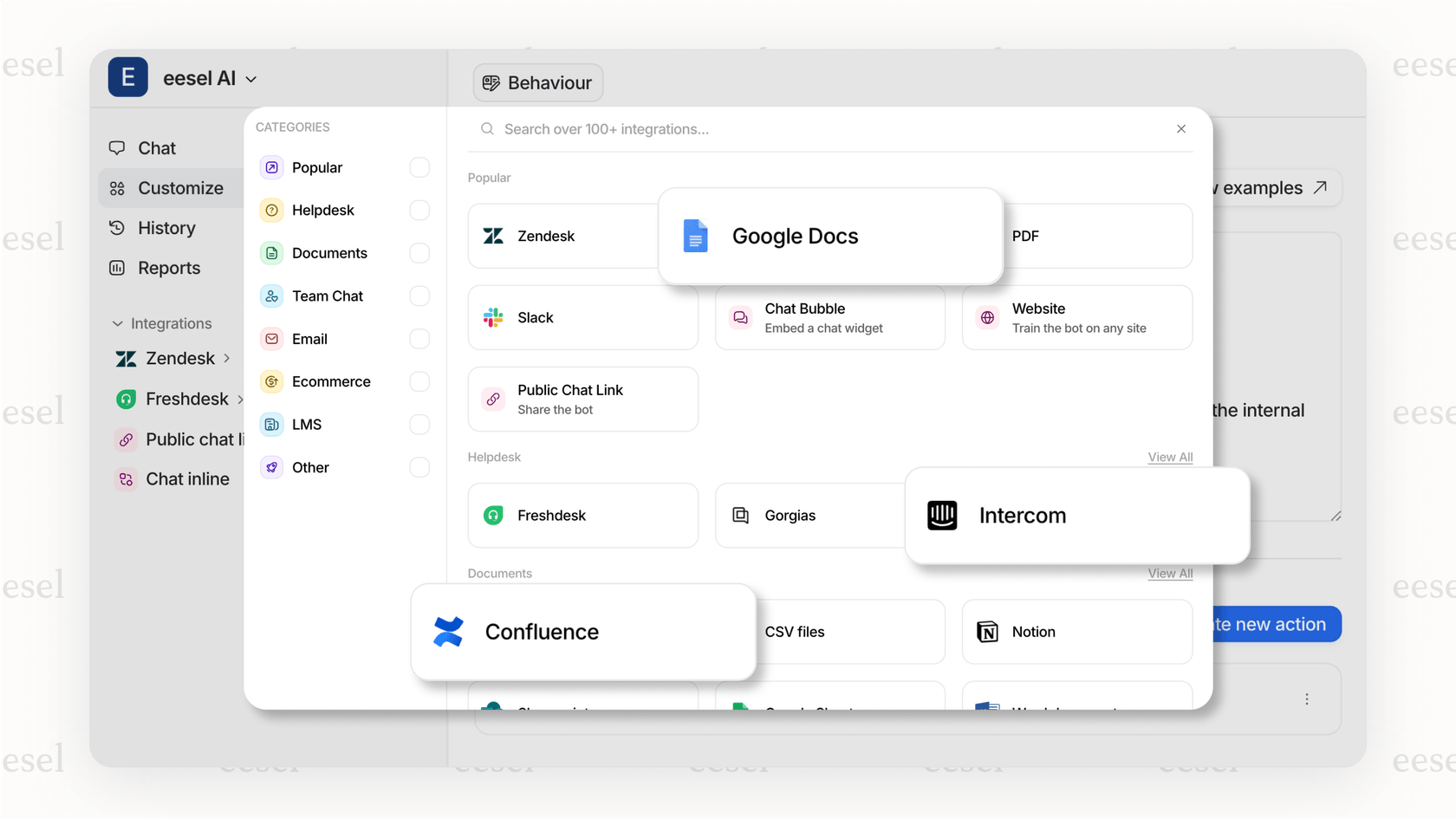

In Minuten live gehen mit Ein-Klick-Integrationen

Anstatt sich mit Skripten abzumühen, um Dateien einzeln hochzuladen, verfügt eesel AI über einfache Integrationen für die Tools, die Sie bereits verwenden. Sie können Ihren Helpdesk (wie Zendesk oder Freshdesk), Ihre Wissensdatenbank (wie Confluence oder Notion) und Ihre geteilten Dokumente (wie Google Docs) mit nur wenigen Klicks verbinden. eesel AI kümmert sich im Hintergrund um die gesamte Synchronisierung, Verarbeitung und Indizierung der Dateien.

Vereinheitlichen Sie Ihr gesamtes Wissen ohne manuelle Arbeit

Mit der OpenAI Files API müssen Sie jedes einzelne Dokument hochladen und organisieren. Mit eesel AI ist Ihr Wissen von Anfang an vereinheitlicht. Es kann sogar aus den vergangenen Support-Tickets Ihres Teams lernen, um Ihre Markenstimme und häufige Kundenprobleme zu übernehmen. Das bedeutet, dass Ihr KI-Agent vom ersten Tag an auf Ihren spezifischen Geschäftskontext trainiert wird, ohne dass Sie Tausende von Dateien manuell vorbereiten und hochladen müssen.

Testen Sie mit Zuversicht vor dem Start

Einer der beängstigendsten Aspekte beim Bauen auf der rohen API ist die Ungewissheit, wie Ihre KI bei echten Fragen tatsächlich abschneiden wird. Der Simulationsmodus von eesel AI kümmert sich darum, indem er Ihren KI-Agenten an Tausenden Ihrer historischen Support-Tickets testet. Sie können sehen, wie er reagiert hätte, und erhalten solide Prognosen darüber, wie viele Tickets er lösen kann und wie viel Geld Sie sparen werden. Sie können sogar damit beginnen, nur eine Kategorie von Tickets zu automatisieren und von dort aus zu erweitern, sodass Sie die volle Kontrolle behalten.

Abschließende Gedanken

Die OpenAI Files API ist ein grundlegender Baustein für die Schaffung einer KI, die Ihre einzigartigen Daten versteht. Für Entwickler, die etwas komplett Eigenes bauen müssen, bietet sie alle Macht und Kontrolle, die man sich wünschen kann.

Aber für die meisten Unternehmen ist das Ziel nicht, Experten für API-Orchestrierung zu werden. Es geht darum, ein Problem zu lösen, wie zum Beispiel Ihr Support-Team von sich wiederholenden Fragen zu entlasten. Die Komplexität der Dateiverwaltung, das ständige Abfragen von Status und das Fehlen einer Benutzeroberfläche machen die direkte API zu einem schwierigen Weg dafür.

Plattformen wie eesel AI nehmen Ihnen all diese Mühe ab und bieten eine kinderleichte Self-Service-Möglichkeit, Ihr Wissen zu verbinden und den Support zu automatisieren. Anstatt Monate mit dem Aufbau von Infrastruktur zu verbringen, können Sie eine Lösung in wenigen Minuten zum Laufen bringen und sich auf das konzentrieren, was wirklich zählt: Ihre Kunden glücklich zu machen.

Bereit, das Wissen Ihres Unternehmens ohne den technischen Aufwand zu nutzen? Starten Sie kostenlos mit eesel AI.

Häufig gestellte Fragen

Die OpenAI Files API wurde entwickelt, damit Sie Dateien direkt auf den Servern von OpenAI hochladen, verwalten und löschen können. Diese Dateien dienen als Datenquelle für verschiedene KI-Anwendungen, wie z. B. Assistenten, die Feinabstimmung von Modellen oder die Verarbeitung großer Stapel.

Um ein Dokument für einen KI-Assistenten hochzuladen, verwenden Sie den Befehl client.files.create und geben "purpose="assistants"" an. Nach dem Hochladen müssen Sie einen Vektorspeicher erstellen, Ihre Datei(en) hinzufügen und diesen Vektorspeicher mit Ihrem Assistenten verknüpfen für die "file_search"-Funktionalität.

Nein, die OpenAI Files API unterstützt von Haus aus keine Massenoperationen zum Hochladen oder Löschen von Dateien. Entwickler müssen benutzerdefinierte Skripte schreiben, um Dateien einzeln zu durchlaufen und zu verwalten, was bei großen Datensätzen zeitaufwändig sein kann.

Die Kosten für die Nutzung der OpenAI Files API umfassen sowohl die Speicherung als auch die Token-Nutzung. Ihnen werden 0,10 $ pro GB pro Tag für die Dateispeicherung berechnet (das erste GB ist kostenlos), sowie die Prompt-Tokens, die verbraucht werden, wenn ein Assistent "file_search" verwendet, um auf Ihre Dokumente zuzugreifen.

Zu den häufigsten Einschränkungen gehören das Fehlen von Massenoperationen, das Nichtvorhandensein einer visuellen Verwaltungsoberfläche und die asynchrone Natur der Dateiverarbeitung, die ein ständiges Abfragen (Polling) erfordert. Außerdem kann die Verwaltung von Wissen durch die Verknüpfung spezifischer Dateien mit Assistenten komplex werden.

Derzeit gibt es keine direkte visuelle Benutzeroberfläche oder ein Dashboard von OpenAI zur Verwaltung von Dateien, die über die OpenAI Files API hochgeladen wurden. Die gesamte Dateiverwaltung – Hochladen, Auflisten, Statusprüfung und Löschen – muss programmatisch über API-Aufrufe erfolgen.

Ja, integrierte Plattformen wie eesel AI vereinfachen den Prozess erheblich, indem sie die direkte API-Komplexität abstrahieren. Sie bieten Ein-Klick-Integrationen mit bestehenden Wissensquellen, kümmern sich automatisch um die Synchronisierung und Indizierung von Dateien und stellen Werkzeuge für Tests und die Bereitstellung ohne manuelle API-Programmierung zur Verfügung.

Diesen Beitrag teilen

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.