Haben Sie schon einmal versucht, eine KI dazu zu bringen, Fragen mithilfe Ihrer Unternehmensdokumente zu beantworten, nur um dann festzustellen, dass sie diese komplett ignoriert? Wenn ja, sind Sie nicht allein. In Foren macht sich zunehmend eine stille Frustration breit: Sie laden mühsam Ihre internen Leitfäden und Support-Dokumente in einen benutzerdefinierten Bot hoch, stellen eine einfache Frage und erhalten eine selbstbewusst klingende Antwort, die frei erfunden ist.

Wenn Sie die KI dann in die Enge treiben und fragen, ob sie Ihre Dateien verwendet hat, antwortet sie vielleicht sogar mit „Ja“, aber Sie wissen es besser.

Dieses ganze Hin und Her verdeutlicht die enorme Kluft zwischen einer generischen KI und einem Werkzeug, das für Ihr Unternehmen tatsächlich nützlich ist. Die Lösung liegt nicht darin, ausgefallenere Prompts zu schreiben, sondern ein besseres Werkzeug zu verwenden. Was Sie wirklich suchen, ist ein Wissensdatenbank-GPT.

Ein Wissensdatenbank-GPT ist ein benutzerdefiniertes KI-Modell, das speziell dafür entwickelt wurde, Antworten aus den privaten Informationen Ihres Unternehmens zu ziehen. Es liefert Ihnen genaue, relevante Antworten, die auf Ihren Daten basieren und nicht aus dem Wilden Westen des Internets stammen. Dieser Leitfaden erklärt Ihnen, was ein Wissensdatenbank-GPT ist, stellt die drei gängigsten Methoden zum Erstellen eines solchen vor und hilft Ihnen bei der Entscheidung, welcher Weg für Sie der richtige ist.

Was ist ein Wissensdatenbank-GPT?

Stellen Sie sich ein Wissensdatenbank-GPT als eine spezialisierte KI vor, die ein leistungsstarkes Gehirn wie GPT-4 mit der privaten Informationsbibliothek Ihres Unternehmens verbindet. Es ist, als würde man einer brillanten, allwissenden KI eine Kopie des internen Playbooks Ihres Unternehmens geben und ihr sagen: „Lerne nur das hier.“

Die Technologie, die dies ermöglicht, nennt sich Retrieval-Augmented Generation (RAG). Das klingt vielleicht etwas einschüchternd, aber das Konzept ist recht einfach. Bevor die KI Ihre Frage beantwortet, ruft sie zunächst relevante Informationen aus Ihrer spezifischen Wissensdatenbank, Ihrem Help-Center, alten Support-Tickets, internen Wikis oder anderen Quellen ab. Anschließend generiert sie ausschließlich auf Basis dieser handverlesenen Informationen eine präzise Antwort.

Genau das unterscheidet ein Wissensdatenbank-GPT von einem Standard-Chatbot wie ChatGPT. ChatGPT verfügt über ein riesiges, allgemeines Weltwissen bis zu einem bestimmten Zeitpunkt, kann aber nicht in Ihre privaten Dateien blicken. Ein Wissensdatenbank-GPT hingegen hat tiefes, spezifisches und aktuelles Wissen über Ihre Produkte, Richtlinien und Kundenhistorie. So werden Sie „Halluzinationen“ (wenn die KI Fakten erfindet) los, liefern wirklich hilfreiche Antworten und arbeiten sicher mit Ihren eigenen Daten.

Wie man ein Wissensdatenbank-GPT erstellt: Drei gängige Ansätze

Okay, die Idee klingt also gut. Aber wie erstellt man so etwas tatsächlich? Im Allgemeinen haben Sie drei Wege zur Auswahl, jeder mit eigenen Vor- und Nachteilen in Bezug auf Kosten, Komplexität und den Grad der Kontrolle, den Sie haben.

Ansatz 1: Ein Wissensdatenbank-GPT mit dem benutzerdefinierten GPT-Builder von OpenAI erstellen

Für viele, die sich für benutzerdefinierte KI interessieren, ist dies die erste Anlaufstelle. Der GPT-Builder von OpenAI, der in einem kostenpflichtigen ChatGPT-Abonnement enthalten ist, ermöglicht es Ihnen, durch das Hochladen von Dateien und das Geben von Anweisungen eine personalisierte Version von ChatGPT zu erstellen. Er ist als einfache No-Code-Möglichkeit gedacht, um einen benutzerdefinierten Bot zu erstellen.

Sie melden sich einfach für ein Abo an, gehen zum GPT-Builder, laden ein paar Dokumente hoch und sagen dem Bot, wie er sich verhalten soll.

Aber während er für persönliche Projekte unterhaltsam ist, zeigen sich im geschäftlichen Umfeld schnell seine Schwächen. Hier sind die Gründe:

-

Sie werden schnell an eine Skalierungsgrenze stoßen. Sie sind auf das Hochladen von nur 20 Dateien beschränkt. Das ist in Ordnung für ein paar Newsletter, aber bei Weitem nicht genug für die gesamte Bibliothek eines Unternehmens mit Hilfeartikeln, Entwicklerdokumentationen und jahrelangen Support-Tickets.

-

Er ist überraschend wählerisch bei den Dateiformaten. Wie viele auf die harte Tour lernen, scheitert der Uploader an allem, was auch nur annähernd komplex ist, wie PDFs mit Spalten oder Tabellen. Sie können leicht Stunden damit verbringen, Ihre Dokumente in einfache Textdateien umzuwandeln, damit der Bot kooperiert.

-

Sie haben nur sehr wenig echte Kontrolle. Das ist der springende Punkt. Sie können das GPT nicht zwingen, nur Ihre Dokumente zu verwenden. Oft greift es auf sein allgemeines Wissen zurück oder erfindet einfach eine Antwort, was genau das Problem ist, das wir ursprünglich lösen wollten.

-

Das Wissen ist in der Zeit eingefroren. Sie können es nicht mit Live-Daten verbinden. Es weiß nichts über das gerade gelöste Support-Ticket, eine kürzliche Aktualisierung Ihrer Confluence-Seite oder eine Änderung an Ihrem Produkt.

-

Es ist ein Tool für Endverbraucher mit fragwürdiger Sicherheit. Das Hochladen sensibler Unternehmensdaten in ein Tool, das nicht für die Sicherheit von Unternehmen entwickelt wurde, kann ein großes Risiko sein. Sie erhalten keine granulare Kontrolle über die Datenaufbewahrung oder die Sicherheitsfunktionen, die Unternehmen wirklich benötigen.

Was die Preise betrifft, so erfordert die Erstellung eines benutzerdefinierten GPT ein kostenpflichtiges Abonnement. Das Plus-Abo ist für Einzelpersonen, während die Business- und Enterprise-Abos für Teams verfügbar sind. Aber die Funktion für benutzerdefinierte GPTs selbst fühlt sich eher wie eine Spielwiese für Einzelpersonen an als eine sichere, zentral verwaltete Geschäftslösung.

Ansatz 2: Ein benutzerdefiniertes RAG-System von Grund auf neu erstellen

Wenn der GPT-Builder zu eingeschränkt ist, könnte der nächste Schritt für ein Team mit Entwicklern darin bestehen, ein eigenes System von Grund auf zu entwickeln. Dies ist der DIY-Ansatz, bei dem Open-Source-Tools wie LlamaIndex oder LangChain verwendet werden, um die API eines Modells an eine spezialisierte Datenbank anzubinden.

In diesem Szenario würde Ihr Ingenieurteam ein LLM auswählen, eine Vektordatenbank (wie Pinecone) einrichten, um Ihr Wissen zu speichern und zu indizieren, und den gesamten Code schreiben, um alles von der Verarbeitung von Dokumenten bis zur Bearbeitung von Benutzerfragen zu verwalten.

Dieser Weg bietet Ihnen vollständige Flexibilität, ist aber mit hohen Kosten in Form von Zeit, Geld und Kopfschmerzen verbunden.

-

Dies ist ein riesiges Unterfangen, kein Nebenprojekt. Sie benötigen qualifizierte KI-Ingenieure, die das System nicht nur erstellen und starten, sondern auch für die Wartung und Verbesserung zur Verfügung stehen. Es ist ein ernsthaftes Softwareentwicklungsprojekt.

-

Die Kosten können außer Kontrolle geraten. Sie sind für jeden API-Aufruf an OpenAI oder ein anderes LLM verantwortlich, hinzu kommen die Kosten für das Hosting der Vektordatenbank, ganz zu schweigen von den Gehältern der Entwickler. Es ist leicht, dass diese Betriebskosten unvorhersehbar werden.

-

Sie erhalten standardmäßig keine Geschäftsfunktionen. Ein DIY-System ist nur der rohe Motor. Es enthält kein benutzerfreundliches Dashboard, keine Analysen zur Leistungsüberwachung, keine sichere Möglichkeit, Änderungen zu testen, und keine fertigen Verbindungen zu Tools wie Zendesk oder Slack. Ihr Team müsste all das ebenfalls von Grund auf neu erstellen.

Ansatz 3: Eine dedizierte Plattform nutzen

Wenn also das einfache Werkzeug zu schwach und der DIY-Ansatz ein Berg von Arbeit ist, was bleibt dann? Das führt uns zur modernen, auf Unternehmen ausgerichteten Lösung: einer dedizierten KI-Plattform. Dies sind Werkzeuge, die von Grund auf entwickelt wurden, um Ihnen bei der Erstellung, Verwaltung und Bereitstellung eines sicheren Wissensdatenbank-GPT für reale Aufgaben wie den Kundensupport oder interne Helpdesks zu helfen.

Der gesamte Prozess ist viel unkomplizierter. Anstatt sich mit dem Hochladen von Dateien oder dem Schreiben von Code herumzuschlagen, verbinden Sie einfach Ihre vorhandenen Tools über Ein-Klick-Integrationen. Eine Plattform wie eesel AI kümmert sich um die gesamte komplizierte RAG-Mechanik für Sie und führt automatisch Wissen aus all Ihren Quellen zusammen, von Helpdesk-Tickets und Wikis bis hin zu Chat-Tools.

Dieser Ansatz ist darauf ausgelegt, Ihnen die Leistungsfähigkeit eines benutzerdefinierten Systems ohne die Nachteile der beiden anderen Optionen zu bieten.

Warum eine dedizierte Plattform die beste Wahl für Ihr Unternehmen ist

Für jeden ernsthaften geschäftlichen Einsatz ist eine dedizierte Plattform so ziemlich die einzige sinnvolle Option. Sie bietet Ihnen die Leistung eines maßgeschneiderten Systems mit der Einfachheit einer unkomplizierten App.

In Minuten startklar, nicht in Monaten

Während die Entwicklung eines DIY-Systems Monate dauern kann, können Sie mit einer dedizierten Plattform blitzschnell live gehen. Zum Beispiel bietet eesel AI eine vollständige Self-Service-Einrichtung. Sie können sich anmelden, Ihren Helpdesk und Ihre Wissensquellen verbinden und haben in wenigen Minuten einen funktionierenden KI-Agenten einsatzbereit, ohne mit einem Vertriebsmitarbeiter sprechen oder einen Entwickler einstellen zu müssen. Er fügt sich direkt in Ihren aktuellen Arbeitsablauf ein, anstatt Sie zu zwingen, alles zu ändern.

Alles verbinden, nicht nur ein paar Dateien

Vergessen Sie das 20-Dateien-Limit. Eine echte Unternehmens-KI muss alles wissen. Eine Plattform wie eesel AI verbindet sich mit all den Orten, an denen das Wissen Ihres Teams gespeichert ist: frühere Tickets in Zendesk oder Freshdesk, Artikel in Ihrem Help-Center, Seiten in Confluence oder Notion und sogar Unterhaltungen in Slack. Dadurch entsteht eine einheitliche Quelle der Wahrheit, sodass die KI immer über die besten Informationen verfügt.

Volle Kontrolle und zuverlässige Tests

Einer der frustrierendsten Aspekte einfacher KI-Tools ist, nicht zu wissen, was sie sagen werden. Dedizierte Plattformen lösen dieses Problem. Mit eesel AI erhalten Sie präzise Kontrolle, um festzulegen, welche Themen die KI selbstständig bearbeiten soll und welche sie sofort an einen Menschen weiterleiten soll.

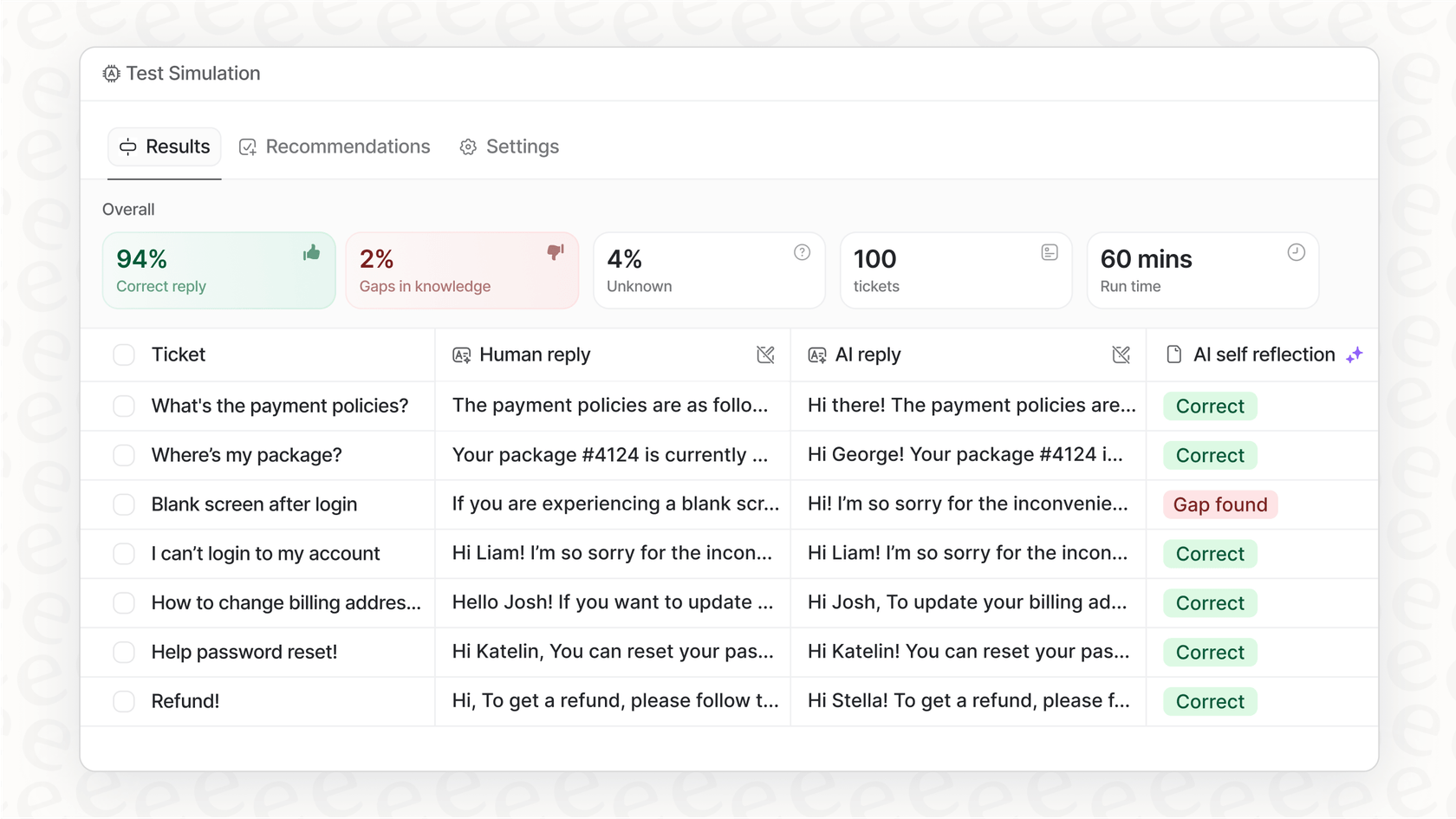

Noch besser: Sie können alles ohne Risiko testen. Der Simulationsmodus in eesel AI ermöglicht es Ihnen, Ihr KI-Setup in einer sicheren Umgebung mit Tausenden Ihrer vergangenen Support-Tickets zu testen. Sie können genau sehen, wie es geantwortet hätte, verlässliche Prognosen zu den Lösungsquoten erhalten und sein Verhalten optimieren, bevor es jemals mit einem echten Kunden spricht. Dies ist eine entscheidende Funktion, die Sie bei einfachen Buildern oder DIY-Setups einfach nicht bekommen.

Ruhig schlafen mit Sicherheit auf Unternehmensniveau

Ein Verbraucher-Tool für sensible Geschäftsdaten zu verwenden, ist einfach keine Option. Dedizierte Plattformen sind mit Blick auf ernsthafte Sicherheit entwickelt worden. Plattformen wie eesel AI garantieren, dass Ihre Daten niemals zum Trainieren ihrer Modelle verwendet werden. Alle Ihre Informationen werden verschlüsselt, von anderen Kunden getrennt gehalten und können in bestimmten Regionen (wie der EU) gehostet werden, um Compliance-Anforderungen zu erfüllen. Das ist das Maß an Sicherheit und Datenschutz, das Unternehmen für einen sicheren Betrieb benötigen.

Wählen Sie das richtige Werkzeug für Ihr Wissensdatenbank-GPT

Ein Wissensdatenbank-GPT kann die Art und Weise, wie Ihr Unternehmen sein internes Wissen nutzt, völlig verändern, aber die Wahl des richtigen Ansatzes ist entscheidend.

Der GPT-Builder von OpenAI ist ein nettes Werkzeug für persönliche Experimente. Ein von Grund auf neu entwickeltes RAG-System gibt Ihnen ultimative Macht, kostet aber ein Vermögen an Zeit und Ressourcen. Für die meisten Unternehmen ist keines von beiden die richtige Wahl.

| Merkmal | OpenAI GPT-Builder | DIY RAG-System | Dedizierte Plattform (eesel AI) |

|---|---|---|---|

| Einrichtungszeit | Stunden | Monate | Minuten |

| Erforderliche Kenntnisse | Nicht-technisch | Experten-Entwickler | Nicht-technisch |

| Skalierbarkeit | Sehr gering | Sehr hoch | Hoch |

| Kontrolle & Testen | Gering | Hoch (falls implementiert) | Granular & integriert |

| Sicherheit | Verbraucher-Niveau | Benutzerdefiniert | Unternehmens-Niveau |

| Kosten | Gering (Abonnement) | Hoch (Entwicklung + Infrastruktur) | Vorhersehbar (SaaS) |

Für jedes Unternehmen, das ein zuverlässiges, sicheres und skalierbares Wissensdatenbank-GPT ohne Kopfzerbrechen benötigt, ist eine dedizierte Plattform der klare Gewinner. Sie liefert die Leistung, die Sie benötigen, mit der Geschwindigkeit und Einfachheit, die Ihr Team zu schätzen wissen wird.

Bereit, ein Wissensdatenbank-GPT zu erstellen, das für Ihr Unternehmen wirklich funktioniert? Testen Sie eesel AI kostenlos und sehen Sie, wie schnell Sie beginnen können, den Support mit Ihrem eigenen Wissen zu automatisieren.

Häufig gestellte Fragen

Ein Wissensdatenbank-GPT ist ein KI-Modell, das speziell dafür entwickelt wurde, Antworten aus den privaten Informationen Ihres Unternehmens zu ziehen, indem es die Retrieval-Augmented Generation (RAG)-Technologie nutzt. Im Gegensatz zu einem Standard-Chatbot ist es darauf trainiert, nur Ihre internen Dokumente und Daten zu verwenden, was genaue, unternehmensspezifische Antworten anstelle von allgemeinem Web-Wissen oder erfundenen Fakten gewährleistet.

Obwohl der benutzerdefinierte GPT-Builder von OpenAI für den persönlichen Gebrauch praktisch ist, hat er erhebliche Einschränkungen für Unternehmen. Er bietet ein niedriges Dateilimit, hat Schwierigkeiten mit komplexen Dateiformaten, bietet nur begrenzte Kontrolle über seine Wissensquellen, kann keine Verbindung zu Live-Daten herstellen und es fehlen ihm die Sicherheitsfunktionen auf Unternehmensniveau, die für sensible Unternehmensinformationen erforderlich sind.

Dedizierte Plattformen bieten eine schnelle Einrichtung (Minuten statt Monate), lassen sich nahtlos in all Ihre bestehenden Wissensquellen (wie Zendesk, Confluence, Slack) integrieren, bieten granulare Kontrolle und robuste Testfunktionen (wie einen Simulationsmodus) und gewährleisten Sicherheit auf Unternehmensniveau für Ihre Daten. Sie verwalten die gesamte technische Komplexität, sodass sich Ihr Team auf die Ergebnisse konzentrieren kann.

Dedizierte Plattformen können im Gegensatz zu einfachen Buildern über Ein-Klick-Integrationen eine Verbindung zu Live-Datenquellen herstellen. Das bedeutet, Ihr Wissensdatenbank-GPT bleibt automatisch mit den neuesten Support-Tickets, aktualisierten Wiki-Seiten oder Änderungen an Ihren Produktinformationen auf dem Laufenden und stellt sicher, dass es immer über die aktuellsten Daten verfügt.

Ja, mit einer dedizierten Plattform erhalten Sie präzise Kontrolle. Sie können spezifische Themen definieren, die die KI autonom bearbeiten soll, und klare Regeln festlegen, wann sie eine Anfrage an einen menschlichen Mitarbeiter eskalieren soll, was eine nahtlose Übergabe gewährleistet und die Servicequalität aufrechterhält.

Absolut. Dedizierte Plattformen sind speziell mit Blick auf Sicherheit auf Unternehmensniveau entwickelt worden. Sie stellen sicher, dass Ihre Daten verschlüsselt, von anderen Kunden getrennt gehalten, niemals zum Trainieren ihrer eigenen Modelle verwendet werden und spezifische regionale Anforderungen an das Datenhosting, wie die in der EU, erfüllen können.

Mit einer dedizierten Plattform wie eesel AI können Sie ein funktionierendes Wissensdatenbank-GPT in Minuten statt Monaten live schalten. Die Self-Service-Einrichtung ermöglicht es Ihnen, Ihre bestehenden Helpdesk- und Wissensquellen effizient zu verbinden, ohne dass Entwickler oder umfangreiche Konfigurationen erforderlich sind.

Diesen Beitrag teilen

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.