Seien wir ehrlich, IT- und Support-Teams stehen unter enormem Druck, KI in ihre Arbeitsabläufe zu integrieren. Das Versprechen ist riesig: weniger lästige Routinearbeit, schnellere Problemlösungen und zufriedenere Mitarbeiter. Aber wenn Sie mit einer so komplexen Plattform wie ServiceNow arbeiten, wissen Sie, dass dieses Versprechen oft in weiter Ferne zu liegen scheint.

Sie haben wahrscheinlich die Horrorgeschichten aus Entwicklerforen und Community-Diskussionen gehört. KI-Assistenten, die Dinge erfinden (oder „halluzinieren“), Setups, die sich wie ein zweiter Job anfühlen, und nagende Sorgen um den Datenschutz. Wie also stellt man das Ganzen richtig an?

Dieser Leitfaden soll Licht ins Dunkel bringen. Wir werden die drei Hauptwege zur Integration von KI in ServiceNow durchgehen und uns die Vor-, Nachteile und die Tücken jedes einzelnen ansehen. Am Ende werden Sie eine klare Vorstellung davon haben, welcher Weg für Ihr Team am sinnvollsten ist.

KI-Integration in ServiceNow verstehen

Was meinen wir eigentlich, wenn wir von „KI-Integration in ServiceNow“ sprechen? Im Grunde bedeutet es nur, eine Form von künstlicher Intelligenz an Ihr ServiceNow-System anzubinden, um Aufgaben zu automatisieren, Erkenntnisse zu gewinnen und es den Nutzern allgemein zu erleichtern, Hilfe zu bekommen. Es geht darum, Ihren Service Desk ein wenig intelligenter und effizienter zu machen.

Aber es gibt nicht den einen richtigen Weg. Um die Optionen zu verstehen, können wir sie in drei Hauptstrategien unterteilen:

-

Nutzung der nativen KI von ServiceNow (Now Assist): Die eingebaute, sofort einsatzbereite Option.

-

Aufbau einer benutzerdefinierten Integration: Der komplette DIY-Ansatz mit einer allgemeinen KI wie ChatGPT.

-

Verwendung einer spezialisierten Plug-and-Play-KI-Plattform: Ein Drittanbieter-Tool, das speziell für diese Art von Arbeit entwickelt wurde.

Schauen wir uns an, was jede dieser Optionen tatsächlich beinhaltet.

Nutzung der nativen KI von ServiceNow: Now Assist

Now Assist ist ServiceNows eigene generative KI-Lösung, die direkt in die Plattform integriert ist. Sie wurde entwickelt, um bei gängigen Aufgaben im IT Service Management (ITSM) zu helfen, von der Zusammenfassung von Tickets und der Generierung von Code bis hin zur Steuerung von Chatbots.

Die wichtigsten Funktionen von Now Assist

Auf den ersten Blick bietet Now Assist ein ziemlich ansprechendes Funktionsset:

-

Incident-Zusammenfassung: Dies hilft Agenten, sich schnell einen Überblick über lange, komplizierte Ticketverläufe zu verschaffen, ohne jedes einzelne Update lesen zu müssen.

-

Flow-Generierung: Es verspricht, Workflows mit einfachen englischen Anweisungen zu erstellen, was für Administratoren eine Zeitersparnis sein könnte.

-

Virtual Agent: Dies ist der Motor hinter den Chatbots, die Self-Service-Anfragen von Mitarbeitern bearbeiten, mit dem Ziel, häufige Fragen abzufangen.

Einschränkungen und Herausforderungen bei der Nutzung von Now Assist

Obwohl ein integriertes Tool wie der einfachste Weg klingt, stoßen Teams oft auf einige häufige Probleme. Wenn man sich Nutzerfeedback und Community-Diskussionen ansieht, zeigen sich wiederkehrende Probleme, die Now Assist unzuverlässig machen.

Das erste große Ärgernis ist, dass die KI ungenau sein und Dinge erfinden kann. Entwickler berichten, dass die KI in Low-Code-Bereichen wie dem Flow Designer durcheinanderkommen kann. Sie erfindet manchmal nicht existierende Felder oder verweist auf veraltete Teile der Benutzeroberfläche, was sie für alles, was über einfache Skripte hinausgeht, unzuverlässig macht. Das zwingt Sie, ihre Arbeit ständig zu überprüfen, was den Zweck der Automatisierung irgendwie zunichtemacht.

Zweitens hängt ihre Effektivität vollständig von perfekten Daten ab. Damit Now Assist nützliche Zusammenfassungen oder Lösungen liefern kann, benötigt es eine umfangreiche Tickethistorie mit umfassenden, gut geschriebenen Notizen. Seien wir ehrlich, das ist für die meisten vielbeschäftigten Service Desks nicht die Realität. Wenn Ihre Daten nicht makellos sind, wird es die Ausgabe der KI auch nicht sein.

Schließlich gibt es da noch die Preise und die Komplexität. ServiceNow verwendet ein verwirrendes „pro Assist“-Preismodell, bei dem verschiedene Aktionen unterschiedliche Mengen an Credits verbrauchen. Das macht die Kosten schwer vorhersehbar und noch schwerer zu budgetieren. Obendrein erhalten Sie keine Preisinformationen, ohne ein Verkaufsgespräch zu führen, was eine zusätzliche Hürde darstellt. Und obwohl es „nativ“ ist, ist es kein einfacher Schalter, den man umlegen kann; es erfordert immer noch eine beträchtliche Menge an Zeit und Fachwissen, um es korrekt zu konfigurieren.

Aufbau einer benutzerdefinierten KI-Integration

Die nächste Option ist der komplette DIY-Weg. Hier verwenden Entwickler APIs, um große Sprachmodelle (LLMs) wie GPT-4 von OpenAI direkt mit ihrer ServiceNow-Instanz zu verbinden. Diese Methode taucht häufig in Entwicklerforen auf, insbesondere für sehr spezifische, codebezogene Aufgaben.

Häufige Anwendungsfälle für benutzerdefinierte Integrationen

Dieser Ansatz kann in einigen Nischenbereichen gut funktionieren:

-

Code-Generierung & Refactoring: Es kann sehr nützlich sein, um Entwicklern beim Schreiben oder Bereinigen von Backend-Skripten zu helfen, bei denen der Kontext einfach und klar definiert ist.

-

Verständnis von obskurem Code: Es kann als zweites Augenpaar dienen, um komplexen, standardmäßigen ServiceNow-Code zu verstehen, der nicht gut dokumentiert ist.

Warum dieser Ansatz riskant ist

Obwohl er Flexibilität bietet, ist der Aufbau einer benutzerdefinierten Integration ein Weg voller versteckter Komplexitäten und Risiken.

Workflow für benutzerdefinierte KI-Integration

Es erfordert einen enormen Entwicklungsaufwand. Sie schließen nicht einfach nur etwas an; Sie bauen und warten API-Verbindungen, erstellen benutzerdefinierte Tabellen zur Speicherung von Konversationsverläufen und schreiben Geschäftsregeln zur Verwaltung der Logik. Dies ist kein Nebenprojekt; es erfordert engagierte, qualifizierte Entwickler, die sowohl Experten für ServiceNow als auch für die von Ihnen verwendete KI-Plattform sind.

Die größte Herausforderung ist jedoch das Kontextproblem. Eine generische KI wie ChatGPT hat keine Ahnung, wie Ihre ServiceNow-Instanz aussieht. Sie kennt Ihre benutzerdefinierten Tabellen, Ihre internen Geschäftsregeln oder Ihre einzigartigen Workflows nicht. Infolgedessen halluziniert sie. Um dies zu umgehen, müssen Entwickler manuell „Systemkontext“ erstellen und der KI zuführen, oft in Form von riesigen, komplexen JSON-Dateien, die die Konfiguration Ihres Unternehmens detailliert beschreiben. Das ist eine unglaublich ineffiziente und fragile Lösung, die sich kaum skalieren oder warten lässt.

Dann gibt es die erheblichen Datenschutzrisiken. Wenn Sie eine Anfrage an eine Drittanbieter-API senden, senden Sie auch die Daten Ihres Unternehmens mit. Dies kann sensible Kundeninformationen oder interne Unternehmensdetails beinhalten, was ein ernsthaftes Sicherheits- und Compliance-Problem darstellt. Für viele Organisationen ist dieses Risiko allein schon ein absolutes K.-o.-Kriterium.

Schließlich haben Sie es mit unvorhersehbaren Kosten zu tun. Die meisten großen KI-APIs verwenden ein Token-basiertes Preismodell. Während ein einzelner API-Aufruf billig erscheinen mag, summieren sich die Kosten in einer hochvolumigen ITSM-Umgebung schnell. Die Budgetierung wird zu einem Ratespiel, und ein geschäftiger Monat könnte Ihnen eine überraschend hohe Rechnung bescheren.

Verwendung einer spezialisierten KI-Plattform

Dies führt uns zu einer dritten Option, die eine Balance zwischen der Leistungsfähigkeit eines Eigenbaus und der Einfachheit eines nativen Tools herstellt. Spezialisierte KI-Plattformen sind von Grund auf für Support- und ITSM-Teams konzipiert und bieten einen viel reibungsloseren Weg zu einer effektiven KI-Integration in ServiceNow.

Plattformen wie eesel AI sind darauf ausgelegt, genau die Herausforderungen zu umgehen, die native und benutzerdefinierte Lösungen so schwierig machen. Anstatt zu versuchen, ein Alleskönner zu sein, konzentrieren sie sich darauf, eine Sache außergewöhnlich gut zu machen: Ihren Service Desk intelligenter zu machen.

Wie eine spezialisierte Plattform gängige Herausforderungen löst

So verändert ein dediziertes Tool das Spiel:

-

In Minuten statt Monaten einsatzbereit: Vergessen Sie lange, langwierige Implementierungsprojekte. eesel AI bietet eine Ein-Klick-Helpdesk-Integration, die sich direkt in Ihre bestehenden ServiceNow-Workflows einfügt. Es ist wirklich Self-Service, sodass Sie es einrichten und zum Laufen bringen können, ohne einen einzigen Verkaufsanruf oder eine obligatorische Demo. Dies hilft Ihnen, die störenden „Rip-and-Replace“-Projekte zu vermeiden, die viele andere KI-Lösungen erfordern.

-

Schluss mit Halluzinationen durch die Vereinheitlichung all Ihres Wissens: Dies ist der Schlüssel zur Lösung des Kontextproblems. eesel AI verbindet sich sofort mit allen Ihren Wissensquellen, nicht nur mit dem, was sich in ServiceNow befindet. Es zieht Informationen aus Confluence, Google Docs, Slack und über 100 anderen Quellen, um der KI ein vollständiges und genaues Bild Ihrer Organisation zu geben. Mit diesem vollständigen Kontext kann die KI zuverlässige Antworten geben und hört auf, Dinge zu erfinden.

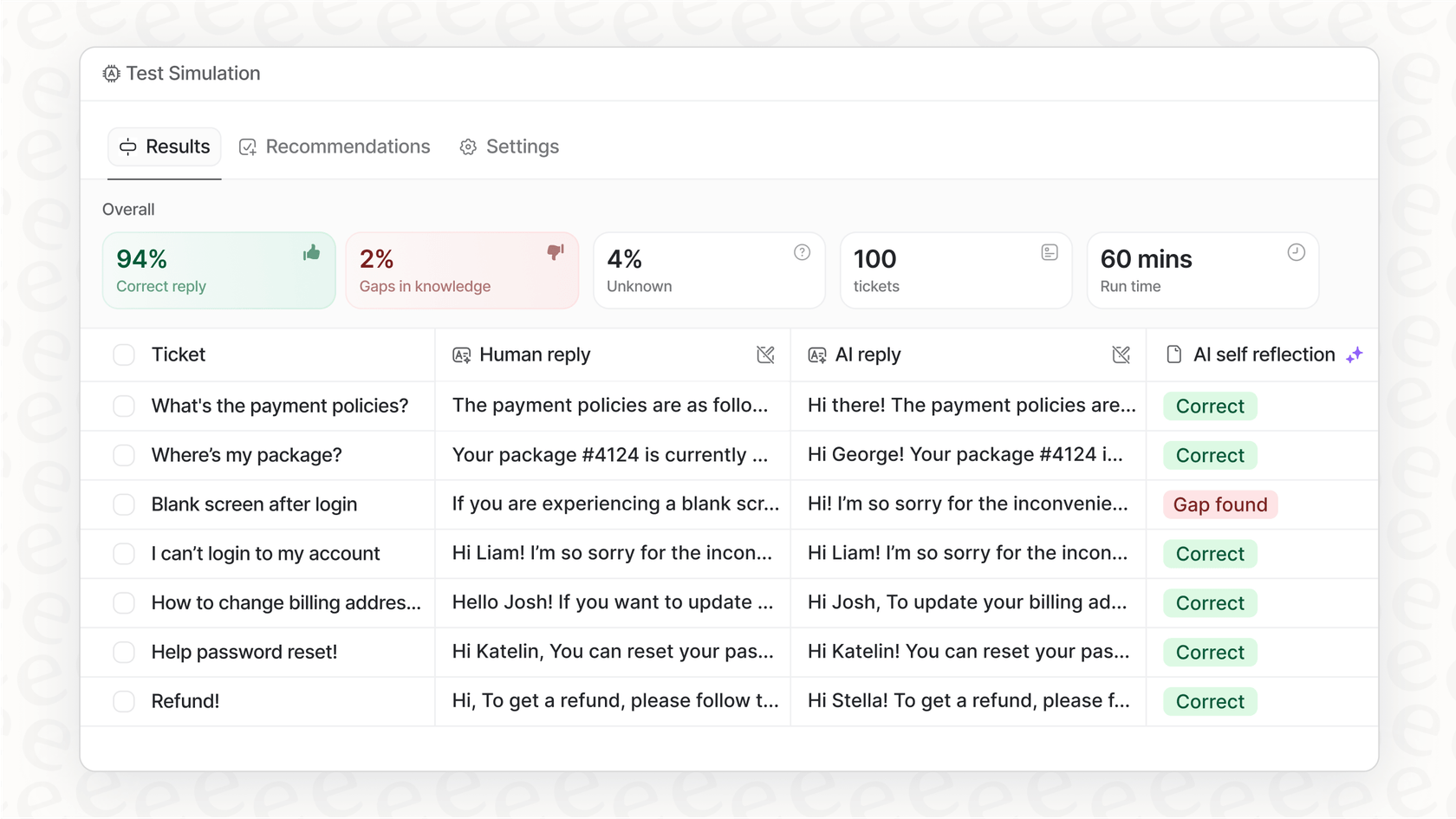

- Sicher testen und die volle Kontrolle behalten: Der Einsatz von KI sollte sich nicht wie ein Vertrauensvorschuss anfühlen. eesel AI verfügt über einen Simulationsmodus, mit dem Sie Ihr Setup an Tausenden von historischen Tickets testen können, bevor es jemals mit einem echten Benutzer spricht. Sie können genau sehen, wie es sich verhalten wird, und genaue Prognosen zu den Lösungsraten erhalten. Sie erhalten auch detaillierte Kontrolle, um selektiv zu automatisieren, vielleicht beginnend mit einfachen Tier-1-Tickets und alles andere an einen Menschen eskalierend.

- Genau wissen, wofür Sie bezahlen: Kein Ratespiel mehr bei Ihrem Budget. eesel AI verwendet ein klares, gestaffeltes Preismodell basierend auf der Nutzung, ohne Gebühren pro Lösung oder „pro Assist“. Sie wissen genau, wie hoch Ihre Rechnung jeden Monat sein wird, was es einfach macht, Ihren Return on Investment zu berechnen. Sie können sogar mit einem flexiblen Monatsplan beginnen und jederzeit kündigen.

Vergleich der drei Ansätze

Wenn man alles gegenüberstellt, werden die Unterschiede ziemlich deutlich.

| Funktion | Native KI (Now Assist) | Benutzerdefinierte KI (ChatGPT API) | Spezialisierte Plattform (eesel AI) |

|---|---|---|---|

| Einrichtungszeit | Wochen bis Monate | Wochen bis Monate | Minuten bis Stunden |

| Genauigkeit | Mäßig, anfällig für UI-Halluzinationen | Niedrig ohne umfassenden Kontext | Hoch, basierend auf vereinheitlichtem Wissen |

| Datenschutz | Innerhalb von ServiceNow verwaltet | Hohes Risiko (Daten an Dritte gesendet) | Sicher, mit EU-Residenzoptionen |

| Wartung | Laufende Konfiguration | Hoch (API-Änderungen, benutzerdefinierter Code) | Gering (von der Plattform verwaltet) |

| Kostenmodell | Unvorhersehbar („pro Assist“) | Unvorhersehbar (pro Token) | Vorhersehbar (feste monatliche Gebühr) |

| Testen | Begrenzt | Manuell, ad-hoc | Leistungsstarke Simulation auf Basis vergangener Tickets |

Die richtige Wahl treffen

Welchen Weg sollten Sie also einschlagen? Es hängt wirklich von den Ressourcen, Zielen und der Risikobereitschaft Ihres Teams ab.

-

Entscheiden Sie sich für die native KI, wenn: Sie tief in das ServiceNow-Ökosystem investiert sind, ein großes und flexibles Budget für diese „Assist“-Credits haben und über die hauseigenen technischen Experten verfügen, um eine komplexe, laufende Konfiguration zu verwalten.

-

Entscheiden Sie sich für eine benutzerdefinierte KI, wenn: Sie ein starkes, engagiertes Entwicklungsteam mit freier Zeit haben, einen sehr engen und spezifischen Anwendungsfall (wie Skript-Refactoring nur für Entwickler) und bereits eine Lösung für die ernsten Datenschutzbedenken intern gefunden haben.

-

Entscheiden Sie sich für eine spezialisierte Plattform, wenn: Sie eine schnelle, zuverlässige und sichere Lösung benötigen, die sofort einsatzbereit ist. Dies ist die richtige Wahl, wenn Sie all Ihr verstreutes Wissen zusammenführen, einen vorhersehbaren ROI erzielen und Ihr Team stärken möchten, ohne einen dedizierten KI-Entwickler einstellen zu müssen.

Die Zukunft ist integriert und intelligent

Da haben Sie es, ein paar verschiedene Wege, wie man KI in ServiceNow integrieren kann, jeder mit seinen eigenen Kompromissen. Während native Tools sich langsam verbessern und Eigenbauten ultimative Flexibilität für diejenigen mit den entsprechenden Ressourcen bieten, haben sich spezialisierte Plattformen für die meisten ITSM- und Support-Teams als der schnellste und zuverlässigste Weg zum Erfolg herauskristallisiert.

Das Ziel ist nicht nur, KI zu haben; es geht darum, eine KI zu haben, die tatsächlich für Sie arbeitet. Die richtige Integration macht sie zu einem wirklich hilfreichen Teamkollegen, nicht nur zu einem weiteren komplexen System, das Sie verwalten müssen.

Bereit zu sehen, wie eine spezialisierte KI-Plattform Ihre ServiceNow-Erfahrung ohne Kopfschmerzen verändern kann?

Starten Sie mit eesel AI und verbinden Sie es in wenigen Minuten mit Ihren Wissensquellen. Sie können die Leistung auf Basis Ihrer vergangenen Tickets simulieren und das Potenzial für Automatisierung und Effizienz aus erster Hand sehen.

Häufig gestellte Fragen

Die Integration von KI in ServiceNow bedeutet, Funktionen der künstlichen Intelligenz mit Ihrer ServiceNow-Instanz zu verbinden. Dies geschieht typischerweise, um Aufgaben zu automatisieren, Erkenntnisse zu gewinnen und die Benutzererfahrung zu verbessern, indem Ihr Service Desk effizienter und intelligenter wird.

Dieser Leitfaden beschreibt drei Hauptstrategien: die Verwendung der nativen KI von ServiceNow (Now Assist), den Aufbau einer benutzerdefinierten Integration mit einer allgemeinen KI wie ChatGPT oder die Nutzung einer spezialisierten Plug-and-Play-KI-Plattform, die für ITSM entwickelt wurde. Jede Methode hat unterschiedliche Vorteile und Herausforderungen.

Benutzer berichten oft von Problemen mit der Genauigkeit von Now Assist, bei denen es „halluzinieren“ oder nicht existierende Felder erfinden kann. Seine Wirksamkeit hängt auch stark von perfekt sauberen und umfassenden historischen Daten ab, und sein „pro Assist“-Preismodell kann unvorhersehbar sein.

Benutzerdefinierte Integrationen erfordern einen massiven Entwicklungsaufwand, haben Schwierigkeiten, der KI genügend Kontext über Ihre spezifische ServiceNow-Instanz zu geben (was zu Halluzinationen führt), bergen erhebliche Datenschutzrisiken beim Senden von Daten an Drittanbieter-APIs und sind mit unvorhersehbaren tokenbasierten Kosten verbunden.

Spezialisierte Plattformen bieten schnelle Ein-Klick-Integrationen, die Wissen aus allen Quellen bündeln, um Halluzinationen zu vermeiden. Sie bieten auch Simulationsmodi für sicheres Testen und klare, vorhersehbare Preise und umgehen so die Komplexität nativer oder benutzerdefinierter Lösungen.

Die Kostenmodelle variieren erheblich. Native KI verwendet oft unvorhersehbare „pro Assist“-Credits, Eigenbauten haben unvorhersehbare tokenbasierte API-Kosten, und spezialisierte Plattformen bieten typischerweise klare, gestaffelte monatliche Gebühren, was die Budgetierung und die ROI-Berechnung erheblich erleichtert.

Bei nativer KI bleiben die Daten im Allgemeinen innerhalb von ServiceNow. Benutzerdefinierte Integrationen bergen hohe Datenschutzrisiken, da sensible Unternehmensdaten an KI-APIs von Drittanbietern gesendet werden könnten. Spezialisierte Plattformen legen oft Wert auf Sicherheit und bieten Funktionen wie EU-Datenresidenz und stellen sicher, dass Daten nicht für das Training öffentlicher Modelle verwendet werden.

Diesen Beitrag teilen

Article by

Kenneth Pangan

Writer and marketer for over ten years, Kenneth Pangan splits his time between history, politics, and art with plenty of interruptions from his dogs demanding attention.