Die KI-Welt bewegt sich in einem schwindelerregenden Tempo. In einem Moment hört man von einem neuen Modell, und im nächsten fühlt es sich schon wieder wie eine alte Nachricht an. Für jeden, der tatsächlich etwas mit KI entwickeln möchte, kann die Wahl des richtigen großen Sprachmodells (LLM) weniger wie eine strategische Entscheidung wirken und mehr wie der Versuch, einen fahrenden Zug zu erwischen.

Wenn man etwas Reales entwickeln muss, muss man den Hype durchschauen und herausfinden, was tatsächlich funktioniert. Zwei der aktuell größten Schwergewichte sind Googles Gemini und Mistral AI. Sie kommen aus sehr unterschiedlichen Richtungen und haben verschiedene Vorstellungen davon, wie man leistungsstarke KI entwickelt. Dieser Leitfaden führt Sie durch die Debatte Gemini vs. Mistral und vergleicht ihre Leistung, ihre Kosten und wie sie sich im täglichen Geschäftsgebrauch schlagen.

Gemini vs. Mistral: Was sind Google Gemini und Mistral AI?

Bevor wir ins Detail gehen, verschaffen wir uns einen kurzen Überblick über diese beiden Konkurrenten. Sie sind nicht einfach nur austauschbare KI-Gehirne; sie haben unterschiedliche Hintergründe und Ziele.

Google Gemini: Das Kraftpaket

Gemini ist Googles „Baby“ und hat die volle Unterstützung eines der größten Technologieunternehmen der Welt. Es ist ein multimodales Modell, was nur eine technische Art ist zu sagen, dass es von Anfang an darauf ausgelegt war, Text, Code, Bilder und Videos gleichzeitig zu verstehen. Sie finden Gemini in Tools wie Gemini Advanced und integriert in das Google-Ökosystem, von Workspace bis zur unternehmenstauglichen Vertex AI-Plattform.

Der Hauptvorteil von Gemini ist seine schiere Größe. Es hat Zugriff auf die riesigen Datensätze von Google und zeigt beeindruckende Fähigkeiten bei Aufgaben, die komplexes, mehrstufiges Denken erfordern. Es ist als eine „Alles-in-einem“-KI konzipiert, die so gut wie alles bewältigen kann, was man ihr vorlegt.

Mistral AI: Der Herausforderer

Auf der anderen Seite haben wir Mistral AI, ein in Paris ansässiges Unternehmen, das durch seinen Fokus auf Effizienz und Open-Source-Modelle berühmt wurde. Obwohl sie auch kostenpflichtige kommerzielle Modelle anbieten, sind sie bekannt für ihre „Open-Weight“-Modelle wie Mistral 7B und Mixtral. Das bedeutet, sie veröffentlichen die Kerndateien des Modells, sodass Entwickler die Modelle auf ihren eigenen Servern anpassen, feinabstimmen und ausführen können.

Mistral hat sich bei Entwicklern einen soliden Ruf erarbeitet, indem es Modelle entwickelt, die weit über ihrer Gewichtsklasse liegen. Sie liefern eine starke Leistung, ohne ein Lagerhaus voller GPUs zu benötigen. Ihre Antworten werden oft als prägnant und direkt beschrieben, was sie zu einem Favoriten für Geschäftsworkflows macht, bei denen man einfach eine zuverlässige Antwort ohne zusätzliches Gerede benötigt.

Gemini vs. Mistral: Leistung und Fähigkeiten

Also, wie schlagen sie sich in der Praxis? Das „beste“ Modell hängt wirklich davon ab, was Sie erreichen möchten. Eine KI, die brillant darin ist, eine kreative Marketing-E-Mail zu schreiben, ist möglicherweise nicht die richtige Wahl, um sauberen, produktionsreifen Code zu generieren.

Gemini vs. Mistral: Logisches Denken, Genauigkeit und der „Füllfaktor“

Verbringen Sie fünf Minuten in einem beliebigen Entwicklerforum, und Sie werden ein gemeinsames Thema entdecken: Die Leute sprechen viel über die Atmosphäre der Antworten. Nutzer sagen oft, dass Mistral-Modelle direkt auf den Punkt kommen. Sie geben eine Antwort ohne gesprächige Aufwärmphasen wie „Das ist eine tolle Frage!“ oder andere Füllwörter, die Antworten von größeren Modellen manchmal aufblähen können. Für viele Geschäftsanwendungen fühlt sich dieser direkte, „schnörkellose“ Stil berechenbarer und vertrauenswürdiger an.

Natürlich kann jedes Modell „halluzinieren“ oder Dinge erfinden, aber die Prägnanz von Mistral kann es bei unkomplizierten Aufgaben zuverlässiger erscheinen lassen. Gemini hingegen gibt in der Regel detailliertere, umfassendere Antworten. Das kann großartig für Brainstorming oder wenn Sie einen tiefen Einblick in ein komplexes Thema benötigen, kann aber auch bedeuten, dass Sie mehr Text durchlesen müssen, um die Kernantwort zu finden.

Es ist auch wichtig zu bedenken, dass die Leistung je nach Aufgabe drastisch variieren kann. Zum Beispiel fand ein direkter Vergleich zur OCR-Genauigkeit, dass Gemini Flash 2.0 bei einer Vielzahl von Dokumenten deutlich genauer war als das OCR-Modell von Mistral. Dies ist eine gute Erinnerung daran, dass die von den Unternehmen selbst veröffentlichten Benchmarks nicht immer die Leistung in der realen Welt widerspiegeln. Man muss es selbst testen.

Aufgabenspezifische Stärken

Schauen wir uns an, wie diese Modelle bei einigen gängigen Geschäftsaufgaben abschneiden.

-

Programmierung: Beide Modelle sind ziemlich praktisch für die Codegenerierung. Viele Entwickler neigen jedoch bei Produktionsszenarien zu Mistral. Dessen Ausgabe ist oft sauberer und konsistenter, was die Integration in automatisierte Arbeitsabläufe erleichtert. Mistral hat auch spezialisierte Modelle wie Codestral, die speziell für die Programmierung feinabgestimmt sind.

-

Schreiben & Kreativität: Hier glänzt Gemini oft. Sein gesprächiger und gründlicher Stil eignet sich gut für kreatives Schreiben, das Brainstorming von Marketingtexten und die Erstellung von Texten, die sich menschlich anfühlen. Mistrals Standardton ist tendenziell professioneller und sachlicher, was perfekt für Berichte oder Zusammenfassungen ist, aber vielleicht nicht für Ihre nächste große Werbekampagne.

-

Dokumenten- & Datenanalyse: Gemini hat hier aufgrund seines riesigen Kontextfensters einen enormen Vorteil. Das Kontextfenster ist im Grunde die Menge an Informationen, die das Modell gleichzeitig in seinem Kurzzeitgedächtnis behalten kann. Mit Gemini 1.5 Pro, das bis zu 2 Millionen Token (das sind etwa 1,5 Millionen Wörter) verarbeiten kann, kann es unglaublich lange Dokumente, ganze Codebasen oder stundenlange Videos durcharbeiten. Mistrals Modelle, wie Mistral Large mit seinem 32.000-Token-Fenster, sind hier viel begrenzter.

Eine direkte Vergleichstabelle

Hier ist ein kurzer Überblick über ihre qualitativen Unterschiede.

| Merkmal | Google Gemini | Mistral AI | Gewinner |

|---|---|---|---|

| Antwortstil | Eher gesprächig und umfassend, kann langatmig sein. | Prägnant, direkt und auf den Punkt; weniger „Füllmaterial“. | Hängt vom Anwendungsfall ab |

| Programmierung | Starke, allgemeine Programmierfähigkeiten. | Hoch angesehen für saubere, stabile Codegenerierung; spezialisierte Modelle. | Mistral (für die Produktion) |

| Kreative Aufgaben | Oft bevorzugt für Brainstorming und menschenähnliches Schreiben. | Standardmäßig eher sachlicher und professioneller Ton. | Gemini |

| Dokumentenanalyse | Hervorragend aufgrund des riesigen Kontextfensters (bis zu 2 Mio. Token). | Begrenzt durch kleineres Kontextfenster (z. B. 32K Token). | Gemini |

| Wahrgenommenes Vertrauen | Kann manchmal übervorsichtig wirken oder politische Anfragen ablehnen. | Direktheit wird oft als stabiler und zuverlässiger für Unternehmen wahrgenommen. | Mistral (für Unternehmen) |

Gemini vs. Mistral: Technische Spezifikationen und Funktionen

Für jeden, der tatsächlich mit diesen Modellen entwickelt, sind die technischen Details entscheidend. Hier ist, wie sie sich vergleichen.

Modellfamilien und Varianten

Sowohl Google als auch Mistral bieten eine Auswahl an Modellen für unterschiedliche Bedürfnisse an, sodass Sie Leistung, Geschwindigkeit und Kosten abwägen können.

-

Gemini: Die beiden Hauptoptionen, die über ihre API verfügbar sind, sind Gemini 1.5 Pro, ihr leistungsstarkes Spitzenmodell, und Gemini 1.5 Flash, das für Geschwindigkeit und Effizienz in Situationen mit hohem Volumen entwickelt wurde.

-

Mistral: Ihr Angebot hat mehr Stufen:

- Open-Weight-Modelle: Mistral 7B und Mixtral 8x7B sind die erste Wahl für Entwickler, die die Modelle selbst hosten oder mit ihren eigenen Daten feinabstimmen möchten.

- Kommerzielle Modelle: Mistral Small, Mistral Medium und Mistral Large 2 sind ihre optimierten Modelle, auf die Sie per API zugreifen können und die eine gute Mischung aus Preis und Leistung bieten.

- Spezialistenmodelle: Sie entwickeln auch spezifische Modelle wie Codestral, das sich auf die Generierung und Vervollständigung von Code konzentriert.

Gemini vs. Mistral: Kontextfenster und Wissensstichtag

Das Kontextfenster ist einer der größten technischen Unterschiede zwischen ihnen. Wie bereits erwähnt, ist die Fähigkeit von Gemini 1.5 Pro, bis zu 2 Millionen Token zu verarbeiten, ein massiver Vorteil für jeden, der mit großen Informationsmengen arbeitet. Das 32.000-Token-Fenster von Mistral Large ist immer noch sehr nützlich, aber es spielt einfach nicht in derselben Liga.

Ein weiterer Punkt ist der Wissensstichtag, also das „Haltbarkeitsdatum“ der Trainingsdaten des Modells. Einige von Mistrals Modellen haben einen etwas älteren Stichtag, aber das wird zunehmend zu einem kleineren Problem. Beide Unternehmen bieten mittlerweile Modelle an, die Live-Websuchen durchführen können, um Ihnen die neuesten Informationen zu liefern.

API und Entwickler-Ökosysteme

Beide Plattformen bieten eine ziemlich reibungslose Erfahrung für Entwickler. Googles Vertex AI ist eine riesige, unternehmenstaugliche Plattform mit einer großen Werkzeugkiste, vielen Integrationen und detaillierter Dokumentation für die Entwicklung mit Gemini.

Mistrals API, die sie „la Plateforme“ nennen, erhält viel Lob dafür, dass sie einfach und leicht zu bedienen ist, was zu ihrer entwicklerfreundlichen Haltung passt. Sie ist so konzipiert, dass der Einstieg einfach ist und Sie schnell loslegen können.

Gemini vs. Mistral: Preisgestaltung und Geschäftsanwendung

Am Ende des Tages läuft die Entscheidung oft auf Geld und Geschäftswert hinaus. Schauen wir uns an, wie ihre Preisgestaltung aussieht und wie Sie diese Modelle tatsächlich in Ihrem Unternehmen einsetzen können, ohne ein ganzes neues Ingenieurteam einstellen zu müssen.

Eine Aufschlüsselung der Preismodelle

Beide Unternehmen verwenden für ihre APIs hauptsächlich ein Pay-per-Token-Modell. Ihnen wird die Menge an Text berechnet, die Sie an das Modell senden (Input), und die Menge an Text, die das Modell zurückgibt (Output).

- Gemini (über Vertex AI): Googles Preisgestaltung ist ziemlich wettbewerbsfähig, insbesondere für sein schnelles Flash-Modell.

Quelle: Google Cloud Pricing Page

| Modell | Preis Input / 1 Mio. Token | Preis Output / 1 Mio. Token |

|---|---|---|

| Gemini 1.5 Pro | 3,50 $ | 10,50 $ |

| Gemini 1.5 Flash | 0,35 $ | 1,05 $ |

- Mistral: Mistrals API-Preise sind ebenfalls wettbewerbsfähig, und ihre kleineren, effizienten Modelle sind besonders budgetfreundlich.

Quelle: Mistral AI Website

| Modell | Preis Input / 1 Mio. Token | Preis Output / 1 Mio. Token |

|---|---|---|

| Mistral Large 2 | 3,00 $ | 9,00 $ |

| Mistral Small | 0,50 $ | 1,50 $ |

| Codestral | 1,00 $ | 3,00 $ |

Mistral hat auch ein „Le Chat Pro“-Abonnement für etwa 15 US-Dollar pro Monat, das sich an Einzelpersonen und kleine Teams richtet, die ihren Chatbot ohne den Umgang mit der API nutzen möchten.

KI-Modelle in Ihrem Unternehmen anwenden: Der einfache Weg

Ein Modell auszuwählen und für den API-Zugang zu bezahlen, ist nur der erste Schritt. Die eigentliche Arbeit besteht darin, diese rohe Kraft in ein nützliches Geschäftswerkzeug zu verwandeln, wie zum Beispiel einen Kundensupport-Agenten, der den Leuten tatsächlich hilft. Dies erfordert normalerweise eine Menge komplizierter Einrichtung:

-

Sie müssen das Modell mit dem gesamten Wissen Ihres Unternehmens verbinden, das möglicherweise über einen Helpdesk, interne Wikis, Google Docs und alte Konversationen verteilt ist.

-

Sie müssen eine Workflow-Engine erstellen, die weiß, wann ein Ticket eskaliert werden muss, wie es korrekt zu kennzeichnen ist oder wann benutzerdefinierte Aktionen wie die Überprüfung eines Bestellstatus erforderlich sind.

-

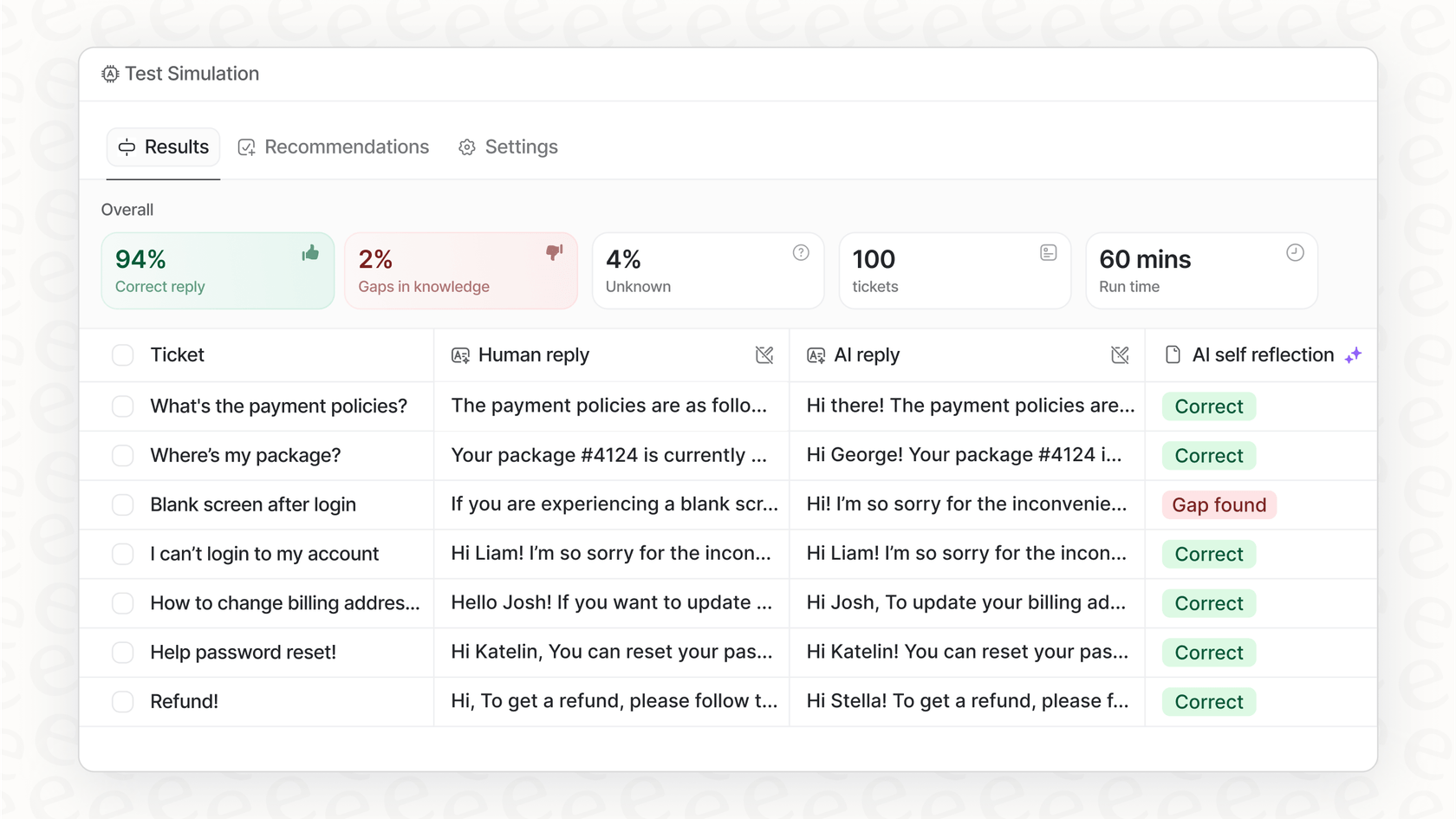

Sie benötigen eine sichere Möglichkeit, alles mit Ihren eigenen Daten zu testen, bevor Sie es jemals mit einem echten Kunden sprechen lassen.

Das ist eine Menge schwerer Arbeit, und genau dieses Problem löst eine Plattform wie eesel AI. Anstatt Monate damit zu verbringen, diese ganze Infrastruktur von Grund auf neu zu erstellen, bietet Ihnen eesel AI eine Self-Service-Lösung, die die harte Arbeit für Sie erledigt. Es fungiert als intelligente Schicht über leistungsstarken Modellen von Google und Mistral und macht sie sofort für Ihr Unternehmen nutzbar.

- Sofortige Wissensvereinheitlichung: eesel AI verbindet sich mit all Ihren Tools durch Ein-Klick-Integrationen für Plattformen wie Zendesk und Confluence. Es lernt von Ihrem Help Center, Ihren Dokumenten und sogar Ihren vergangenen Support-Tickets, um sich vom ersten Tag an in Ihr Geschäft einzuarbeiten.

Die richtige Wahl für Ihre Bedürfnisse treffen

Also, was ist das endgültige Urteil im Duell Gemini vs. Mistral? Ehrlich gesagt gibt es keinen einzigen Gewinner. Es hängt alles davon ab, was Sie erledigen müssen. Hier ist eine kurze Übersicht:

-

Entscheiden Sie sich für Gemini, wenn Ihre Hauptaufgabe die Analyse riesiger Dokumente oder Datensätze ist, wenn Sie bereits in das Google Cloud-Ökosystem integriert sind oder wenn Sie erstklassiges kreatives Schreiben und multimodale Funktionen benötigen.

-

Entscheiden Sie sich für Mistral, wenn Ihnen Effizienz, Kosten und die Flexibilität von Open-Source-Modellen, die Sie selbst hosten können, am wichtigsten sind. Es ist wahrscheinlich auch die bessere Wahl, wenn Sie eine KI benötigen, die Ihnen prägnante, geschäftsreife Antworten ohne zusätzlichen Schnickschnack liefert.

Das beste Modell ist immer das, das zur Aufgabe passt. Aber denken Sie daran, das Modell selbst ist nur ein Teil des Puzzles. Die wahre Magie entsteht, wenn Sie es in Ihre Arbeitsabläufe integrieren und nutzen, um tatsächliche Geschäftsprobleme zu lösen.

Sind Sie bereit, die Leistung dieser erstklassigen KI-Modelle in echte Geschäftsergebnisse umzuwandeln? eesel AI bietet Ihnen die komplette Plattform, um KI-Agenten für den Kundensupport und internes Wissen zu erstellen, zu simulieren und zu starten – alles mit nur wenigen Klicks. Starten Sie noch heute Ihre kostenlose Testversion.

Dieses Video bietet einen hilfreichen direkten Vergleich, um zu sehen, wie Gemini und Mistral AI bei verschiedenen Aufgaben abschneiden.

Häufig gestellte Fragen

Mistral-Modelle werden oft wegen ihrer Direktheit und "schnörkellosen" Antworten bevorzugt, was sie ideal für Geschäftsworkflows macht, die zuverlässige und prägnante Antworten ohne zusätzliches gesprächiges Füllmaterial benötigen.

Gemini 1.5 Pro hat hier einen klaren Vorteil aufgrund seines riesigen 2-Millionen-Token-Kontextfensters, das es ihm ermöglicht, weitaus mehr Informationen aufzunehmen und zu analysieren als die aktuellen Angebote von Mistral.

Mistrals kleinere, effiziente Modelle bieten wettbewerbsfähige Preise für Aufgaben mit hohem Volumen. Auch das 1.5-Flash-Modell von Gemini bietet eine sehr kostengünstige Option für Geschwindigkeit und Effizienz.

Mistral AI ist bekannt für seine Open-Weight-Modelle wie Mistral 7B und Mixtral, die Entwicklern die Flexibilität bieten, sie auf ihren eigenen Servern zu hosten, zu modifizieren und feinabzustimmen.

Gemini glänzt oft bei kreativen Aufgaben und bietet einen gesprächigeren und gründlicheren Stil, der sich für Marketingtexte, Brainstorming und die Erstellung von Texten eignet, die sich nuanciert und menschlich anfühlen.

Obwohl beide APIs anbieten, erfordert die effektive Integration von Modellen wie Gemini oder Mistral oft erhebliche Entwicklungsarbeit. Plattformen wie eesel AI vereinfachen dies, indem sie eine intelligente Schicht zur Wissensvereinheitlichung und zum schnellen Starten von KI-Agenten bereitstellen, unabhängig vom zugrunde liegenden Modell.

Diesen Beitrag teilen

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.