Seien wir ehrlich, generative KI fühlt sich ein bisschen wie Magie an. Man gibt eine Eingabe ein, und ein paar Sekunden später hat man eine E-Mail, ein Stück Code oder sogar eine ganze Website. Es ist nahtlos. Aber dieses "mühelose" Gefühl verbirgt ein ziemlich großes Geheimnis: Die Maschine hinter dem Vorhang ist unglaublich energiehungrig, und ihr Appetit wächst wie verrückt.

Mit der Veröffentlichung neuerer Modelle wie GPT-5 am Horizont beginnen Forscher, Alarm zu schlagen, wie viel Energie diese Dinge verbrauchen. Das ist nicht nur ein abstraktes Umweltproblem, es wird schnell zu einem echten Geschäftsproblem. Die versteckten Kosten für den Betrieb dieser massiven, alleskönnenden Modelle werden zu groß, um sie zu ignorieren.

In diesem Artikel werden wir den Vorhang über das "Was" und "Warum" der Energieanforderungen der KI lüften. Wir werden uns die tatsächlichen Umweltauswirkungen ansehen und Ihnen einen intelligenteren Weg zeigen, wie Ihr Unternehmen KI auf eine nachhaltige und weitaus effektivere Weise einführen kann.

Was ist der Energieverbrauch von ChatGPT?

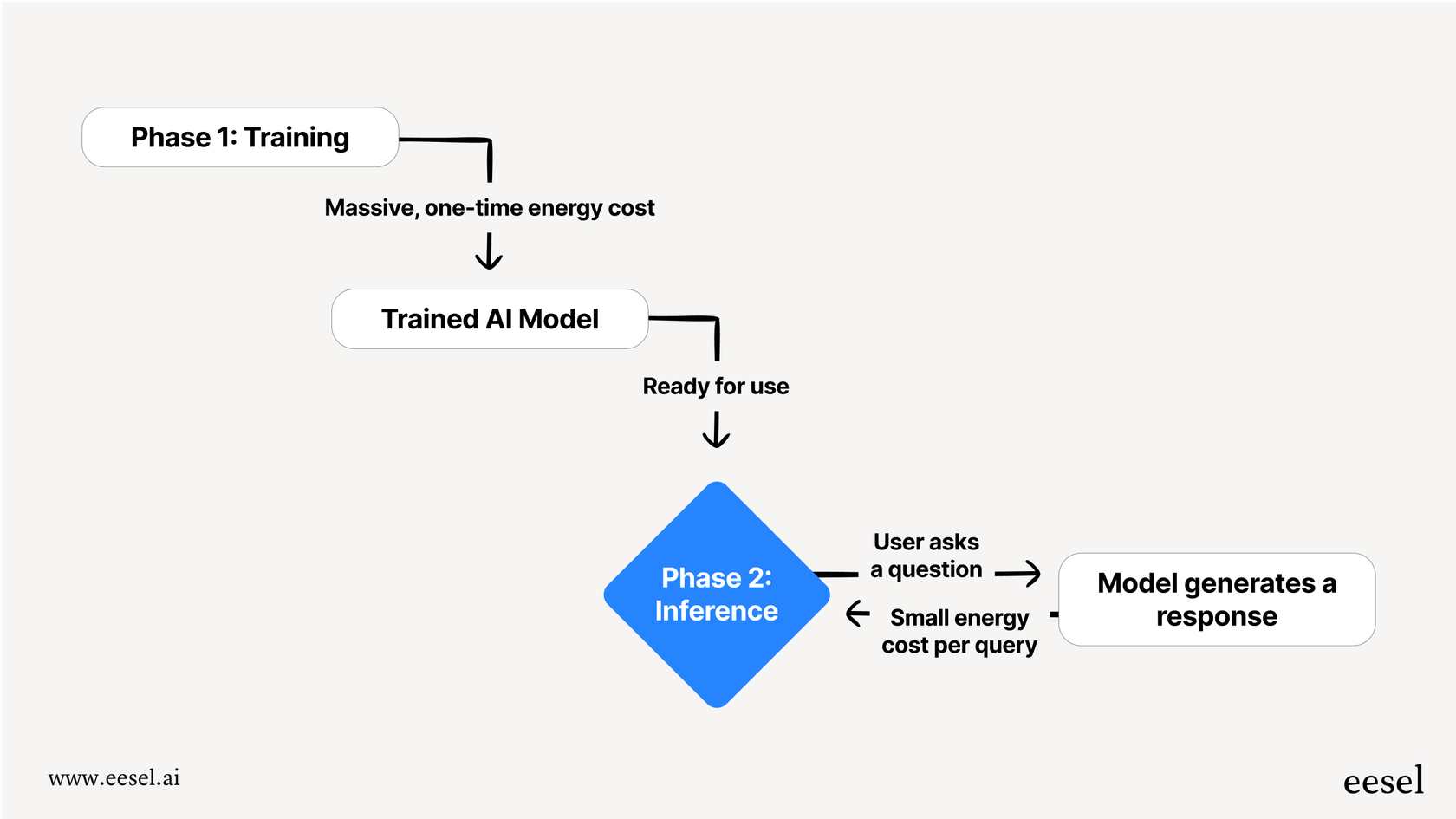

Wenn wir über eine KI sprechen, die Energie verschlingt, ist es nicht nur eine Sache. Der Prozess ist in zwei Hauptphasen unterteilt: Training und Inferenz. Der einfachste Weg, darüber nachzudenken, ist wie eine KI, die zur Schule geht, und dann eine KI, die tatsächlich zur Arbeit geht.

Training Dies ist die "Schulungs"-Phase der KI, und sie ist unglaublich intensiv. Es beinhaltet, einem Modell eine riesige Menge an Daten zuzuführen, oft einen großen Teil des Internets, damit es Muster, Sprache und Konzepte lernen kann. Dies erfordert eine enorme Menge an Rechenleistung, die rund um die Uhr für Wochen oder sogar Monate läuft. Es ist ein riesiger, einmaliger Energiekostenaufwand, der für jede neue Version eines Modells bezahlt werden muss.

Inference Inference ist das, was passiert, wenn Sie die KI tatsächlich nutzen, wie zum Beispiel ChatGPT eine Frage zu stellen. Das Modell nutzt das, was es während des Trainings gelernt hat, um die beste Antwort zu "erschließen". Während eine einzelne Anfrage nur einen winzigen Bruchteil der für das Training benötigten Energie verbraucht, ist es das schiere Volumen, das verblüffend ist. Für ein Tool, das täglich Milliarden von Anfragen bearbeitet, kann der gesamte Energieverbrauch für die Inferenz über seine Lebensdauer leicht die anfänglichen Trainingskosten übersteigen.

Ein genauerer Blick auf den überraschenden Energieverbrauch von ChatGPT

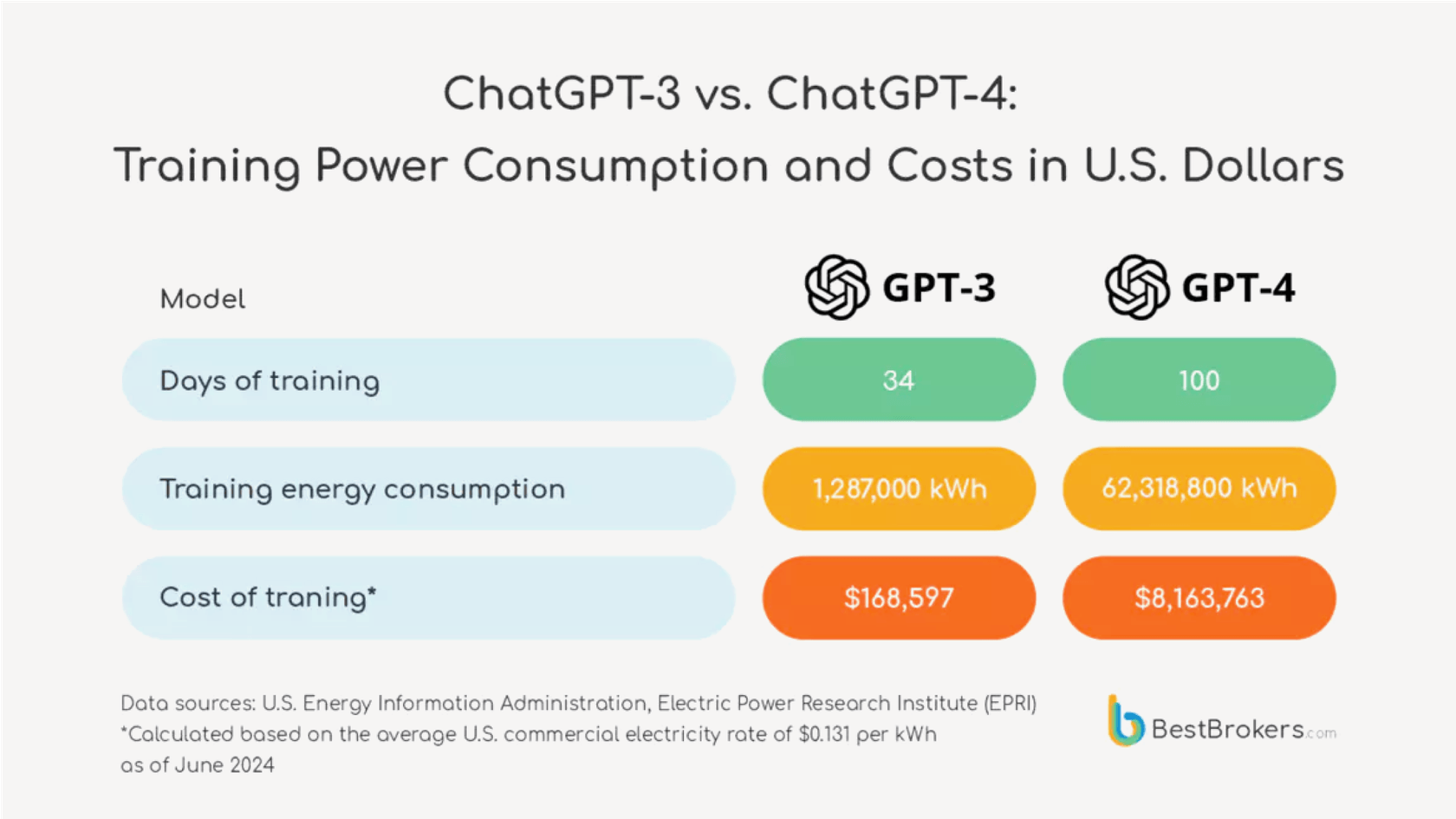

Der Sprung im Strombedarf von einer Modellgeneration zur nächsten ist kein kleiner Schritt, sondern ein riesiger Sprung.

Lassen Sie uns einige echte Zahlen dazu nennen. Mitte 2023 könnte das Anfordern eines einfachen Rezepts von einem Modell wie ChatGPT etwa 2 Wattstunden Strom verbraucht haben. Jetzt, mit Blick auf das kommende GPT-5, schätzen Forscher des AI-Labors der Universität von Rhode Island, dass das neue Modell durchschnittlich 18 Wattstunden für eine mittelgroße Antwort und manchmal bis zu 40 Wattstunden verbrauchen könnte.

Ein visueller Vergleich nebeneinander.

- Links, unter der Überschrift "GPT-4 (2023)", ein Symbol einer kleinen Glühbirne mit dem Text "2 Wattstunden pro Anfrage" daneben. Darunter steht: "Genug, um eine Glühbirne für 2 Minuten zu betreiben."

- Rechts, unter der Überschrift "GPT-5 (Geschätzt)", ein Symbol einer viel größeren, helleren Glühbirne mit dem Text "18 Wattstunden pro Anfrage" daneben. Darunter steht: "Genug, um dieselbe Glühbirne für 18 Minuten zu betreiben."

- Ein großer Pfeil, der von links nach rechts zeigt, zeigt einen "9x Anstieg" im Energieverbrauch. Das Gesamtdesign sollte sauber und leicht lesbar sein und den drastischen Anstieg des Strombedarfs betonen.

Das ist ein enormer Anstieg. Es zeigt, dass jede neue Generation dieser Alleskönner-Modelle exponentiell energiehungriger wird.

Um Ihnen ein wenig Perspektive zu geben, 18 Wattstunden reichen aus, um eine altmodische Glühbirne für 18 Minuten zu betreiben. Denken Sie jetzt an das größere Bild. Berichten zufolge bearbeitet ChatGPT täglich etwa 2,5 Milliarden Anfragen. Wenn all diese Anfragen von GPT-5 bearbeitet würden, könnte der gesamte tägliche Energieverbrauch ausreichen, um 1,5 Millionen US-Haushalte mit Strom zu versorgen. Plötzlich erscheint die "mühelose" KI-Antwort nicht mehr so kostenlos, oder?

| Modellversion | Durchschnittlicher Energieverbrauch pro Anfrage (Wattstunden) | Reale Entsprechung |

|---|---|---|

| GPT-4 Ära (2023) | ~2 Wh | Betrieb einer Glühbirne für 2 Minuten |

| GPT-4o | ~0,34 Wh (Altmans Angabe) | Eine energieeffiziente Glühbirne für ein paar Minuten |

| GPT-5 (Geschätzt) | ~18 Wh | Betrieb einer Glühbirne für 18 Minuten |

Geheimhaltung und versteckte Kosten des Energieverbrauchs von ChatGPT

Zu versuchen, die tatsächlichen Umweltkosten der KI herauszufinden, ist ein überraschend undurchsichtiges Geschäft, hauptsächlich weil die Unternehmen, die diese Modelle entwickeln, unglaublich geheimnisvoll darüber sind, wie viele Ressourcen sie verwenden.

Wo sind die offiziellen Daten zum Energieverbrauch von ChatGPT?

OpenAI und seine Konkurrenten haben seit der Veröffentlichung von GPT-3 im Jahr 2020 keine offiziellen, modellspezifischen Energiewerte mehr veröffentlicht. OpenAIs CEO, Sam Altman, teilte auf seinem Blog mit, dass eine Anfrage etwa 0,34 Wattstunden verbraucht, aber diese Zahlen kamen ohne jeglichen Kontext darüber, welches Modell er meinte oder ohne Daten, die dies untermauern, was sie praktisch unmöglich zu überprüfen macht.

Dieser Mangel an Transparenz ist ein großes Problem. Wie ein Klimaexperte betonte, "Es ist unglaublich, dass man ein Auto kaufen kann und weiß, wie viele Meilen pro Gallone es verbraucht, aber wir nutzen all diese KI-Tools jeden Tag und haben absolut keine Effizienzmetriken." Ohne klare Daten ist es für jedes Unternehmen schwierig, eine fundierte Entscheidung über die tatsächlichen Kosten der verwendeten Tools zu treffen.

Energieverbrauch von ChatGPT: Es geht um mehr als nur Strom

Der Umweltpreis geht weit über die Stromrechnung hinaus. Es gibt einige andere versteckte Kosten, die nicht annähernd genug besprochen werden.

- Es ist durstige Arbeit: Rechenzentren werden unglaublich heiß, und sie abzukühlen erfordert eine schockierende Menge an Frischwasser. Allein das Training von GPT-3 soll über 700.000 Liter Wasser verbraucht haben. Je größer die Modelle werden, desto größer wird ihr Wasserbedarf, was eine echte Belastung für lokale Ressourcen darstellt.

- Hardware und Elektroschrott: Generative KI läuft auf spezialisierten, energiehungrigen Prozessoren (GPUs). Die Herstellung dieser Chips hat ihren eigenen ökologischen Fußabdruck, von der Gewinnung der Rohstoffe bis zur Energie, die für ihre Herstellung benötigt wird. Das ständige Rennen um leistungsfähigere Hardware bedeutet auch, dass ältere Chips schneller ausgemustert werden, was zu einem riesigen Elektroschrottproblem beiträgt.

- Gebaut, um ersetzt zu werden: Die KI-Welt bewegt sich in rasantem Tempo. Neue Modelle werden alle paar Monate veröffentlicht, wodurch die alten fast über Nacht obsolet werden. Das bedeutet, dass die enorme Menge an Energie, die in das Training eines Modells gesteckt wurde, das so schnell ersetzt wird, im Wesentlichen verschwendet ist.

Ein klügerer Weg nach vorne: Effizienz jenseits des hohen Energieverbrauchs von ChatGPT

Die aktuelle Strategie, einfach immer größere Allzweck-KI-Modelle zu bauen, ist ein Ansatz mit roher Gewalt. Er ist nicht nachhaltig, und für die meisten Unternehmen ist er nicht einmal das beste Werkzeug für die Aufgabe.

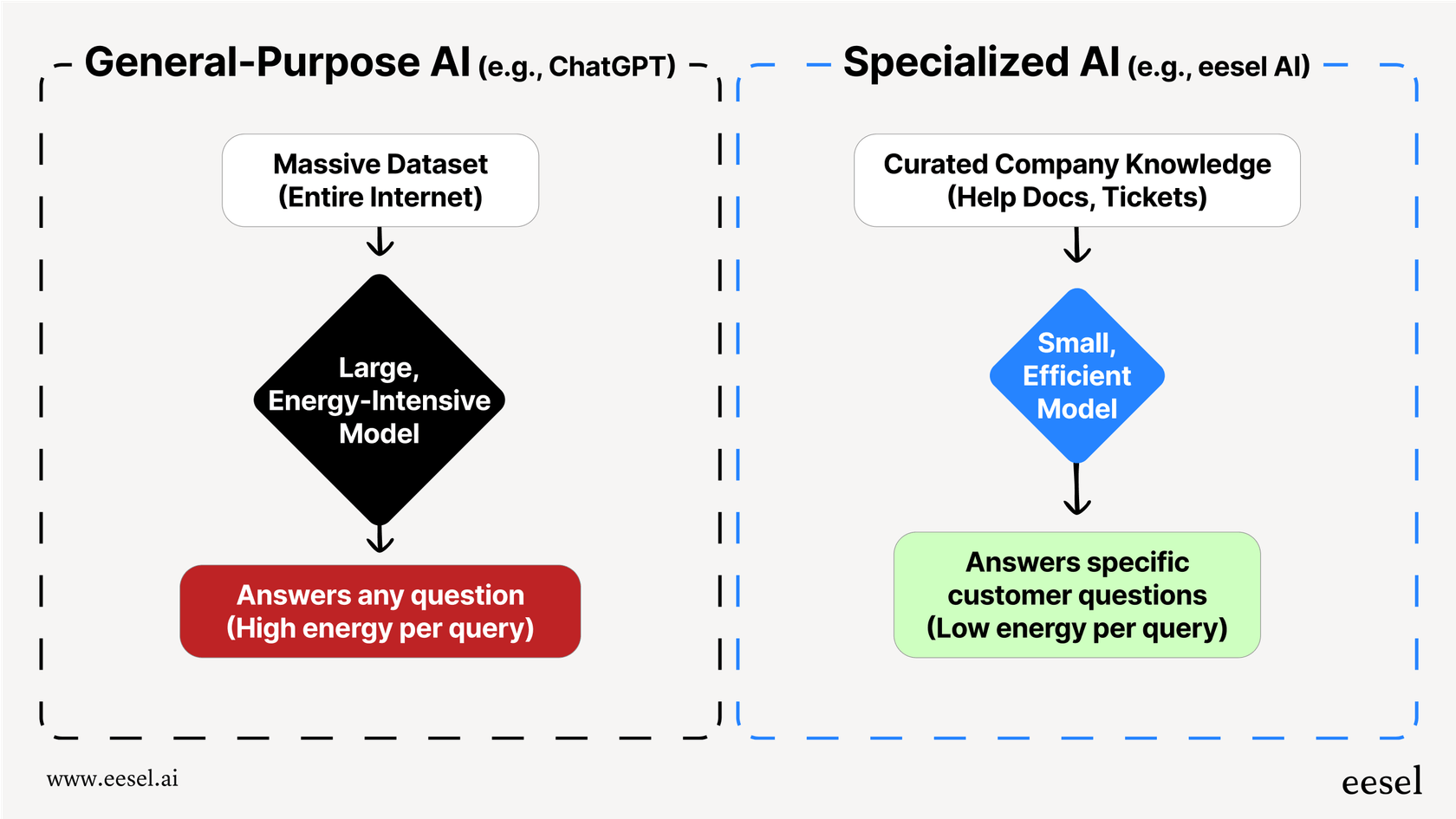

Das Problem ist, dass Modelle wie ChatGPT darauf ausgelegt sind, ein bisschen über alles zu wissen, von Shakespeare-Sonetten bis zur Quantenphysik. Um das zu tun, müssen sie enorm sein, was sie unglaublich energieintensiv macht. Aber wenn Sie nur die Frage eines Kunden zu Ihrer Versandrichtlinie beantworten müssen, ist die Verwendung einer massiven allgemeinen KI völlig übertrieben. Es ist, als würde man einen Supercomputer verwenden, um einfache Mathematik zu machen, es ist einfach nicht effizient.

Es gibt einen viel klügeren Weg, dies zu tun: die Verwendung von kleineren, spezialisierten KI-Modellen, die nur auf den Daten trainiert werden, die sie für ihre Aufgabe benötigen. Dieser Ansatz ist von Natur aus viel effizienter. Eine KI auf einer kuratierten Sammlung von Hilfeartikeln Ihres Unternehmens, vergangenen Support-Tickets und Produktdokumentationen zu trainieren, erfordert nur einen winzigen Bruchteil der Energie, die benötigt wird, um sie auf dem gesamten Internet zu trainieren.

Das Ergebnis ist nicht nur eine nachhaltigere KI, sondern auch eine bessere. Eine spezialisierte KI gibt Antworten, die genauer, konsistenter und perfekt markengerecht sind, weil sie nicht durch irrelevante Informationen von öffentlichen Websites abgelenkt wird.

Das ist die ganze Idee hinter dem, was wir bei eesel AI tun. Anstatt Sie zu bitten, Ihre bestehenden Systeme herauszureißen und durch eine einzige, energiehungrige KI zu ersetzen, integriert sich eesel direkt in Ihr Helpdesk und Ihre Wissensquellen. Es lernt aus Ihren Inhalten in den Tools, die Sie bereits verwenden, wie Zendesk, Confluence und Google Docs, um einen effizienten und genauen KI-Support-Agenten zu erstellen. Dies ermöglicht es Ihnen, den massiven Energieverbrauch und die betrieblichen Kopfschmerzen eines allgemeinen Modells zu überspringen und gleichzeitig bessere, relevantere Antworten für Ihre Kunden zu liefern.

Ihre KI-Strategie und die Auswirkungen des Energieverbrauchs von ChatGPT

Der Energieverbrauch großer KI-Modelle ist nicht mehr nur ein Thema für Forscher, sondern ein echtes Geschäftsproblem. Mit jeder neuen Generation werden Modelle wie GPT-5 exponentiell energiehungriger, und ihre tatsächlichen Kosten sind hinter einer Mauer der Geheimhaltung verborgen und umfassen weit mehr als nur Strom.

Für die meisten geschäftlichen Bedürfnisse, insbesondere im Kundendienst oder internen Support, ist die Verwendung einer riesigen, allgemeinen KI nicht die effektivste oder verantwortungsvollste Wahl. Es ist ineffizient, teuer und liefert oft weniger genaue Antworten für Ihren spezifischen Anwendungsfall.

Ein spezialisierter, integrierter Ansatz ist eine weitaus nachhaltigere, kostengünstigere und präzisere Alternative. Indem Sie eine KI auf Ihr eigenes Wissen trainieren, können Sie ein System aufbauen, das sowohl leistungsstark als auch effizient ist.

Wenn Sie bereit sind, ein leistungsstarkes und effizientes KI-Support-System ohne die massiven Energiekosten aufzubauen, sehen Sie, wie eesel AI mit Ihren vorhandenen Tools arbeitet, um genaue, markengerechte Antworten zu liefern. Starten Sie eine kostenlose Testversion oder buchen Sie eine Demo noch heute.

Häufig gestellte Fragen

Der hohe Energiebedarf signalisiert Ineffizienz. Ein massives, allgemeines Modell für eine spezifische geschäftliche Aufgabe zu nutzen, ist wie einen Supercomputer für einfache Mathematik zu verwenden – es ist übertrieben und führt oft zu weniger genauen, langsameren Ergebnissen für Ihre spezifischen Bedürfnisse.

Es geht um weit mehr als nur um Strom. Der gesamte ökologische Fußabdruck umfasst einen massiven Wasserverbrauch zur Kühlung von Rechenzentren, die Ressourcen, die zur Herstellung spezialisierter Hardware benötigt werden, und ein wachsendes Problem mit Elektroschrott, da ältere Technologie schnell ersetzt wird.

Ja, der Anstieg ist erheblich. Schätzungen zufolge können neuere Modelle exponentiell energiehungriger sein, wobei einige Anfragen fast zehnmal so viel Strom wie frühere Versionen verbrauchen. Dieser Trend "größer ist besser" ist nicht nachhaltig.

Große KI-Unternehmen sind sehr geheimnisvoll in Bezug auf ihren Ressourcenverbrauch und behandeln ihn wie ein Geschäftsgeheimnis. Diese mangelnde Transparenz erschwert es Unternehmen und Verbrauchern, die wahren ökologischen und finanziellen Kosten der von ihnen genutzten Werkzeuge zu verstehen.

Absolut. Ein spezialisiertes Modell wird nur mit Ihren relevanten Unternehmensdaten trainiert, was nur einen winzigen Bruchteil der Energie erfordert. Dies führt zu einem viel effizienteren System, das nicht nur nachhaltig ist, sondern auch genauere und relevantere Antworten für Ihren spezifischen Anwendungsfall liefert.

Obwohl das Training unglaublich energieintensiv ist, kann das schiere Volumen der täglichen Anfragen (Inference) die anfänglichen Trainingskosten über die Lebensdauer des Modells leicht übersteigen. Für ein Tool mit Milliarden von täglichen Nutzern wird der kumulative Energieverbrauch für Inference zum dominierenden Faktor.

Diesen Beitrag teilen

Article by

Stevia Putri

Stevia Putri is a marketing generalist at eesel AI, where she helps turn powerful AI tools into stories that resonate. She’s driven by curiosity, clarity, and the human side of technology.